Ich sag’s gleich vorweg: Das wird mal wieder lang – aber wenn man zu dem Thema fundiert etwas sagen will, kommt man an ein paar Hintergründen nicht vorbei, und der Artikel ist durchaus auch mal zum späteren Nachlesen und zum Weitergeben an verunsicherte oder sonstwie besorgte Zeitgenossen gedacht. So richtig viel Fundiertes gibt es zu dem Thema ja noch nicht, auch wenn ich gerade sehe, dass mir der sehr geschätzte Physikerkollege Florian Aigner mit einem Artikel um ein paar Stunden zuvorgekommen ist, den ich als Ergänzung und etwas kürzere Zusammenfassung ebenfalls empfehle.

Panikmache auf rechtsesoterischen Verschwörungsseiten

Wenn man auf Youtube das Stichwort „5G Strahlung“ in die Suchfunktion eingibt, kann man gleich unter den ersten Suchergebnissen den Eindruck gewinnen, der zukünftige 5G-Mobilfunkstandard brächte eine Form von Killerstrahlung mit sich, die in der Lage sein müsste, ganze Landstriche zu entvölkern.

„WARNUNG vor 5G !!!!!!!!!!!!!!!!!!!!!Wollen sie uns Kochen??Strahlung im Microwellenbereich!!!“ ist dort zu lesen, „Dringender Weckruf: 5G ist Gefahr für Leib und Leben!“ sowie „5G=Globaler „MIKROWELLEN- HERD“ OHNE ENTRINNEN- Alle 200m ein Sender!“. „5G kommt! Verstrahlt im Namen der NWO!“[neue Weltordnung] titelt ein selbsternannter „Freund der Wahrheit“ in seinem Videokanal, und gleich der erste Kommentator erklärt darunter: „Das 5G ist ein Mikrowellenwaffensystem. Diese Strahlen werden uns geistig und körperlich völlig zerstören.“

Der überwiegende Teil der Youtube-Kanäle, die diese Videos und Schlagzeilen verbreiten, gehört zu dem üblichen, sich regelmäßig gegenseitig referenzierenden Netzwerk von Seiten, die für Verschwörungsmythen, rechte Propaganda, antisemitische Anfeindungen gegen jüdische Unternehmer, Hetze gegen Flüchtlinge sowie Werbung für abstruse Pseudomedizin bekannt sind. Eine ganze Reihe von 5G-Videos dieser Art kommt von Ivo Saseks Klagemauer.tv. Darin findet sich auch das in diversen Videos dieser Art verbreitete Märchen, bei einem 5G-Test (den es dort gar nicht gab) seien in Den Haag tote Vögel vom Himmel gefallen. In anderen Videos solidarisiert sich der Kanal mit Rechtsextremen, erklärt gemäß klassisch antisemitischem Verschwörungsdenken den Kommunismus zum Ziehkind der „Hochfinanz“ (wobei im Zielpublikum jedem klar sein dürfte, dass damit die Juden gemeint sind) und den islamistischen Anschlag von Straßburg zu einer Inszenierung der französischen Regierung. Die Flüchtlingskrise ist für Klagemauer.tv eine vom jüdischen Unternehmer George Soros eingefädelte „Verschwörungstatsache“. Sasek, der selbst in der Schweiz schon wegen Holocaustleugnung und Rassendiskriminierung angeklagt war, hatte 2012 auf seiner Antizensurkonferenz Sylvia Stolz, der ehemaligen Anwältin der Holocaustleugner Ernst Zündel und Horst Mahler, einen Vortrag ermöglicht, den er anschließend sichtlich gerührt bejubelte. Für eben diesen Auftritt ist Sylvia Stolz inzwischen selbst in Deutschland wegen Holocaustleugnung zu einer Haftstrafe ohne Bewährung verurteilt worden.

Auf bewusst.tv agitiert gegen 5G der dortige Stammmoderator Jo Conrad, der auch schon als Veranstalter von Reichsbürgerkonferenzen in Erscheinung getreten ist. Selbstverständlich darf auch der ehemalige Greenpeace-Aktivist Werner Altnickel nicht fehlen, der sonst inzwischen lieber über Chemtrails fabuliert, Reichsbürgerideologie verbreitet und stolz darauf zu sein scheint, wenn er zur rechten Szene gezählt wird:

In einigen Fällen ist der Hintergrund der Panikmache klar, wenn zum Beispiel unter der Schlagzeile „Angriff auf unsere Zirbeldryse durch Fluorid & 5G Strahlung!“ Enrico Edinger, der sich inzwischen als Prof.* Dr. nauk* Dr. med. bezeichnet, für den Kauf windiger Nahrungsergänzungsmittel wirbt. Im gleichen Video erklärt Edinger übrigens auch: „Elektroautos sind Mord für den Menschen. Also, auch von der Tumorbildung her.“

Besonders bizarr ist ein Video des Kanals mit dem vertrauenerweckenden Namen Extremnews. Es trägt den Titel „Medienwissenschaftler: Warum 5G hochgefährlich ist“. Inwiefern die Medienwissenschaft, die die Massenkommunikation aus geistes- und kulturwissenschaftlicher Perspektive untersucht, jemanden dazu befähigen soll, Aussagen über die medizinische Wirkung elektromagnetischer Wellen zu machen, erschließt sich mir nicht. Lustig wird es, wenn man bemerkt, dass der angekündigte Medienwissenschaftler niemand anders ist als Harald Kautz-Vella. Kautz-Vellas abstruse Phantastereien hat selbst der bereits erwähnte Werner Altnickel in einem Interview schon mit den Worten kommentiert: „Wenn unsere Gegner das zitieren, stehen wir vielleicht insgesamt als Idioten da.“ Im Bemühen, in Esoterik und Verschwörungsglauben irgendwie wahrgenommen zu werden, treibt Kautz-Vella alle paar Jahre eine neue Sau durchs Dorf. Der goldene Aluhut hat ein paar witzige Zitate aus der Zeit zusammengetragen, als Kautz-Vella sich primär über die vermeintliche Hautkrankheit Morgellons positionierte – bei der es sich in Wirklichkeit meist um eine Wahnvorstellung handelt. Mein Lieblings-Kautzvellismus ist allerdings Black Goo, ein schwarzes Wunderöl, das von Außerirdischen auf die Erde gebracht worden sein und eine eigene Intelligenz und ein Bewusstsein haben soll.

Wenn das Thema in diesem Umfeld von Antisemitismus, Pseudomedizin und Verschwörungshetze bliebe, müsste man sich möglicherweise nicht so sehr aufregen. Bedauerlicherweise schwappt es von dort immer wieder in die Mainstreammedien herüber, und zwar in erschreckend ähnlichem Tonfall, und häufig auch mit ähnlicher Faktenbasis.

Die gleiche Panikmache in Mainstreammedien

„Strahlendes Experiment“ überschreibt die Zeit einen Artikel, in dem die entscheidende Aussage über Mobilfunk irgendwo im Kleingedruckten untergeht: „Hunderte Studien konnten bisher nicht nachweisen, dass eine Gesundheitsgefahr von diesen elektromagnetischen Feldern (EMF) ausgeht.“ Die angeblich noch unbekannten Risiken, mit denen laut Zeit an der Bevölkerung experimentiert wird, finden sich fast identisch in der Rede des AfD-Abgeordneten Peter Felser am 4. April 2019 im Bundestag: „Uns muss doch klar sein, dass wir noch überhaupt keine Langzeitrisiken dieser Technologien abschätzen können. Wir sind mit diesen Funkstrahlen in einem riesigen Feldexperiment.“ Der Tagesspiegel folgt eher dem Tonfall der Online-Verschwörungshetzer als dem der AfD und behauptet: „Europas Regierungen ignorieren die Gefahr.“ Wie die Zeit verlinkt auch der Tagesspiegel eine der typischen Unterschriftslisten von Elektrosmoggegnern und bezeichnet die Unterzeichner der Einfachheit halber als Wissenschaftler. Ein genauerer Blick auf die beiden Listen zeigt die zum Teil identischen üblichen Verdächtigen aus der Elektrosmogszene, Hausärzte, Naturheiler, Homöopathen und Mitglieder selbsternannter „Kompetenzinitiativen“. Die von der Zeit verlinkte Liste ist neben der Redakteurin des „ElektrosmogReport“ und Harald Walach, dem Erfinder der „schwachen Quantentheorie“ auch vom Quantenesoteriker Ulrich Warnke unterschrieben, zu dem ich einiges in der Neuauflage des Quantenquark-Buchs geschrieben habe. Auf beiden Listen als Wissenschaftler aufgeführt ist Florian M. König, der lustige Elektrosmog-Schutzprodukte zum Einbau in die Stromleitung verhökert und sich dabei auf wissenschaftliche Kapazitäten wie den angeblichen Reichsflugscheibenentwickler Viktor Schauberger und den Orgon-Phantasten Wilhelm Reich beruft.

Der Sender rbb schreibt gleich „Forscher fordern Abbruch des 5G-Testlaufs in Berlin.“ Der Link des rbb über die Forderung der „Forscher“ führt auf das Elektrosmog-Gläubigen-Portal „diagnose:funk“, wo dann die nächste Unterschriftenliste angeblicher Wissenschaftler verlinkt ist. Die hier wenigen deutschen Unterzeichner kennt man überwiegend schon von den beiden anderen Listen – König und Warnke sind auch wieder mit von der Partie. Der wichtigste Experte des rbb-Artikels ist Franz Adlkofer, der mit der Aussage zitiert wird, Mobilfunkstrahlung sei „mit hoher Wahrscheinlichkeit gesundheitsschädlich“. Der frühere Lobbyist für die Tabakindustrie Adlkofer war um 2000 herum Koordinator einer Studie, die Mobilfunk mit Krebs in Verbindung brachte und die nach einer Serie von Datenfälschungsskandalen inzwischen völlig diskreditiert ist. Der rbb erwähnt Adlkofers fragwürdige Vergangenheit nicht, sondern schreibt über ihn nur, er untersuche „seit Jahren, wie sich Mobilfunkstrahlen auf die Gesundheit der Menschen auswirken.“ Außer beim rbb ist Adlkofer gern gesehener Gast beim Verschwörungsmythenkanal KenFM und beim offiziellen Propagandaportal der russischen Regierung RT Deutsch.

Grundlegendes zur Wirkung elektromagnetischer Wellen

Nun kann sich eine mehr oder weniger wissenschaftliche These ihre Anhänger ja nicht aussuchen, und es wäre im Prinzip denkbar, dass die Mobilfunkstrahlung wenigstens der neuen 5G-Technik doch irgendwie gefährlich ist, trotz der fragwürdigen Vertreter, die diese Gefährlichkeit behaupten. Wie plausibel ist eine solche Schädlichkeit also aus physikalischer Sicht? Werfen wir dazu erst einmal einen Blick darauf, wie elektromagnetische Wellen überhaupt auf biologisches Material wirken können. Dass das je nach der Wellenlänge unterschiedlich ist, hängt tatsächlich mal mit der Quantenphysik zusammen. Wer im Quantenquark-Buch das Kapitel zur Entstehung der Quantenmechanik gelesen hat, hat daher für die folgenden Absätze schon einmal einen kleinen Vorsprung.

Nachtrag 18.5.2020:

Inzwischen habe ich eine wunderbares kleines Erklärvideo von Prof. Lemeshko gefunden, das ich sehr empfehlen kann, sozusagen als kleine Abkürzung zu meinen folgenden Erläuterungen bis zur Zwischenüberschrift „Was ist eigentlich 5G“.

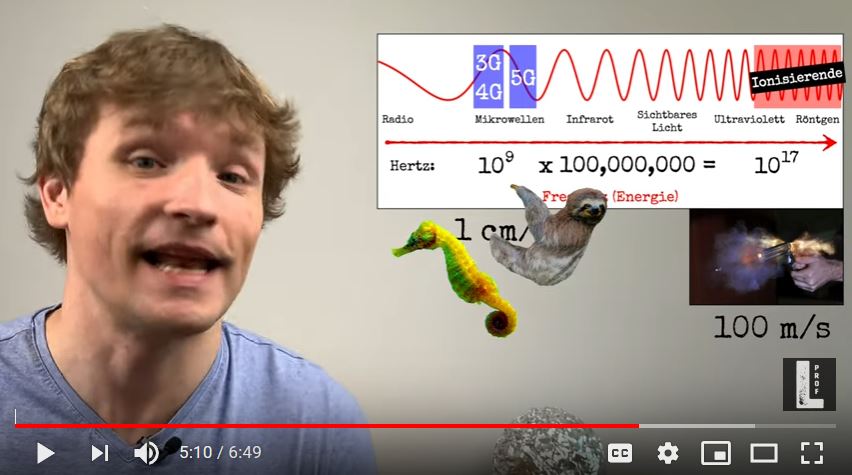

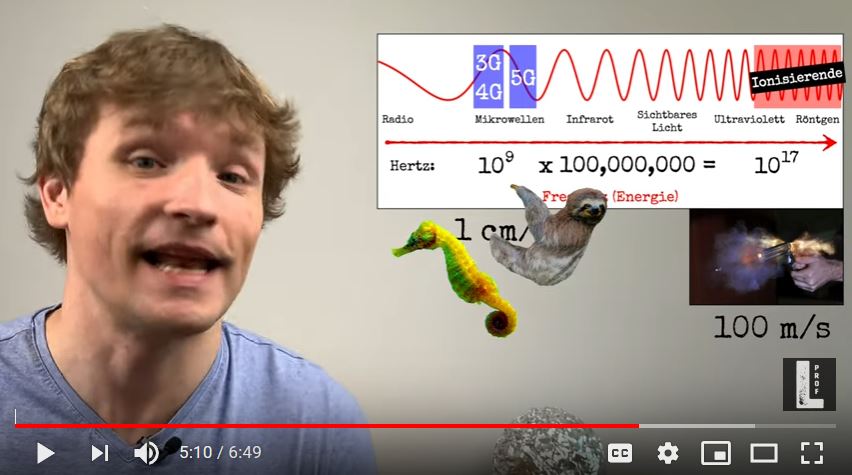

Nach dem 1900 entdeckten Planckschen Strahlungsgesetz bestehen Wellen aus winzigen Energiepaketen, die als Quanten oder, im konkreten Fall elektromagnetischer Wellen, als Photonen bezeichnet werden. Je höher die Frequenz, mit der die Welle schwingt, je kürzer also die Wellenlänge, desto größer ist die Energie des einzelnen Photons. Mit Einsteins Berechnung des Photoeffekts aus dem Jahr 1905 ist auch klar, dass ein solchen Photon seine Energie immer auf genau ein geladenes Teilchen (also ein Elektron oder ein Proton) überträgt, mit dem es zusammentrifft. Dasselbe Elektron wird danach in der Regel nicht noch ein zweites Photon derselben Energie absorbieren. Es ist also ein entscheidender Unterschied, ob eine Energiemenge in einem Photon oder auf mehrere Photonen verteilt übertragen wird.

Ionisierende Strahlung

Reicht die Energiemenge eines Photons aus, um ein Elektron vollständig aus seinem Atom, Molekül oder Kristallgitter herauszuschleudern, dann bleibt der Rest des Atoms oder Moleküls als positiv geladenes Ion übrig. Man spricht dann von ionisierender Strahlung. Dabei können auch ansonsten sehr stabile chemische Bindungen zerstört werden. Passiert das im Erbgut einer lebenden Zelle, dann kann das mit sehr geringer Wahrscheinlichkeit (meistens ist die beschädigte Stelle im Erbgut für die Zelle gar nicht relevant, oder sie ist lebenswichtig und die Zelle stirbt einfach) dazu führen, dass die Zelle sich unkontrolliert vermehrt und einen Tumor bildet. Daher kann ionisierende Strahlung Krebs auslösen oder bei der Fortpflanzung zu vermehrten Mutationen in der nächsten Generation führen. Da sich ein Tumor aus einer einzelnen Zelle entwickeln kann, kann wenigstens theoretisch jedes einzelne ionisierende Photon tödlich sein, wenn die körpereigenen Reparaturmechnismen versagen. Ionisierende Strahlung kann also tödlich sein, ohne dass man sie überhaupt bemerkt. Elektromagnetische Wellen sind ionisierend, wenn ihre Wellenlänge kürzer ist als die von sichtbarem Licht. Ionisierend und damit potentiell krebsauslösend sind also ultraviolettes Licht, Röntgenstrahlung und Gammastrahlung.

Das sichtbare Licht zusammen mit dem nahen Infrarot bildet eine Art Übergangsbereich: Es kann Elektronen nicht mehr aus einem Atom herauslösen, sie aber in angeregte Zustände versetzen und somit auch gewisse chemische Reaktionen auslösen – dadurch kann auch unser Auge das Licht wahrnehmen. Die Energie der Photonen des sichtbaren Lichts reicht aber schon nicht mehr aus, um stabile chemische Bindungen wie in der DNA unseres Erbguts zu verändern. Daher ist es auch nicht krebserregend.

Mikro- und Radiowellen

Bei noch größeren Wellenlängen, wie dem fernen Infrarot, den Mikrowellen und den Radiowellen, wird die Energie der einzelnen Photonen so klein, dass diese Quanten vollkommen bedeutungslos werden und die Welle nur noch als Ganzes messbare Energien übertragen kann. Die Energie kann daher nicht mehr auf einzelne Atome übertragen werden, so dass auch keine einzelnen chemischen Bindungen zerstört werden und die Wellen somit keinen Krebs auslösen können.

Schaden anrichten können solche Wellen dennoch, allerdings auf ganz andere Art: Nicht einzelne Photonen, sondern die Welle als ganzes kann elektrische Ladungen, auch innerhalb von großen Molekülen, in Schwingung versetzen. Die Schwingungen äußern sich dann im betreffenden Material als Wärme. In biologischem Material funktioniert das am stärksten in dem Frequenzbereich, in dem Wassermoleküle besonders gut schwingen, und genau dieser Effekt wird im Mikrowellenherd ausgenutzt. Im Prinzip passiert aber genau das gleiche (bei jeweils unterschiedlichen Eindringtiefen ins Material) über den gesamten Frequenzbereich vom Infrarot bis zu den Radiowellen. Werden Körperteile eines lebenden Organismus in dieser Form schneller erhitzt, als die Wärme zum Beispiel über den Blutkreislauf verteilt und aus dem Körper abgegeben werden kann, kann das zu Schäden bis hin zu Verbrennungen oder dem Tod führen. Das kann aber logischerweise kaum unbemerkt passieren, weil wir Temperaturveränderungen spüren. Ebenso kann eine geringfügige Erwärmung auch bei regelmäßiger Wiederholung nicht zu Schäden führen, weil der Körper seine Temperatur ohnehin ständig regeln muss, ob Wärme nun durch elektromagnetische Wellen, durch Wärmeleitung oder durch Verdunstung und Kondensation zugeführt oder abgegeben wird. Die Grenzwerte für Strahlungsintensitäten in diesem Frequenzbereich richten sich daher danach, dass eine eventuell ausgelöste Erwärmung von Körperteilen oder des ganzen Körpers keinen Schaden anrichten darf.

Niederfrequente Wechselfelder

Bei noch niedrigeren Frequenzen, die sich kaum noch sinnvoll als Wellenlänge ausdrücken lassen, spielt dann auch die Erwärmung keine Rolle mehr. Stattdessen führen solche niederfrequenten Wechselfelder in biologischem Material zu elektrischen Strömen. Bekanntermaßen können elektrische Ströme dem Menschen schaden. Allerdings sind dazu Stromstärken erforderlich, die weit über die Schwelle hinausgehen, bei der man die Ströme schon deutlich spüren kann. Solche Wechselfelder begegnen uns praktisch nur durch die 50-Hertz-Wechselspannung unseres Stromnetzes. Wenn man bei Regen unter einer Hochspannungsleitung läuft, kann es vorkommen, dass man die vom Wechselfeld der Leitung verursachten Ströme als Kribbeln wahrnimmt. Bei solchen Frequenzen richten sich die Grenzwerte für zulässige Feldstärken daher am Auftreten solcher unangenehmer Wahrnehmungen, auch wenn noch weitaus größere Intensitäten auftreten müssten, um echte Gesundheitsschäden auslösen zu können.

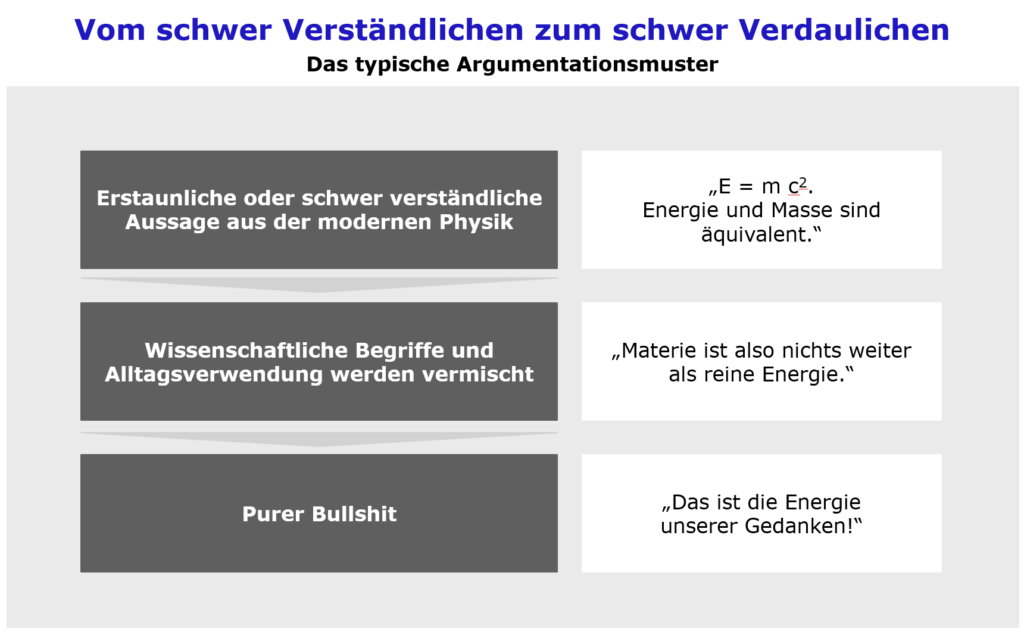

Nobelpreise, die offenbar niemand abholen will

Die genannten Effekte, Schwingung/Erwärmung und induzierte Ströme, sind die einzigen, die sich auf Basis der bekannten Physik und Chemie für nicht ionisierende elektromagnetische Wellen in biologischem Material ableiten lassen. Die unter anderem vom schon erwähnten Quantenesoteriker Warnke verbreitete Vorstellung, die DNA des Erbguts könnte von Mikrowellen so stark zum Schwingen gebracht werden, dass sie durchreißt, ergibt physikalisch auch keinen Sinn. Eine solche Schwingung wäre wieder nichts weiter als eine Erwärmung, und DNA ist weitaus hitzebeständiger als die meisten Eiweiße, die sie umgeben. Bevor eine Zelle durch ein von Mikrowellen verursachtes Zerreißen der DNA zur Tumorzelle werden könnte, wäre sie gargekocht und damit tot. Wer behauptet, durch Mikrowellen oder andere nicht ionisierende elektromagnetische Wellen könnten gesundheitliche Schäden anders als durch Überhitzung entstehen, müsste also zunächst einmal einen Wirkmechanismus erklären. Da dieser im Rahmen der Physik nicht existiert, wäre dafür bei entsprechendem Nachweis nicht nur der ohnehin fällige Nobelpreis für Medizin zu bekommen, sondern gleich auch noch einer für Physik. Bislang gibt es dafür keine Kandidaten, zumal die Vertreter der Elektrosmogszene in der Regel lieber panische Schlagzeilen verbreiten, als sich Gedanken darüber zu machen, wie die von ihnen behaupteten Gefahren eigentlich zustande kommen sollen.

Was genau ist eigentlich 5G

„5G“ bezeichnet zunächst einmal einfach die fünfte Generation mobiler Internetverbindungen. Die erste Generation wäre dabei die Datenübertragung über eine analoge mobile Sprechverbindung. Zur zweiten Generation gehören GPRS und EDGE, auf die Nutzer bei schlechter Verbindung heute noch öfters zurückgeworfen sind. Die dritte Generation mit UMTS, löste bei seiner Einführung den ersten großen mobile-Datenverbindungs-Hype aus und spülte in Deutschland im Jahr 2000 über die Versteigerung der Lizenzen zig Milliarden in die Kassen des Bundes. Die vierte Generation entspricht in Deutschland weitgehend dem seit 2010 eingesetzen LTE. Verändert haben sich zwischen den Generationen vor allem die Übertragungsprotokolle und die Art, wie Verbindungen auf nahe beieinanderliegende Frequenzen verteilt werden. Entsprechend haben sich auch die Antennen geringfügig verändert. An der grundlegenden Struktur der Netze hat sich vor allem beim letzten Schritt von UMTS zu LTE wenig verändert. Mit jeder neuen Generation haben sich aber die erreichbaren Datenraten vervielfacht, und das soll auch in der fünften Generation passieren.

Nun würde eine neue Generation von Übertragungsprotokollen auf ähnlichen Frequenzen wie bisher in einem weitgehend bestehenden Netz wahrscheinlich selbst hartgesottene Elektrosmog-Geschäftemacher kaum noch in Wallung bringen. Durch die Hintertür bringt 5G allerdings einige interessante technische Veränderungen mit sich, denn wenn der neue Standard überhaupt spürbare Vorteile bringen soll, muss eine ganz neue Nachfrage nach Datenübertragung entstehen.

Für heutige Smartphones ist die Datenübertragungsrate von LTE nämlich für alle praktischen Zwecke ziemlich ausreichend. Die höchsten Übertragungsraten, die die meisten User mit ihren Smartphones tatsächlich brauchen, fallen für das Streaming von hochauflösenden Videos an. Dafür braucht man 5G nicht, so dass Nutzer kaum bereit sind, für noch höhere Datenraten auch mehr zu bezahlen. Viele private Nutzer haben ohnehin Tarife, bei denen das monatliche Gesamtvolumen so begrenzt ist, dass Streaming für sie bestenfalls kurzzeitig in Frage kommt. Sie bezahlen also nicht einmal für die vollen Möglichkeiten der heutigen Technik.

Wollen die Anbieter mit ihrem neuen Standard also tatsächlich zusätzliche Einnahmen generieren – und das müssen sie, um dessen Einführung finanzieren zu können – dann muss durch neue Anwendungen ein neuer Bedarf entstehen. Erwartet wird dieser Bedarf vor allem durch das „Internet der Dinge“, also dadurch, dass immer mehr technische Geräte, die nicht primär der Kommunikation dienen, Daten versenden. Das Vorzeigebeispiel ist meist der Kühlschrank, der selbstständig die zur Neige gehenden Vorräte nachbestellt. Tatsächlich sind, wenn man die Kosten in den Griff bekommt, eine Unzahl von Anwendungen denkbar: Maschinen in Fabriken, die ihre Funktion an die Konzernzentrale melden, landwirtschaftliche Geräte, die beim Ernten schon die Mengen in der Mühle anmelden, Frachtstücke und Kühlbehälter, die ihren eigenen Transport überwachen, das Smart Home, das automatisch lüftet und heizt, wenn sich die Bewohner aus dem Urlaub nähern, Arzneimittel, die sich aus dem Arzneischrank melden, wenn ihr Verfallsdatum naht… Gerade die vielen Effizienzgewinne, die sich hier abzeichnen, lassen erwarten, dass private und geschäftliche Kunden bereit sein werden, dafür angemessen zu bezahlen. Die meisten dieser Geräte brauchen für sich genommen keine riesigen Datenraten, aber in der Summe sollte die übertragene Datenmenge dramatisch ansteigen.

Was aber vor allem ansteigt, ist die Anzahl der Endgeräte und damit der Verbindungen, und jede dieser Verbindungen braucht vereinfacht gesagt im Moment der Datenübertragung eine eigene Frequenz, auf der ein Gerät mit einer Basisstation kommunizieren kann, ohne dass ein anderes Gerät innerhalb der Reichweite auf derselben Frequenz dazwischenquakt. Das ist nur durch neue Übertragungsprotokolle nicht zu erreichen. Wenn 5G und das Internet der Dinge den Nutzen bringen sollen, den man sich von ihnen erwartet, brauchen sie deutlich mehr Frequenzen und deutlich mehr Basisstationen.

Arbeitet 5G auf ganz neuen Frequenzen?

Im Bereich der aktuell für den Mobilfunk genutzten Frequenzen zwischen 700 und 2600 MHz wird es allerdings langsam eng. Schon für UMTS und LTE hatte die Bundesnetzagentur zusätzliche Frequenzen freischaufeln müssen, die vorher teils dem Militär, teils dem DVB-T-Fernsehen vorbehalten waren. Im Frequenzplan sieht man, viel dürfte in diesem Bereich nicht mehr zu holen sein. Ein paar kleine Fenster könnte die Bundeswehr vielleicht noch abgeben, und ein paar könnte man effizienter nutzen, indem man die alten Mobilfunknetze abschaltet und die Frequenzen für 5G recyclet – aber dann würden natürlich auch die letzten noch verwendeten Nokia-Knochen nicht mehr funktionieren.

Für die ganz hohen Datenraten kann man physikalisch mit der Frequenz auch nicht sehr weit nach unten gehen: Übertragen werden die Daten ja über Veränderungen eines Funksignals. Damit die Frequenz dieses Signals überhaupt noch erkannt werden kann, muss die Frequenz, mit der es sich ändert (und damit die Bitrate der Datenübertragung), logischerweise deutlich kleiner sein. Daher lassen sich über höhere Sendefrequenzen mehr Daten übertragen. Gleichzeitig werden die Reichweite in unserer realen Umwelt, die Fähigkeit, Wände zu durchdringen oder sich um Hindernisse herumzukrümmen, mit höherer Frequenz immer schlechter. Auch die heutige Sende- und Empfangstechnik hat zu sehr hohen Frequenzen hin ihre Grenzen. Für die nächsten Jahre sind für 5G also neben Lücken bei 2000 MHz zunächst einmal Frequenzen zwischen 3400 und 3700 MHz vorgesehen.

Ist das die gefürchtete Mikrowellenstrahlung und die Nutzung dieser Frequenzen das „strahlende Experiment“, von dem die Zeit schreibt? Wohl kaum. Der angesprochene Bereich liegt genau zwischen den Frequenzen, die wir wir von heutigem Mobilfunk, von DECT, Bluetooth und dem unteren WLAN-Frequenzband kennen und dem oberen WLAN-Frequenzband bei 5000 MHz, von dem Sie mit hoher Wahrscheinlichkeit in ihrer Wohnung und an vielen Arbeitsplätzen umgeben sind. Neu und unbekannt ist diese Art von Strahlung also keineswegs. Natürlich handelt es sich um Mikrowellen – genau wie bei praktisch allen schnellen, drahtlosen Datenverbindungen, mit denen wir täglich zu tun haben.

Längerfristig ist aber auch absehbar, dass bei sehr vielen neuen Geräten mit Internetanbindung in einem kleinen Gebiet auch diese Frequenzen irgendwann nicht mehr ausreichen dürften. Höhere Frequenzen sind zunächst einmal durch Satellitenkommunikation, auch Satellitenfernsehen, sowie Radargeräte belegt, gefolgt von einem Bereich, in dem die Wellen vom Wasserdampf in der Atmosphäre stark absorbiert werden, so dass die Reichweiten extrem kurz und wetterabhängig würden. Wahrscheinlich geeignetere und noch wenig genutzte Frequenzen fände man wieder zwischen 25.000 und 35.000 MHz (25-35 GHz). [Aktualisierung 26.11.19: zwischen 24.000 und 35.000 MHz (24-35 GHz). Gegen die zumindest in internationalen Konferenzen diskutierten Frequenzen bei 24 GHz gibt es jedoch Bedenken, sie könnten Messungen des Wasserdampfgehalts in der Atmosphäre durch Wettersatelliten stören, die einen Frequenzbereich knapp unter 24 GHz nutzen.] Genaue Frequenzen sind dort noch nicht festgelegt, und die technische Machbarkeit wird noch erprobt. Das ist also so oder so Zukunftsmusik und hat mit dem 5G, das ab 2020 allmählich in Betrieb gehen soll, wenig zu tun. Klar ist nur, wenn sehr viele neue Geräte kommen, wird man irgendwann Frequenzen in diesem Bereich nutzen müssen. Aktuell arbeiten dort zum Beispiel Satellitenfunk und spezielle Radargeräte wie Abstandsmesser für autonomes Fahren oder manche Radarfallen. Da wir im Alltag bislang noch eher wenigen Sendern in diesem Bereich begegnen, kann man sich theoretisch schädigende Wirkungen zusammenphantasieren, die noch nicht aufgefallen sein könnten, falls sie selten genug aufträten. Auch hier wäre aber ein Nobelpreis für Physik fällig, denn nach den Gesetzen der Physik ist auch in diesem Bereich, immer noch weit unter dem Infrarot und noch weiter unterhalb des sichtbaren Lichts und der ionisierenden Strahlung, die einzige Wirkung auf biologisches Material eine Erwärmung.

Einen biologischen Unterschied gibt es allerdings tatsächlich: Die kürzeren Wellen bei diesen Frequenzen geben beim Auftreffen auf den Körper ihre Energie nicht über mehrere Zentimeter Weglänge im Gewebe ab, sondern direkt in der obersten Hautschicht. Der Körper würde also nicht wie durch heutigen Mobilfunk im Gewebe erwärmt, sondern direkt auf der Haut. Die würde sich vor allem bei schlechter Durchblutung möglicherweise schneller aufheizen. Das klingt beunruhigend, aber tatsächlich hätte es einen entscheidenden Vorteil: Auf der Haut haben wir anders als tief im Gewebe Nervenenden, die Wärme wahrnehmen. Eine Annäherung an einen zu starken Sender würde man also viel schneller als heiß empfinden und könnte sich in Sicherheit bringen. Der Effekt würde einem Infrarot-Heizstrahler ähneln, der allerdings bei noch viel höheren Frequenzen strahlt.

Alle 200 Meter ein Sendemast?

Bei den für einen späteren Ausbau vorgesehenen Frequenzen ab 25 GHz ist die Reichweite durch Hindernisse und Absorption in der Luft erheblich geringer als bei heutigem Mobilfunk. Für die Flächenabdeckung ist das natürlich ein Nachteil, aber in Gebieten mit hoher Nutzerdichte eher vorteilhaft, weil man dieselbe Frequenz an einem anderen Sendemast schon in überschaubarem Abstand wieder verwenden kann. Die kurze Reichweite führt also dazu, dass man nicht absurd viele zusätzliche Frequenzen braucht. Sie erfordert aber natürlich tatsächlich deutlich mehr Sendestationen. In gewisser Weise verschwimmt damit in Innenstädten durch 5G der Unterschied zwischen Mobilfunk und öffentlichem WLAN. Die kürzere Reichweite bedeutet natürlich auch, dass die Strahlen-„Belastung“ auf der einzelnen Frequenz trotz mehr Sendestationen im Durchschnitt nicht ansteigt. Man braucht ja einfach nur genug Leistung, dass das Gerät kommunizieren kann. Die insgesamt eingestrahlte Leistung über alle Frequenzen steigt also nur in dem Umfang, wie mehr Geräte eben mehr Frequenzen brauchen.

Die kürzere Reichweite bei den sehr hohen Frequenzen, in Verbindung mit der populistischen Forderung mancher Politiker nach „5G an jeder Milchkanne“ dürfte zu der irrsinnigen Vorstellung geführt haben, ganz Deutschland würde mit Sendemasten im Abstand von 200 Metern zugepflastert. Hohe Dichten an Sendern wird es da geben, so sich viele Menschen aufhalten und sich damit auch viele Geräte ins Netz einwählen werden, also zum Beispiel in Frankfurt auf der Zeil oder in München rund um den Marienplatz. Auch Industriegebiete könnten eine hohe Senderdichte brauchen, wenn dort viele technische Geräte einen Internetzugang bekommen.

Auf dem Land sind die Kapazitäten der heutigen Mobilfunknetze hingegen nicht annähernd ausgelastet, und daran wird sich bei 5G auch dann nichts ändern, wenn alle Traktoren eine Internetanbindung haben und Forsthäuser zu Smart Homes werden. Wollte man die Flächenabdeckung des heutigen Mobilfunks erreichen, dann bräuchte man wegen der dort schon geringeren Reichweite allerdings schon bei den aktuell vorgesehenen Frequenzen von 3400 MHz in gewissem Umfang mehr Sendemasten als heute, die dann zum größten Teil nur zu winzigen Bruchteilen ausgelastet wären. Dass das nicht zu bezahlen wäre, ist offensichtlich auch den Fachleuten in den Ministerien klar, denn die Forderung nach hoher Flächenabdeckung, die es noch in den ersten LTE-Lizenzvergaben gab, kommt in den aktuellen 5G-Lizenzen nicht mehr vor. Will man die heutige Flächenabdeckung mit 5G erreichen, wird es sich kaum vermeiden lassen, heutige 2G- und UMTS-Frequenzen abzuschalten und auf den 5G-Standard zu übertragen – außer, man könnte doch noch niedrigere Frequenzen um 700 MHz freimachen. In diesen Fällen hätte man aber weder mehr Sendemasten noch eine „Belastung“ durch ungewohnte Frequenzen.

Was ändert sich also durch 5G?

Gesundheitlich ändert sich in der Summe nicht viel – in ländlichen Regionen eigentlich gar nichts. In den Innenstädten wird durch die potentiell große Dichte internetfähiger Geräte die Zahl jeweils aktiver Verbindungen und damit die insgesamt gesendete Leistung in gewissem Umfang ansteigen. Dort werden vermutlich auch neue Frequenzen auftauchen, bei denen die Wirkung auf den Körper tatsächlich anders ist, aber nur insofern, als der Körper dann auf der Haut erwärmt wird und nicht mehr unter der Haut.

Was bleibt, sind diffuse Ängste vor einer (einigermaßen) neuen Technologie, geschürt vom Sensationsjournalismus der selbsternannten Qualitätsmedien, die sich zum Steigbügelhalter von Verschwörungsmythen und antisemitischer Hetze machen.