Bevor ich mich hier wahrscheinlich doch bald wieder mit dem bräunlichen Schimmer irgendwelcher Impfgegner und Querdenkschwurbler beschäftigen muss, will ich auf keinen Fall versäumen, mein Versprechen aus dem letzten Post einzulösen und mir die Radiocarbondatierung (oder C14-Methode) näher anzusehen. Dabei fangen wir tatsächlich mit etwas an, das vom Himmel gekommen ist und enden mit einem, der zum Himmel gefahren sein soll, nachdem er seine Abdrücke auf einem Tuch hinterlassen hat…

Was ist eigentlich Kohlenstoff-14?

Die Kerne unserer Atome setzen sich aus Protonen und Neutronen zusammen. Die positiv geladenen Protonen bestimmen die Ladung des Kerns – und damit auch, wie viele Elektronen zur Hülle des Atoms gehören müssen, damit es elektrisch neutral ist. Praktisch die gesamten chemischen Eigenschaften des Atoms sind also durch die Zahl seiner Protonen bestimmt. Die Neutronen, mit einer Masse praktisch gleich der von Protonen, aber elektrisch neutral, tragen zu den Eigenschaften des Atoms nur eben diese Masse bei. Kernphysikalisch machen es die Neutronen möglich, dass die Protonen, deren positive Ladungen sich ja abstoßen, im Kern einen gewissen Abstand wahren, aber trotzdem miteinander verbunden bleiben können. Die starke Kernkraft, die Atomkerne zusammenhält, reicht ja nur von einem Teilchen zum nächsten. Man hat die Neutronen daher in den Anfängen der Kernphysik mit einer Art Kleber verglichen. Da die Masse der Elektronenhülle vernachlässigbar ist, wird die Masse eines Atoms durch die Zahl der Protonen plus Neutronen im Kern bestimmt, die chemischen Eigenschaften, wie schon erwähnt, nur durch die Protonen. Die Gesamtzahl von Protonen und Neutronen im Kern bezeichnet man als die Massenzahl, und genau das ist die 14 im Kohlenstoff-14, geschrieben auch als 14C (normalerweise mit hochgestellter 14).

Kerne mit gleich vielen Protonen gehören daher zum selben chemischen Element, und die Zahl der Protonen im Kern ist nichts weiter als die Ordnungszahl des Elements im Periodensystem. Wenn Kerne sich nur in ihrer Neutronenzahl unterscheiden, spricht man von unterschiedlichen Isotopen eines Elements. Es gibt bestimmte Verhältnisse von Protonen zu Neutronen, in denen Isotope langfristig stabil sind. Bei relativ kleinen Kernen findet man oft nur ein oder zwei solcher stabilen Isotope pro Element, und die Zahlen der Protonen und Neutronen sind sich dann meist sehr ähnlich. Beim Kohlenstoff mit seinen sechs Protonen gibt es stabile Isotope mit sechs oder sieben Neutronen, also mit den Massenzahlen 12 und 13. Hat ein Kern ein von der Stabilität abweichendes Verhältnis von Protonen zu Neutronen, dann wird er sich früher oder später (wobei später je nach Kern auch Milliarden von Jahren bedeuten kann) umwandeln, typischerweise indem ein Proton zu einem Neutron wird oder umgekehrt. Beide Formen dieser Umwandlung kamen schon im letzten Artikel beim Kalium-40 vor.

Beim Kohlenstoff ist das bedeutendste instabile Isotop der Kohlenstoff-14, bei dem zu den sechs Protonen, die es zum Kohlenstoff machen, acht Neutronen hinzukommen. Das Isotop ist relativ langlebig: Erst nach 5730 Jahren ist die Hälfte der Kohlenstoff-14-Kerne zerfallen. Anders als beim Kalium-40 gibt es hier auch nur einen Umwandlungsprozess, durch den der Kohlenstoff-14 wieder abgebaut wird, und der ist relativ naheliegend: Eins der Neutronen wandelt sich in ein Proton um, wodurch ein stabiler Kern mit je sieben Protonen und Neutronen entsteht, Stickstoff-14. An dieser Stelle kommt wieder die im letzten Artikel schon erwähnte Erhaltung der Quantenzahlen ins Spiel: Da die positive Ladung des Protons nicht einfach aus dem Nichts kommen kann, muss gleichzeitig noch eine negative Ladung freigesetzt werden, und das leichteste Teilchen mit negativer Ladung ist ein Elektron. Die Zahl der leichten Teilchen ist aber ebenfalls erhalten, so dass als Ausgleich für das Elektron noch ein ungeladenes leichtes Antiteilchen, ein Antineutrino, abgegeben werden muss, das aber in der Regel nicht direkt gemessen werden kann. Diese Art der Kernumwandlung, Neutron wird zu Proton, Elektron und Antineutrino, bezeichnet man als Betazerfall (β-, um genau zu sein), das beschleunigte Elektron, das dabei wegfliegt, als Betastrahlung.

Wie entsteht Kohlenstoff-14?

Wenn von einer Menge Kohlenstoff-14 nach 5700 Jahren schon die Hälfte in Stickstoff umgewandelt ist, sollte klar sein, dass der Kohlenstoff-14, den wir heute finden, nicht wie Kalium-40 ein Überbleibsel von der Entstehung der Erde sein kann. Das Isotop muss also irgendwie ständig neu entstehen. Der Prozess, in dem Kohlenstoff-14 produziert wird, sieht auf den ersten Blick aus wie die direkte Umkehrung des Zerfalls: Kohlenstoff-14 entsteht nämlich aus Stickstoff-14. Das kann aber natürlich nicht von allein passieren, denn ein Zerfall führt ja immer zum energetisch günstigeren, in der Regel stabileren, Zustand. Wenn sich so ein Prozess (im Ergebnis) umkehrt, muss das durch irgendetwas angetrieben werden, und das sind in dem Fall Neutronen.

Freie, also nicht in einem Atomkern gebundene Neutronen sind ebenfalls instabil. Sie zerfallen schon mit einer Halbwertszeit von 15 Minuten zu einem Proton (und natürlich auch wieder einem Elektron und einem Antineutrino) – außer sie treffen vorher auf einen Atomkern, in den sie sich einbauen und so in einen energetisch stabileren Zustand geraten können. Neutronen gehören somit auch zum gefährlicheren, weil schwer abzuschirmenden, Teil der radioaktiven Strahlung. Für technische Zwecke erzeugt man Neutronen in größerer Anzahl am einfachsten durch Kernspaltung in einem Reaktor. Wenn nur kleinere Neutronenzahlen benötigt werden oder ein Reaktor aus politischen Gründen unerwünscht ist, kann man Neutronen auch aus Atomkernen abspalten, indem man diese mit hochenergetischen geladenen Teilchen aus einem Beschleuniger beschießt. Das gleiche passiert in der hohen Atmosphäre, wenn energiereiche Strahlung aus den Tiefen des Alls auf die Atomkerne der Atmosphäre trifft und diese zum Teil einfach zertrümmert. Teilweise können die entstandenen Kernfragmente in Folgekollisionen wieder weitere Kerne zerstören, so dass neben vielen geladenen Teilchen auch Neutronen aus den Atomkernen freigesetzt werden.

Da die Atmosphäre unterhalb einer gewissen Höhe zum größten Teil aus Stickstoff besteht, ist die Wahrscheinlichkeit groß, dass der erste Atomkern, mit dem ein solches freies Neutron reagieren kann, ein Stickstoffkern ist. Stickstoffkerne bestehen aus sieben Protonen und fast immer sieben Neutronen. Naiverweise könnte man erwarten, dass ein solcher Stickstoff-14-Kern das Neutron einfach schluckt und zu einem ebenfalls stabilen Stickstoff-15-Kern wird. Auch hier führen aber wieder Erhaltungssätze für Impuls und Drehimpuls in Verbindung mit der bei der Aufnahme des Neutrons frei werdenden Energie dazu, dass wieder ein Teilchen abgegeben wird, und das ist in diesem Fall eins der Protonen aus dem Kern. Effektiv wird im Kern also einfach ein Proton durch das Neutron ersetzt (eine sogenannte n-p-Reaktion), und der resultierende Kern – Kohlenstoff-14 – mit sechs Protonen und acht Neutronen ist zwar nicht stabil, aber energetisch schon günstiger als der Anfangszustand mit dem freien Neutron.

Kohlenstoff-14 entsteht in gewissen Höhen (ganz grob da, wo auch Flugzeuge fliegen) also ständig, einfach durch Prozesse, die von der kosmischen Strahlung ausgelöst werden. Aufgrund seiner langen Halbwertszeit hat das Isotop dann viel Zeit, sich zu verteilen, bevor ein nennenswerter Teil davon sich wieder zu Stickstoff-14 umgewandelt hat. Gleichzeitig unterscheidet es sich in fast allen chemischen Reaktionen nicht von sonstigem Kohlenstoff (warum „fast“ wäre mal ein Thema für einen anderen Artikel). Es reagiert in der Regel zu Kohlendioxid, wird mit dem anderen Kohlendioxid von Pflanzen und Bakterien in Biomasse eingebaut und in der Folge auch von Tieren gefressen. Ganz grob kann man sagen, dass alles, was lebt oder kürzlich noch gelebt hat, aufgrund seines Stoffwechsels den gleichen Anteil von Kohlenstoff-14 an seinem enthaltenen Kohlenstoff hat. Das gilt auch für unsere Nahrung und für unseren Körper.

Gehört das auch zur natürlichen Strahlenbelastung?

Wie wir schon im mehrfach erwähnten letzten Artikel gesehen haben, hat Betastrahlung in festem oder flüssigem Material eine so geringe Reichweite, dass sie für Menschen nicht relevant ist, wenn sie außerhalb des Körpers entsteht. Interessant sind also nur die Zerfälle von Kohlenstoff-14, die im Körper selbst passieren. Die Zahl dieser Zerfälle (gemessen in Becquerel, also Zerfällen pro Sekunde) ist interessanterweise sehr ähnlich der, die man auch beim Kalium-40 hat. Die biologisch relevante Strahlendosis durch Kohlenstoff-14 ist allerdings viel kleiner als durch Kalium-40, weil pro Zerfall nur etwas mehr als ein Zehntel an Energie frei wird. Dementsprechend richten die herumfliegenden Elektronen auch viel weniger Schaden an. Kohlenstoff-14 ist also ein Teil der natürlichen Strahlenbelastung, macht davon aber nur einen winzigen Anteil aus.

Wie kann man das zur Altersbestimmung nutzen?

Für eine Altersbestimmung muss die Uhr ja irgendwann anfangen zu ticken. Es muss einen Zeitpunkt geben, wenn für ein Material der Anteil eines Isotops oder das Verhältnis von zwei Isotopen eingefroren werden, so dass man anschließend messen kann, wieviel seitdem zerfallen ist. Im Fall der Kalium-40-Methode war das das Zerfallsprodukt Argon-40, das beim Auskristallisieren eines Gesteins noch einen Anteil von null hat. Beim Kohlenstoff-14 nutzt man die Tatsache, dass in lebenden Organismen der Kohlenstoff über den Stoffwechsel mit der Außenwelt ausgetauscht wird und dadurch der Kohlenstoff-14-Anteil am Kohlenstoff im Organismus dem der Außenwelt entspricht. Wenn der Kohlenstoff nicht mehr ausgetauscht wird, weil der ganze Organismus gestorben oder der Kohlenstoff fest im Holz einer Pflanze eingebaut ist, dann kann kein neuer Kohlenstoff-14 aus der hohen Atmosphäre mehr hineinkommen. Der enthaltene Kohlenstoff-14 wird dann langsam zu Stickstoff zerfallen und aufgrund der abweichenden chemischen Eigenschaften von Stickstoff in der Regel entweichen. Der Anteil von Kohlenstoff-14 am Gesamt-Kohlenstoff im Material wird sich nach 5730 Jahren halbiert haben, der Rest nach weiteren 5730 Jahren noch einmal halbiert… und so weiter.

Wenn man den Anteil des Kohlenstoff-14 am Gesamtkohlenstoff bestimmt und ins Verhältnis zum ursprünglichen Anteil setzt, wird es also recht einfach, das Alter von biologischem Material zu bestimmen. Das funktioniert wieder am besten, wenn der Zeitraum ungefähr die Größenordnung der Halbwertszeit von 5730 Jahren hat – in der Praxis von einigen hundert bis einigen zehntausend Jahren.

Wie misst man das eigentlich?

Bis hierhin findet man das alles noch relativ häufig erklärt. Die meisten Beschreibungen der Methode gehen dann aber recht flott über die Frage hinweg, wie man den Kohlenstoff-14-Gehalt eines Materials denn tatsächlich misst. Für mich als experimentellen Kern-/Teilchenphysiker (das weiß bei meinem damaligen Forschungsfeld keiner so genau, wozu wir eigentlich gehören) ist aber gerade das spannend.

Die trickreiche und technisch eher einfache Methode ist, die Zerfälle von Kohlenstoff-14 zu messen. Da immer derselbe Anteil der noch vorhandenen Kerne zerfällt, kann man aus der Häufigkeit von Zerfällen die Menge des vorhandenen Kohlenstoff-14 errechnen. Die Zerfälle machen sich ja durch das abgegebene Elektron, also die Beta-Strahlung kenntlich, die sich recht einfach mit einem Halbleiterdetektor oder altmodischer mit einem Proportionalzählrohr nachweisen lassen. In beiden Messgeräten nutzt man den Effekt, dass die schnell bewegten Elektronen aus den Zerfällen weitere Elektronen aus den Atomen des Gases (beim Zählrohr) oder des Halbleiters (beim Halbleiterdetektor) herausreißen können. Diese werden dann mit einer Hochspannung beschleunigt, bis wiederum sie weitere Elektronen aus den Atomen auf ihrem Weg herausreißen können, die wieder beschleunigt werden, und so weiter, bis genügend Elektronen zusammengekommen sind, dass man sie als kleines elektrisches Signal mit einem Verstärker messen kann. Solche Messungen funktionieren für den Nachweis vieler radioaktiver Stoffe sehr gut – beim Kohlenstoff-14 gibt es aber zwei Problemchen. Erstens macht Kohlenstoff-14 eben nur diese Beta-Zerfälle, bei denen sich die Energie des Zerfalls ja auf das messbare Elektron und das nicht messbare Antineutrino verteilt – und zwar in zufällig wechselnden Anteilen. Man kann dadurch nicht sagen, dass ein Elektron einer bestimmten Energie genau aus einem Zerfall von Kohlenstoff-14 kommen muss und nicht vielleicht von irgendeinem anderen Betastrahler. Man muss also sicherstellen, dass die Probe mit keinem anderen radioaktiven Material (zum Beispiel mit Kalium-40) kontaminiert ist. Das zweite Problem ist, dass Kohlenstoff-14 so langsam zerfällt. Der gesamte Kohlenstoff im Körper eines durchschnittlichen Erwachsenen (und die Eiweiße und Fette unseres Gewebes bestehen ja zu einem großen Teil aus Kohlenstoff) verursacht weniger als 4000 Zerfälle von Kohlenstoff-14 pro Sekunde, und zwar solange der Körper noch lebt und der Kohlenstoff frisch ist. In 23.000 Jahre alten Knochen ist die Aktivität nur noch 1/16 davon, und man will ja oft nur eine Probe von ein paar Milligramm Material für die Messung verwenden. Da muss man unter Umständen ziemlich lange messen, bis man eine Häufigkeit von Kohlenstoff-14-Zerfällen angeben kann. Zudem muss man den Gesamtkohlenstoffgehalt des Materials dann noch zusätzlich mit einer anderen Methode bestimmen. Das sorgt für eine Menge Ungenauigkeiten.

Wenn man es genau wissen will, bleibt einem also nichts anderes übrig, als die Atome der unterschiedlichen Isotope einzeln auszuzählen. Das geht zum Glück automatisch in einem Massenspektrometer, ist aber trotzdem im Vergleich zur Messung der Strahlung aus den Zerfällen richtig aufwendig und teuer. Die zu analysierende Materialprobe wird dabei zunächst einmal verbrannt und das entstandene Kohlendioxid dann wieder elektrisch aufgespalten, so dass sich der Kohlenstoff auf einer Metallscheibe absetzt. Beschießt man diese Metallscheibe mit beschleunigten, elektrisch geladenen Teilchen, dann kann man einzelne Kohlenstoffatome wieder von der Metalloberfläche wegreißen. Dabei werden sie in vielen Fällen ein Elektron zu viel oder zu wenig mitbekommen haben, also elektrisch geladen sein (man bezeichnet sie dann als Ionen), so dass man sie jetzt selbst in einem elektrischen Feld beschleunigen kann. In diesem elektrischen Feld wirkt jetzt auf alle gleich geladenen Ionen (und die meisten haben eben nur die Ladung von einem Elektron zu viel oder zu wenig) die gleiche Kraft. Diese gleiche Kraft wird aber die schwereren Kohlenstoff-14-Ionen weniger stark beschleunigen als die „normalen“ Kohlenstoff-12-Ionen oder den selteneren, aber ebenfalls stabilen Kohlenstoff-13. Jetzt kann man auf unterschiedliche Arten etwas tricksen, um die Ionen noch mehr zu beschleunigen – aber immer mit elektrischen Feldern. Die leichteren Ionen werden dadurch immer schneller sein als die schweren. Dann lenkt man die Ionen um die Kurve. Das geht bei beschleunigten, geladenen Teilchen recht einfach mit einem Magnetfeld, und es passiert genau das, was man naiv erwarten würde: Die schwereren Ionen werden, obwohl sie etwas langsamer sind, ein bisschen weiter aus der Kurve getragen. Die Flugbahn ist also ein Maß für die Masse der Ionen, und wenn man einfach nur zählt (das geht wieder zum Beispiel mit Halbleiterzählern oder Zählrohren), wie viele Kohlenstoffionen wo ankommen, dann weiß man, wie hoch der Anteil des Kohlenstoff-14 am Gesamtkohlenstoff in der Probe war. Das ist dann sehr eindeutig und genau, weil man alle Anteile mit derselben Apparatur misst und Störfaktoren sehr gut ausschließen kann, aber so ein Massenspektrometer nebst Material und Personal muss man erst einmal haben.

Welche Grenzen und Probleme gibt es?

Mit dem Massenspektrometer kann man den Anteil des Kohlenstoff-14 also sehr genau bestimmen. Neben der reinen Messgenauigkeit gibt es aber noch ein paar andere Problemchen, die die Präzision der Datierung begrenzen und die leider auch in der Presse gerne benutzt werden, um die Methode insgesamt zu diskreditieren, obwohl sie in Wirklichkeit einfach nur bedeuten, dass man eben auch bei der Radiocarbondatierung wissen muss, was man tut.

Eine vielleicht etwas überraschende Quelle von Ungenauigkeiten, weil es sich um eine tausendfach benutzte physikalische Eigenschaft eines Kerns handelt, ist die Halbwertszeit von Kohlenstoff-14. Diese wird in kernphysikalischen Datenbanken angegeben als 5730 +/- 40 Jahre. Anders gesagt, man geht nach heutigem Wissen davon aus, dass die Halbwertszeit mit einer Wahrscheinlichkeit von knapp 70 % zwischen 5690 und 5770 Jahren liegen sollte. Sie kann aber auch noch ein Stück niedriger oder höher sein. Die Ursache für die auf den ersten Blick überraschende Ungenauigkeit von knapp einem Prozent bei einer so grundlegenden Größe liegt darin, dass es nicht so ganz einfach ist, die Halbwertszeit eines seltenen, langlebigen Isotops zu bestimmen. Eine Möglichkeit, Halbwertszeiten zu messen, ist, dass man die Strahlung einer Probe über einen langen Zeitraum beobachtet, um zu messen, wie sie sich verändert. Das ist offensichtlich wenig praktikabel, wenn eine richtig deutliche Veränderung erst über Jahrhunderte zu erwarten ist, zumal auch kernphysikalische Messgeräte bei Dauerbetrieb dummerweise spürbar altern. Andererseits kann man Halbwertszeiten auch bestimmen, wenn man die Menge des zu untersuchenden Isotops und die momentane Anzahl der Zerfälle sehr genau kennt. Das geht am besten, wenn die Halbwertszeiten extrem lang sind und die emittierte Strahlung sehr charakteristisch und einfach zu messen ist, wie zum Beispiel beim Zerfall von Kalium-40 zu Argon, der immer Gammastrahlung einer genau festgelegten Energie emittiert. Kohlenstoff-14 erzeugt aber nur Betastrahlung, bei der sich, wie schon erwähnt, die für einen radioaktiven Zerfall ohnehin schon kleine Energie auch noch irgendwie zwischen Elektron und Antineutrino aufteilt. Kurz gesagt, mit sehr großem Aufwand kann man solche Messungen natürlich immer irgendwie verbessern, aber das ist in diesem Fall nicht einfach. Es ist auch die Frage, wieviel Aufwand sich da lohnt, zumal die Halbwertszeit hier ja nicht die einzige Fehlerquelle ist.

Der zweite unsichere Wert bei der Radiocarbondatierung ist der Anteil des Kohlenstoff-14 am Gesamtkohlenstoff zum Beginn des zu messenden Zeitraums, als das biologische Material gestorben ist. Oben hatte ich sehr zuversichtlich geschrieben, dieser Anteil entspricht dem der Außenwelt – nur dummerweise ist der Kohlenstoff-14-Gehalt in der Außenwelt über die Jahrhunderte nicht konstant. Seit Beginn der Industrialisierung ist das offensichtlich, weil wir ständig zusätzliches Kohlendioxid aus fossilen Energieträgern in die Umwelt emittieren, und in diesen fossilen Stoffen hatte der Kohlenstoff-14 schon sehr viel Zeit, um zu zerfallen. Die Produktion von Kohlenstoff-14 in der Atmosphäre schwankt aber auch. Sie wird ja von der kosmischen Strahlung verursacht, die ursprünglich zu einem großen Teil aus geladenen Teilchen besteht (die Neutronen entstehen dann ja erst in Kollisionen mit den Atomkernen der Atmosphäre). Wie die beschleunigten Ionen im Massenspektrometer werden aber auch die geladenen Teilchen aus dem All durch Magnetfelder abgelenkt, und da eben vor allem durch das Erdmagnetfeld. Das Erdmagnetfeld schwankt in seiner Intensität aber ständig und hat in der Erdgeschichte auch schon des Öfteren ganz ausgesetzt. Die einfachste Möglichkeit, mit dieser Form von Ungenauigkeit umzugehen, ist, die Ergebnisse der Radiocarbondatierung zu kalibrieren, indem man sie mit Materialproben abgleicht, deren Alter man über Jahrtausende bis auf das Jahr genau kennst. Damit kommt dann plötzlich eine sehr alte und ziemlich handwerkliche Methode der Altersbestimmung zu neuer Wertschätzung, nämlich die schon mindestens seit dem 18. Jahrhundert eingesetzte Dendrochronologie, auf gut Deutsch das Auszählen der regional charakteristischen Muster dickerer und dünnerer Baumringe. Dabei wird vor allem die sehr langlebige amerikanische Borstenzapfenkiefer genutzt, aber man kann sich anhand der Muster mit erhaltenem Totholz noch weiter in die Vergangenheit hangeln. Das funktioniert über ungefähr die letzten 10.000 Jahre ganz ordentlich, aber davor, vor allem in der spannenden Zeit um die Besiedelung Europas durch den Homo sapiens und das Verschwinden der Neandertaler vor rund 40.000 Jahren herum, sind die Unsicherheiten noch relativ groß.

Die dritte Unsicherheit bei der Radiocarbondatierung bezieht sich auf die Frage, inwieweit der in der jeweiligen Probe untersuchte Kohlenstoff-14 tatsächlich ein repräsentatives Überbleibsel des Objekts ist, dessen Alter man wissen will. Dass das nicht immer stimmen kann, stellt man zum Beispiel fest, wenn man den Kohlenstoff-14-Anteil in Millionen Jahre alten Kohlevorkommen bestimmt. Darin dürfte eigentlich überhaupt kein Kohlenstoff-14 mehr übrig sein. Dennoch finden sich immer wieder Spuren des Isotops in solchen Lagerstätten, meist hart an der Nachweisgrenze der eingesetzten Verfahren, aber eben nicht null. Zum Teil kann man aus diesen Spuren ein rechnerisches Alter in der Größenordnung einiger zehntausend Jahre ermitteln. Von Kreationisten wird das regelmäßig als Nachweis präsentiert, dass wissenschaftliche Angaben über das Alter der Erde nicht stimmen könnten und dass Kohlelagerstätten vor relativ kurzer Zeit als Folge der Sintflut entstanden seien. Dazu passt natürlich nicht, dass die gemessenen Mengen des Isotops sich zwischen Lagerstätten deutlich unterscheiden. Tatsächlich entsteht Kohlenstoff-14 zwar überwiegend, aber eben nicht ausschließlich durch kosmische Strahlung in der Atmosphäre. Wissenschaftler, die für ihre Experimente gezielt nach besonders Kohlenstoff-14-armer Kohle suchen, berichten, dass der Gehalt des Isotops stark mit der sonstigen Radioaktivität der Lagerstätten, vor allem durch Uran, korreliert. Offensichtlich können Spuren von Kohlenstoff-14 also auch durch die Strahlung aus dem Uran erzeugt werden. Hinzu kommen gegebenenfalls auch Verunreinigungen durch Kohlenstoff in Mikroorganismen, die von außen eingetretenes Kohlendioxid aus der Luft, gegebenenfalls auch noch während oder nach der Förderung, verarbeitet und auf der Kohle hinterlassen haben. Das National Center for Science Education verweist zudem darauf, dass bei den extrem geringen nachgewiesenen Mengen unter Umständen nicht einmal klar sei, ob die gemessene Strahlung überhaupt von Kohlenstoff-14 stammt. Wie schon erwähnt, kann man aus Betastrahlung nicht eindeutig ablesen, von welchem Isotop sie emittiert wurde. Unter Umständen wird also mitunter auch Strahlung aus in den Kohlelagerstätten vorkommendem Kalium-40 oder den Zerfallsprodukten von Uran und Thorium fälschlich dem Kohlenstoff-14 zugeordnet. Das kann aber eigentlich nur passieren, wenn die Messungen nicht mit dem teureren Massenspektrometer gemacht sind, weil dort ja wirklich die Kerne und nicht ihre Betastrahlung gemessen werden.

Eine Kontamination der Proben mit neuerem Material, zum Beispiel durch eine Besiedelung mit Mikroorganismen, ist aber auch bei echten Datierungen von Fundstücken immer eine Gefahr, die bedacht und minimiert werden muss. Wichtig ist dabei, dass eine unkorrigierte Verunreinigung mit Kohlenstoff-14 aus neuem Material immer dazu führt, dass eine Probe zu jung eingeschätzt wird.

Welche Grenzen haben diese Probleme?

Alle die Unsicherheiten bei Radiocarbondatierungen, die gerade erwähnt wurden, haben ein paar Gemeinsamkeiten: Sie sind messbar, sie sind (mit Ausnahme der offenbar uneinheitlichen Ursachen der winzigen 14C-Spuren in Kohle) gut verstanden und nachvollziehbar, und sie sind vor allem insgesamt ziemlich klein. Relevant sind sie trotzdem, weil eine Fehldatierung von 50 Jahren im Mittelalter oder der Antike oder von einigen Jahrhunderten in der Zeit der Neandertaler natürlich einen erheblichen Unterschied für die Wissenschaft ausmachen können.

Leider werden auch immer wieder ganz andere Größenordnungen von Fehldatierung behauptet, und ähnlich wie bei bei den Behauptungen zu Kohlenstoff-14-Spuren in Kohlevorkommen ist das Ziel, religiösen Glaubenssätzen einen pseudo-wissenschaftlichen Anstrich zu geben. Es geht dabei vor allem um das sogenannte Turiner Grabtuch, in dem nach einer nicht einmal von der katholischen Kirche selbst anerkannten Vorstellung Jesus begraben gewesen sein soll. Ein hochauflösendes Bild findet sich hier. An sich ist dazu gar nicht viel zu sagen. Kunsthistorisch handelt es sich um ein typisches Produkt der mittelalterlichen Reliquienfertigung, die ihren Höhepunkt im 13. Jahrhundert hatte und Kirchen quer durch Europa mit zentnerweise Stücken des heiligen Kreuzes, mehreren Schweißtüchern Jesu und heiligen Lanzen sowie den Gebeinen von diversen Petrussen und Paulussen versorgt hat. Die ältesten nachgewiesenen Erwähnungen des Turiner Tuchs stammen aus der Mitte des 14. Jahrhunderts, und drei voneinander unabhängige Radiokohlenstoffdatierungen geben ein Herstelldatum im 13. Jahrhundert an. Dennoch gibt es eine treue Fangemeinde von überwiegend fachfremden Personen, die sich wissenschaftlich berufen fühlen, die Entstehung des Tuchs aufgrund von (für eine Datierung völlig ungeeigneten) chemischen Methoden, fragwürdigen Pollenanalysen oder purem Anschein ins Vorderasien vor rund 2000 Jahren zu verlegen.

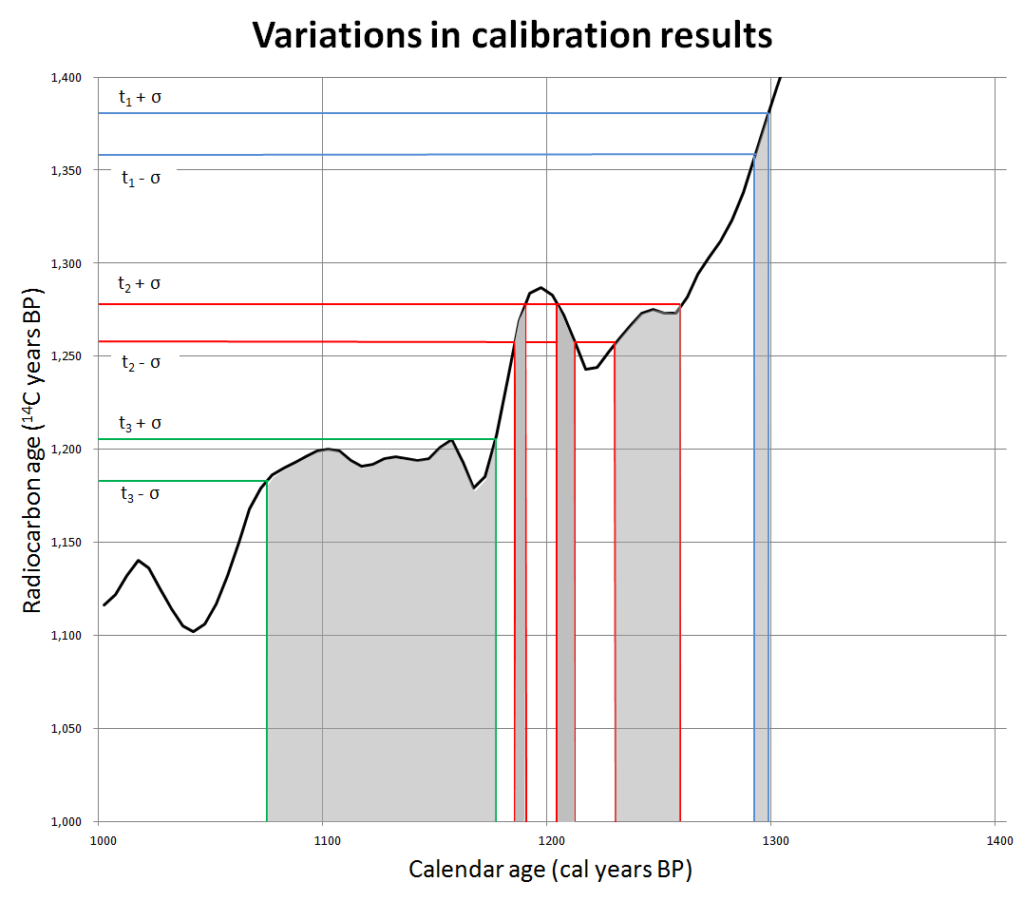

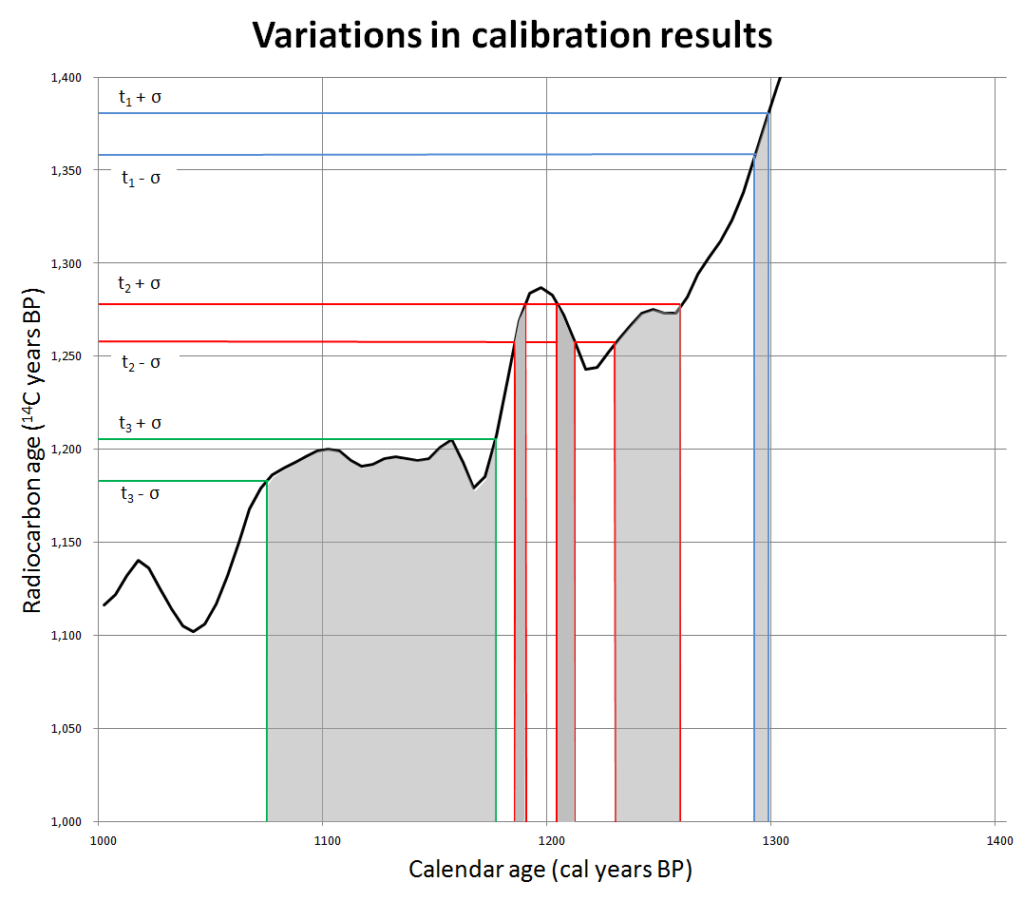

Lustig wird es bei den Versuchen, die den vorgefassten Glaubenssätzen widersprechenden Radiocarbondatierungen wegzudiskutieren, beziehungsweise ihnen lächerlich große Fehler anzudichten. Ja, aus den schon erwähnten Gründen sind Unsicherheiten von 50 oder in einigen Fällen auch 100 Jahren bei Proben aus dem Mittelalter immer denkbar, wie diese aufgrund wissenschaftlicher Daten auf Wikipedia veröffentlichte (Urheber dort nachlesbar) Kalibrationskurve zeigt:

Um angeblich 2000 Jahre alte Proben um satte 1200 Jahre falsch zu datieren, müssten allerdings schon sehr seltsame Dinge passiert sein. Wenn man von einem Wunder (wie der intensiven Strahlung der Auferstehung) mal absieht, landet man letztlich immer wieder bei Verunreinigungen durch Staub, Ruß, Mikroorganismen oder Reparaturfäden, die irgendwann zwischen dem 14. und dem 16. Jahrhundert in das Tuch gelangt sein müssten.

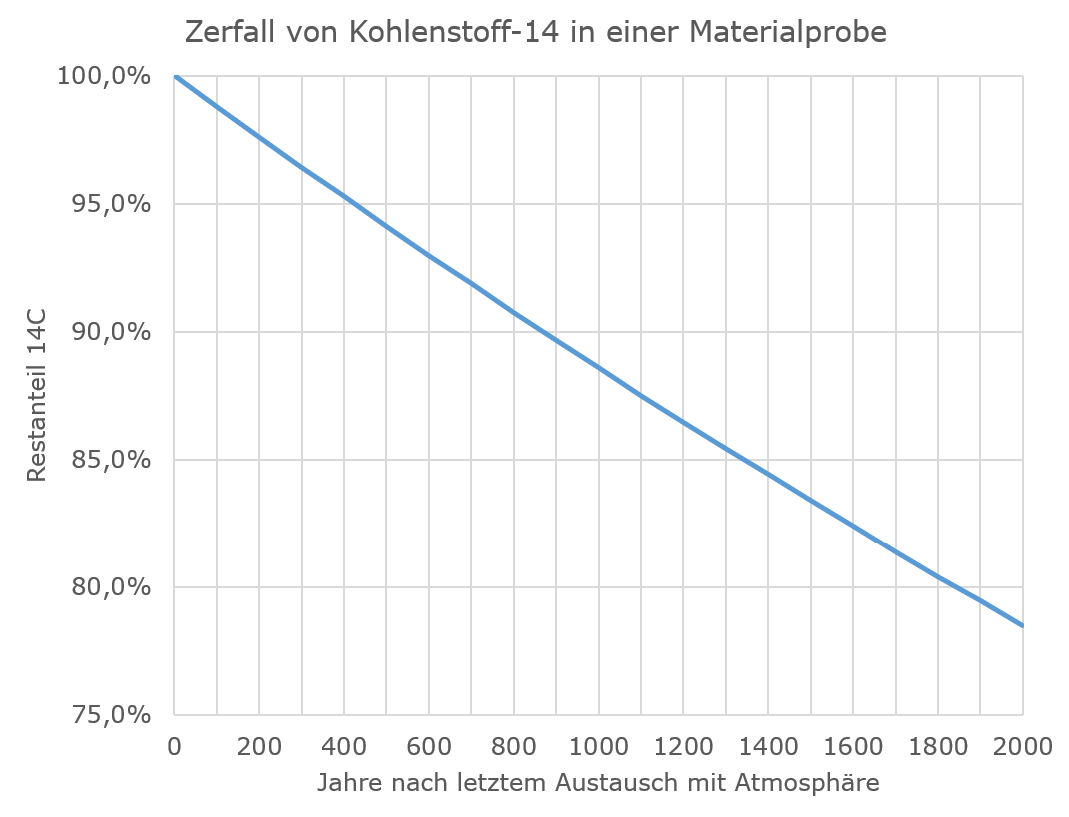

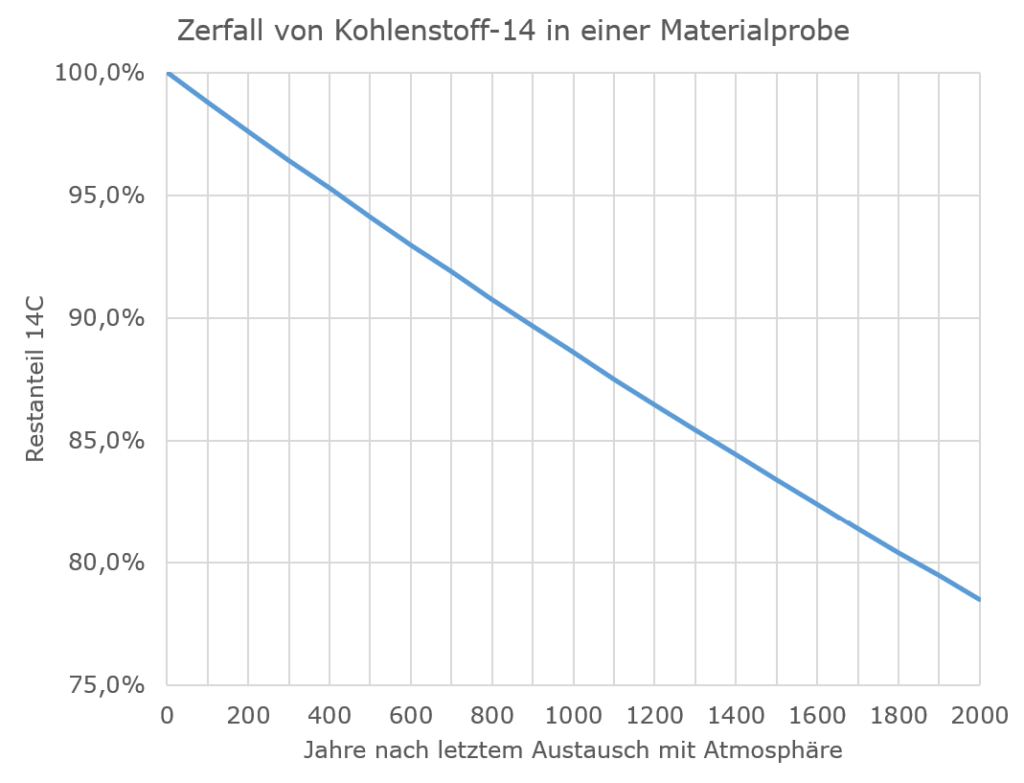

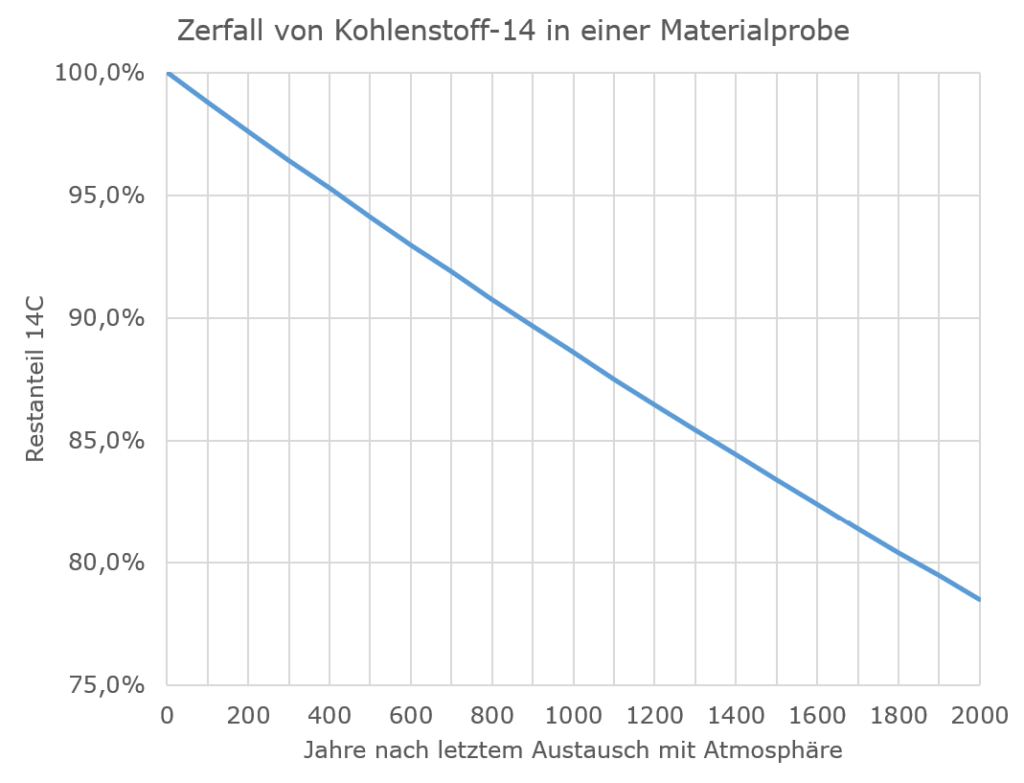

Abgesehen davon, dass es ziemlich absurd ist, dass das Tuch am Rand, wo die Proben entnommen wurden, unsichtbar per Kunststopfen repariert worden sein soll, während man auf die großen Löcher mittendrin einfach plumpe Flicken gesetzt hat: Überschlagen wir mal, wie plausibel ein solcher Effekt von Verunreinigungen ist, und weil es bei der Überlegung auf 50 Jahre mehr oder weniger nicht ankommt, vernachlässigen wir einfach die Kalibration und tun so, als sei der Kohlenstoff-14-Gehalt in der Atmosphäre und damit auch in frisch getrocknetem Flachs, aus dem man ein Leintuch herstellt, konstant. Diesen vereinfacht konstant angenommenen Kohlenstoff-14-Anteil setzen wir auf 100 % und betrachten, wie das Isotop über die nächsten 2000 Jahre zerfällt. Dann kommen wir auf die folgende Kurve:

Eine Radiocarbondatierung auf ein Alter von 750 Jahren bedeutet also, dass ein Kohlenstoff-14-Gehalt von rund 91,5 % des ursprünglichen Wertes gemessen wurde. Bei einer 2000 Jahre alten Probe dürfte der Restgehalt aber nur noch 78,5 % betragen. Bei den unterstellten Verunreinigungen oder Reparaturfäden wird in der Regel geschrieben, dass diese mindestens vor 500 Jahren auf das Tuch geraten sein müssten, entsprechend einem Kohlenstoff-14-Restgehalt von 94 %. Wenn man sich jetzt fragt, wieviel Verunreinigung mit 94 % Restgehalt man mit Originalmaterial von 78,5 % Restgehalt vermischen muss, um auf einen Restgehalt von 91,5 % zu kommen, stellt man fest, dass die untersuchten Proben zu 84 % aus Verunreinigungen bestanden haben müssten und nur zu einem kleinen Rest aus dem eigentlichen Tuch. Selbst wenn die Verunreinigungen vollkommen neu wären, was man ausschließen kann, müssten sie immer noch mehr als 60 % der untersuchten Proben ausmachen, um die gemessenen Werte zu erklären (eigentlich noch mehr, weil in neuen Verunreinigungen ja der Kohlenstoff-14-Gehalt duch die Verbrennung fossiler Energieträger reduziert ist). Verunreinigungen in dieser Größenordnung müsste man auf jeden Fall mit bloßem Auge erkennen können, egal, ob sie aus Ruß, Mikroorganismen oder später eingezogenen Reparaturfäden bestehen.