Es ist immer wieder lustig, wenn einem als Physiker vorgeworfen wird, wir würden behaupten, alles zu wissen, während man eigentlich ständig erklärt, was wir alles nicht wissen. Wissenschaft wäre auch ziemlich öde, wenn man schon alles wüsste.

Klar, in gewisser Weise haben wir (also, die Physik als Ganzes natürlich, nicht ich) schon ziemlich viel Wissen – nur eben nicht unbedingt die Art von Wissen, die typischerweise die Hobbyphilosophenrunde kurz nach Mitternacht und drei Gläsern Wein gerne mit uns diskutieren möchte.

Was wir als Faktum der Natur wissen

Wir wissen zum Beispiel, dass bei Kollisionen mit hohen Energien, wie am Large Hadron Collider (LHC) des CERN, ein Teilchen mit einer Masse von gut 125 GeV entsteht – das entspricht etwa der Masse eines ganzen Cäsium- oder Bariumatoms. Für ein einzelnes Elementarteilchen ist das schon sehr massig. Dieses Teilchen zerfällt nach extrem kurzer Zeit auf eine von mehreren, in ihrer Art und Häufigkeit genau bestimmten Arten in andere Teilchen. Es ist elektrisch nicht geladen, und es hat keinen Spin. Stellen Sie sich den Spin bitte nicht als Drehung vor, lieber als eine Art Magnetismus; das erzeugt weniger falsche Bilder im Kopf. Aber ich schweife ab, und ich will ja eigentlich weniger abschweifen, also weiter. Diese Dinge wissen wir ganz sicher über das Teilchen, denn wir haben sie, erstmals 2012, gemessen (also, wieder nicht ich, sondern die „Kollegen“ am CERN, mit denen ich mich immer noch irgendwie verbunden fühle, obwohl ich da nur vor Ewigkeiten ein paar Monate für meine Diplomarbeit verbracht habe).

Da gibt es auch so gut wie keinen Spielraum, dass diese Messung irgendwann als nicht mehr richtig gelten könnte. Es könnte sich allenfalls noch herausstellen, dass unterschiedliche Teams von Wissenschaftlern an unterschiedlichen Instituten zu unterschiedlichen Zeiten alle denselben wahnsinnig blöden Fehler in der Datenauswertung gemacht haben – aber das ist nach sechseinhalb Jahren von Folgeexperimenten und -auswertungen wirklich extrem unwahrscheinlich, dass das noch nicht aufgeflogen wäre. Solche Fälle hat es gegeben, und weil Physiker Menschen sind, hören sie das in der Regel nicht gerne, aber das gab es nie bei so vielen Beteiligten zum Teil unabhängig voneinander. Insofern, ja, dass da ein Teilchen mit diesen Eigenschaften ist, wissen wir sicher.

Man könnte aber auch sagen, das ist es auch schon mit unserem Wissen über das Teilchen.

Was wir als wissenschaftliche Theorie wissen

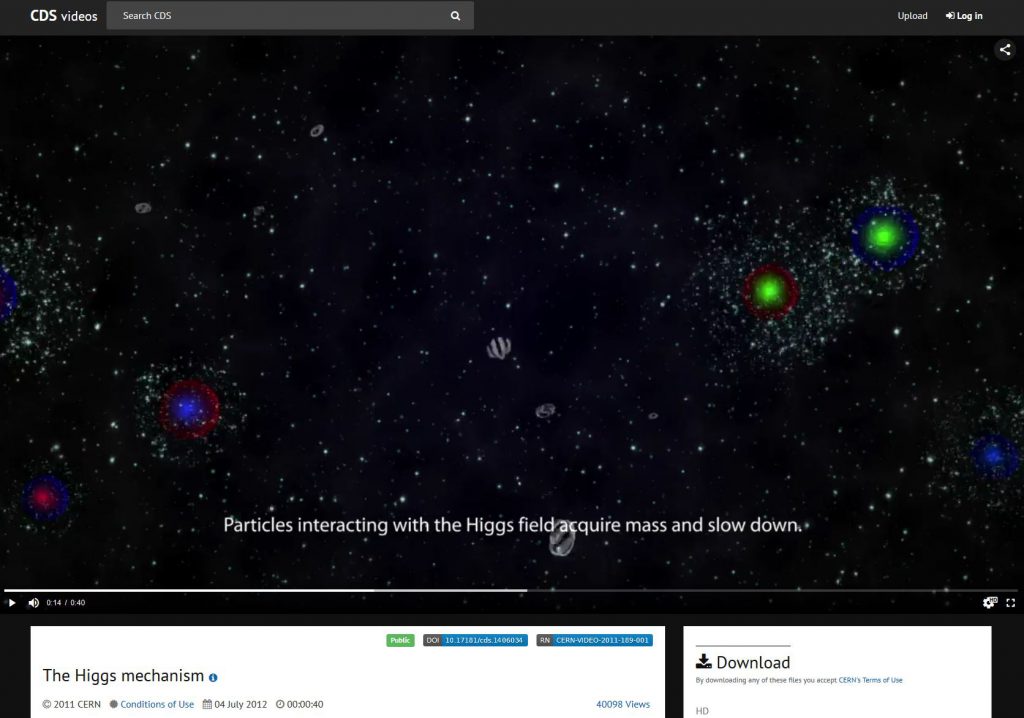

Es gibt aber noch mehr, was wir auch zumindest ziemlich sicher über dieses Teilchen sagen können. In den 1960er Jahren haben nämlich Peter Higgs, François Englert und eine ganze Anzahl von heute meist übergangenen Kooperationspartnern sich einen Mechanismus überlegt, wie man in den sogenannten Eichtheorien dessen, was wir heute Standardmodell nennen, das Entstehen von Masse erklären kann. Masse kommt in solchen Theorien nämlich eigentlich nicht vor, das heißt, alles würde sich eigentlich mit Lichtgeschwindigkeit bewegen. Der Higgs-Mechanismus, auf den sie dabei gekommen sind, ist in einer kleinen Bilderserie vom CERN ganz nett dargestellt worden, die man samt Texten zum Beispiel hier ansehen kann. Und es gibt vom CERN auch eine kleine Animation dazu:

Man sollte sich natürlich immer im Klaren sein, dass solche Visualisierungen nur ganz grobe Vorstellungen der eigentlichen Theorie sind und man aus solchen Vereinfachungen vor allem keine weitergehenden Schlüsse ziehen darf. Sie sollen erst einmal eine Vorstellung geben – um daraus etwas abzuleiten, müsste man sich mit der eigentlichen Theorie im Detail beschäftigen.

Aus diesem Higgs-Mechanismus hat man schon vor Jahrzehnten abgeleitet, dass es ein Teilchen geben sollte, das genau die Zerfallsarten, die Ladung und den Spin haben müsste, wie das Teilchen, das man dann 2012 am CERN messen würde. In Verbindung mit den anderen Theorien des Standardmodells und Messungen an verschiedenen Beschleunigern konnte man dann auch die Masse dieses Higgs-Teilchens schon vor der Messung immer weiter eingrenzen: In den 1980er Jahren dachte man noch, es könne mehrere hundert GeV schwer sein. Gegen 1990 zeichnete sich ab, dass die Masse zwischen 100 und 200 GeV liegen sollte. Damit war auch klar, dass man keinen neuen Riesenbeschleuniger für mehr als 10 Milliarden Dollar in der Wüste von Texas würde bauen müssen, um das Teilchen zu suchen: Der damals in der Entwicklung befindliche LHC am CERN sollte dafür locker ausreichen. Als ich Mitte der 1990er Jahre am CERN war, war man schon ziemlich sicher: Wenn es das Higgs-Teilchen tatsächlich gäbe, müsste seine Masse zwischen 110 und 130 GeV liegen. Im Jahr 2000 meinte man kurzzeitig, vage Anzeichen für ein neues Teilchen bei 114 GeV entdeckt zu haben, was sich aber nicht bestätigt hat. Schließlich kam die große Erleichterung, als man das Teilchen 2012 bei 125 GeV genau im vorhergesagten Massenbereich gefunden hat. Die Ernüchterung kam dann später, als sich abzeichnete, dass man am LHC neben dem Vorhergesagten (bis jetzt) irgendwie gar nichts Unvorhergesagtes findet, das Ansatzpunkte für neue Theorien bieten könnte – aber das ist eine andere Geschichte.

Diese Vorhersage und die dazu passende Messung geben uns ein ziemlich sicheres Wissen, dass es sich bei dem 2012 gemessenen Teilchen wohl um das gesuchte Higgs-Teilchen handelt. Das ist aber eine andere Art von Wissen als die Messung selbst: Die Theorie des Higgs-Mechanismus kann (und wird wahrscheinlich) irgendwann überholt sein, aber das Teilchen nicht. Jede neue Theorie, die später den Higgs-Mechanismus und das Standardmodell ersetzen will, wird nicht nur das Entstehen von Masse erklären müssen, sondern muss auch eine Erklärung dafür liefern, was für ein Teilchen man da seit 2012 beobachtet.

Das Higgs ist aber nicht das einzige Phänomen, das auf Basis der Theorien des Standardmodells (Elektroschwache Theorie, Quantenchromodynamik, Allgemeine Relativitätstheorie und Higgs-Mechanismus) vorhergesagt und später gemessen wurde. Das gleiche gilt für die W- und Z-Teilchen der schwachen Wechselwirkung, für alle aus Quarks aufgebauten Teilchen, die charm– und bottom-Quarks enthalten, sowie für das top-Quark und das tau-Neutrino. Alle wurden aufgrund des Standardmodells vorhergesagt und erst später nachgewiesen. Hinzu kommen unterschiedliche Arten sogenannter Jets, also Teilchenbündel, aus Kollisionen von Protonen oder leichten Atomkernen, die als Produkte der Quarks und Gluonen vorhergesagt wurden, aus denen die Protonen aufgebaut sind. Noch kein Teilchennachweis im eigentlichen Sinne, aber eine sehr frühe spektakuläre Bestätigung einer Vorhersage des Standardmodells war der Nachweis sogenannter neutraler schwacher Ströme am CERN 1973.

Das Standardmodell ist also nicht deshalb, nun, eben das Standardmodell der Physik, weil es besonders schön oder besonders praktisch wäre – gerade das ist es nach Ansicht der meisten Physiker eben nicht. Schließlich besteht es aus mehreren einzelnen Theorien, die auf den ersten Blick wenig miteinander zu tun zu haben scheinen und unter denen sich zumindest die Relativitätstheorie auch strukturell deutlich von den anderen unterscheidet. Der Standard ist es, weil es eine Vielzahl experimenteller Ergebnisse vorhergesagt hat. Dabei hat es nicht nur Messwerte wie die Masse des Higgs-Teilchens ziemlich gut eingegrenzt, sondern sogar die Existenz ganzer Phänomene und Teilchen vorhergesagt. Was immer irgenwann an die Stelle des Standardmodells treten soll, muss also in vielerlei Hinsicht zunächst einmal die gleichen Ergebnisse liefern wie das Standardmodell – sonst passt es schlicht und einfach nicht zur messbaren Realität.

Wie man nicht zu Wissen gelangt

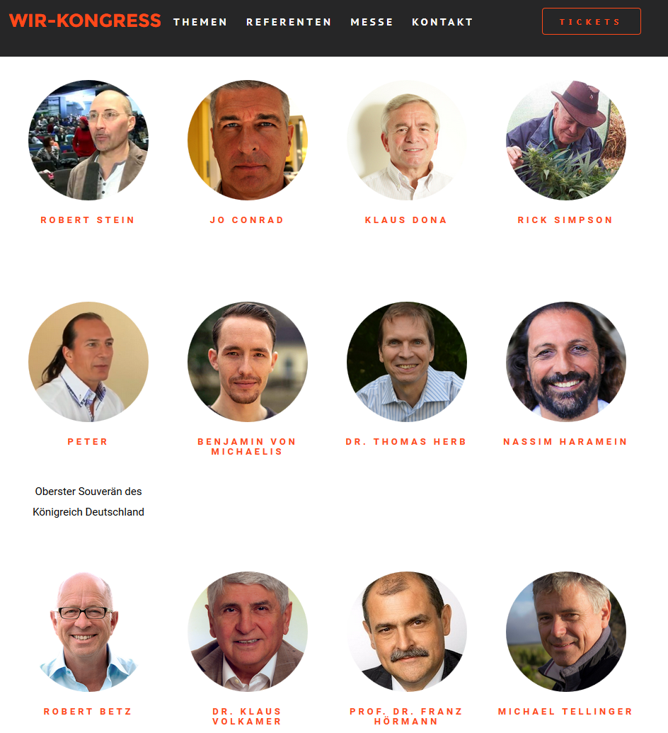

Die Anhänger „alternativer“ Physiker wie Nassim Haramein oder Burkhard Heim (Heim war immerhin tatsächlich Physiker) behaupten jetzt, ihre Idole hätten das Standardmodell widerlegt, indem sie einzelne Messwerte mit größerer Genauigkeit vorhergesagt hätten. Sowohl Haramein als auch Heim waren hier schon an anderer Stelle Thema. Ironischerweise haben diese beiden Geistesgrößen Messwerte „vorhergesagt“, die schon längst gemessen und ihnen bekannt waren. Das ist ungefähr so, als wollte ich meine Kenntnisse in meteorologischer Synoptik (also Wetterbeobachtung und -vorhersage, das habe ich in meinem Nebenfach tatsächlich mal gelernt) dadurch unter Beweis stellen, dass ich das Wetter von gestern vorhersage. Im Fall von Heim mussten einige der von ihm genau „vorhergesagten“ Messwerte (wie die Masse des Eta-Mesons) aufgrund späterer, genauerer Messungen korrigiert werden, so dass sich seine Nachhersagen auch noch als falsch herausgestellt haben. Da beide „Theorien“ außer diesen Pseudobelegen nicht viel Überprüfbares zu bieten haben, will ich hier auch gar nicht weiter darauf eingehen.

Wozu wir noch keine eindeutige Theorie haben

Natürlich gibt es aber auch in den Bereichen der Physik, mit denen sich das Standardmodell beschäftigt, Ergebnisse, die durch das Standardmodell nicht beschrieben werden. Ein Themenbereich ist die Masse von Neutrinos. Neutrinos sind eine Art elektrisch neutrales Gegenstück zu Elektronen sowie den schwereren elektronenähnlichen Teilchen, den Myonen und Tau-Leptonen, sowie zu deren Antiteilchen. Da Neutrinos elektrisch neutral sind, wirken elektromagnetische Felder nicht auf sie. Auch die sogenannte starke Kernkraft wirkt nicht auf Neutrinos. Nachgewiesen werden können sie also nur durch die schwache Kernkraft, die einen etwas irreführenden Namen hat, weil sie auf einzelne Teilchen nicht unbedingt schwach, sondern eher selten wirkt. In den allermeisten Fällen kann ein Neutrino durch die Erde hindurchfliegen, ohne dabei irgendeine Wechselwirkung mit der durchflogenen Materie auszulösen. Selbst die dichteste auf der Erde bekannte Materie, das Innere von Atomkernen, ist für Neutrinos durchlässig. Wenn sie aber (sehr, sehr selten) doch einmal mit einem Teilchen wechselwirken, an dem sie vorbeikommen, dann können sie in der Reaktion durchaus einen großen Teil ihrer Energie übertragen und in ein Elektron (oder Myon oder Tau oder deren Antiteilchen) umgewandelt werden. Die Frage ist, wenn andere Kräfte außer der schwachen Kernkraft nicht auf Neutrinos wirken, wirkt denn die Schwerkraft auf sie, haben sie also eine (von null verschiedene) Masse? Es gibt indirekte experimentelle Belege, dass die Neutrinomasse nicht null sein kann. Direkt gemessen hat die Masse aber noch niemand, wobei der momentan aussichtsreichste Versuch das nach vielen Verzögerungen 2018 endlich in Betrieb genommene KATRIN-Experiment in Karlsruhe sein dürfte. Nach dem Standardmodell müssen Neutrinos keine Masse haben – man kann aber eine von null verschiedene Neutrinomasse relativ problemlos ins Standardmodell einsetzen.

Eine Zeit lang, bis deutlich wurde, wie klein sie wirklich ist, galt eine von null verschiedene Neutrinomasse als mögliche Erklärung für einen physikalischen Effekt, der ebenfalls nicht durch das Standardmodell erklärt wird: die dunkle Materie. Letztlich braucht man nur relativ einfache Mechanik und die Annahme, dass Sterne, die gleich viel Strahlung bei denselben Wellenlängen aussenden, auch ungefähr gleich schwer sein müssen, um die Masse praktisch aller sichtbaren Objekte unserer Galaxie abzuleiten. Berechnet man jetzt die Bewegung dieser Objekte um das Zentrum der Galaxie, dann stellt man fest, dass die Galaxie viel mehr Masse enthalten muss, als alle sichbaren Objekte zusammen ausmachen. Das schließt nicht nur direkt sichtbare Objekte wie Sterne und Gasnebel ein, sondern auch Planeten und Staubwolken, die kein Licht emittieren, die man aber dadurch nachweisen kann, dass sie das Licht anderer Objekte verdecken. In der Summe ergibt sich, dass im Universum rund fünf mal so viel dunkle wie direkt oder indirekt sichtbare Materie vorhanden sein muss. Die Existenz dunkler Materie folgt also nicht aus irgendwelchen Theorien, sondern direkt aus Messungen und relativ einfachen Berechnungen. Massive, dunkle Himmelskörper, sogenannte MACHOs, die man nachweisen kann, wenn sie vor anderen Objekten vorbeiziehen, können nach aktuellen Messungen höchstens einen kleinen Teil dieser dunklen Materie ausmachen. Die plausibelste Vermutung erscheint zur Zeit, dass es sich um noch unbekannte, schwere Elementarteilchen, sogenannte WIMPs, handelt. Diese kommen im Standardmodell an sich nicht vor. Es gibt jedoch weitergehende Theorien wie die Supersymmetrie oder die Stringtheorie, die solche Teilchen vorhersagen und das Standardmodell mit einschließen. Zumindest für einfache Varianten der Supersymmetrie hätte man diese Teilchen aber inzwischen auch an Beschleunigern finden müssen, wenn diese Varianten denn zuträfen. In welcher Form das Standardmodell hier erweitert oder ersetzt werden muss, ist also noch ziemlich offen. Man kann aber auch durchaus argumentieren, dass es für unser Verständnis des Univerums ziemlich egal ist, ob die dunkle Materie aus diesen oder jenen Teilchen besteht – man muss einfach nur als Ergänzung zum Standardmodell annehmen, dass diese Masse irgendwie da ist und sonst nichts tut.

Etwas mehr (aber nicht viel mehr) theoretische Annahmen stecken hinter der dunklen Energie: Das Universum dehnt sich aus; das wissen wir, weil sich ziemlich direkt messbar fast alle anderen Galaxien von uns entfernen. Da die Schwerkraft immer als Anziehung wirkt, müsste sie diese Expansion allerdings im Lauf der Zeit immer mehr abbremsen. Das habe ich in den 1990er Jahren noch im Studium gelernt. Inzwischen kann man aber (wieder ziemlich direkt, durch die Beobachtung von sehr weit entfernten Supernovae, von denen das Licht Milliarden Jahre bis zu uns braucht) messen, dass sich die Expansion anscheinend sogar beschleunigt. Den Antrieb dieser beschleunigten Expansion bezeichnet man als dunkle Energie. Um das Universum so aufzublähen, braucht es ungeheuer viel Energie: Würde sich alle Materie im heutigen Universum einschließlich der dunklen Materie in Energie umwandeln, dann entspräche das nur rund einem Drittel der dunklen Energie, die nach heutiger Berechnung die Expansion des Universums antreibt. In der allgemeinen Relativitätstheorie und damit im Standardmodell kann man eine solche dunkle Energie als sogenannte kosmologische Konstante problemlos einsetzen. Das hat sogar Einstein schon getan, als er noch dachte, das Universum dehne sich nicht aus, sondern sei stationär. Das erfordert nämlich auch eine Energie, die der Schwerkraft entgegenwirkt, damit das Universum nicht unter seinem eigenen Gewicht zusammenstürzt. Das Standardmodell kann diese Energie berücksichtigen, erklärt aber nicht, woher sie kommt.

Welche Ansätze es zu diesen offenen Fragen gibt

Alle drei genannten Effekte widerlegen das Standardmodell nicht. Sie zeigen lediglich, dass es in der Teilchenphysik und der Kosmologie Fragen gibt, die das Standardmodell allein nicht beantwortet und die als Ergänzung zum Standardmodell angenommen werden müssen. Eine Theorie, die das Standardmodell irgendwann ablösen soll, sollte möglichst einen Teil dieser Fragen, im Idealfall alle, beantworten. An solchen Theorien wird schon gearbeitet, seit es das Standardmodell gibt. Es gibt eine ganze Anzahl von Ansätzen. Manche sind ambitionierter und versuchen, alle Kräfte in einer Theorie zusammenzufassen; andere klammern die Schwerkraft noch aus und überlassen deren Beschreibung noch der allgemeinen Relativitätstheorie. Manche dieser Theorien, wie die Stringtheorie oder die Quantengravitation, sind auch nach 40 Jahren noch nicht so weit, Aussagen zu machen, die sich mit heutiger Technik vernünftig experimentell prüfen ließen. Damit lässt sich erst recht nicht zwischen den denkbaren Varianten dieser Theorien unterscheiden. Andere, wie die zu meinen Schulzeiten noch mit großen Hoffnungen behaftete Grand Unified Theory (GUT), sind zumindest in ihren einfachen Varianten heute schon experimentell widerlegt. Alle solchen Theorien, aus denen spektakuläre neue Messergebnisse für bisherige Experimente abgeleitet wurden, sind daran jedenfalls gescheitert – was nicht notwendigerweise alle Varianten der jeweiligen Theorie ausschließt, aber in der Regel die favorisierte, weil einfachste. Das gilt zum Beispiel für die zu meinen Studienzeiten meist beachtete Theorie, die Supersymmetrie, deren einfachste Form neue Teilchen vorhersagt, die man im LHC am CERN schon hätte finden müssen. Es bleiben also viele Fragen offen, aber mangels entsprechender zu prüfender Vorhersagen gibt es aktuell wenige Ansätze, durch Experimente auf der Erde Antworten zu finden. Daher ist es auch umstritten, ob man neue, noch größere Beschleuniger bauen sollte. Die spannendsten neuen Erkenntnisse stammten in den letzten Jahren sicherlich aus den immer besseren Beobachtungen der Astronomie, vor allem durch Teleskope auf Satelliten.

Warum die experimentellen Erkenntnisse nicht von der Theorie abhängen

Eins ist bei diesen neuen Theorien jedoch zweifelsfrei klar: Sie müssen zu praktisch allen schon gemachten Experimenten der Teilchen- und Astrophysik zu den gleichen Ergebnissen kommen wie das Standardmodell mit den genannten Ergänzungen wie der Neutrinomasse, denn die Ergebnisse dieser Experimente würden sich ja durch eine neue Theorie nicht ändern. Anders von „alternativen Physikern“ oder postmodernen Philosophen und Wissenschaftstheoretikern gelegentlich behauptet wird, müsste man diese Experimente auch nicht völlig anders aufbauen, wenn man andere Theorien hätte, und es würde schon gar nichts anderes herauskommen. Hinter solchen Vorstellungen stecken typischerweise Fehlinterpretationen von Thomas S. Kuhns Untersuchungen zu Erkenntnisprozessen in der Wissenschaft und einmal wieder ein falsches Verständnis des Beobachtereffekts. Wenn in einem Beschleunigerzentrum wie dem CERN Kollisionen hochenergetischer Teilchen und damit letztlich Freisetzungen reiner Energie untersucht werden, sind die Experimente ohnehin so aufgebaut, dass praktisch alles gleichzeitig gemessen wird, was man dabei technologisch überhaupt messen kann. Es gibt auch keine andere Möglichkeit, unter kontrollierten Bedingungen zu messen, was passiert, wenn an einem Punkt große Energien frei werden. Die Teilchenphysik kann Experimente gar nicht darauf ausrichten, nur den einen Parameter gezielt zu messen, der zur Überprüfung einer einzelnen Theorie nötig ist – dafür sind die Entwicklungszeiträume viel zu lang. Als der LHC in den 1980er Jahren geplant wurde, ging man noch von einem viel schwereren Higgs-Teilchen aus, und die Supersymmetrie, nach deren Teilchen bislang erfolglos gesucht wird, galt noch als wesentlich unwahrscheinlicher als die inzwischen längst ausgeschlossenen einfachen GUTs. Hypothetissche Vorhersagen aus neuen Theorien ändern sich schneller, als man neue Beschleuniger und Detektoren planen und bauen kann. Der LHC am CERN wurde dementsprechend nicht nur gebaut, um das Higgs nachzuweisen, sondern um ganz allgemein zu erforschen, welche neuen Phänomene in einem gewissen Energiebereich auftauchen. Das macht die Experimente auch so groß und teuer. Wegen der großen Datenmenge pro Kollision kann man eine Vorauswahl der Kollisionsereignisse treffen, die man genauer untersucht, um zum Beispiel Eigenschaften des Higgs-Teilchens genauer zu bestimmen. Es wird jedoch immer auch eine große Zahl sogenannter Minimum-Bias-Ereignisse gespeichert, um auch nach noch ganz unbekannten und unerwarteten Phänomenen suchen zu können. Die Ergebnisse der Teilchenphysik sind also gerade nicht von der Theorie abhängig, sondern sie sind eine zwingende Grundlage für jede Theorie, die Aussagen über Teilchen machen will.

Was wir gar nicht wissen

Nun gibt es auch für eine sogenannte Theory of Everything wie die Stringtheorie, die alle Grundkräfte der Natur und alle Teilchen beschreiben soll, grundsätzliche physikalische Fragen zur Materie und dem Universum, die sie nicht beantwortet. Dazu gehört zum Beispiel die Frage nach Ereignissen „vor“ dem Urknall, sofern man außerhalb der Existenz unseres Universums überhaupt von zeitlichen Begriffen wie vor oder nach sprechen kann. Auch hierzu gibt es Ideen, die sich in der einen oder anderen Form in diese neuen Theorien oder auch das Standardmodell integrieren ließen. So könnte das ganze Universum als zufällige Fluktuation aus nichts entstanden sein, und es könnte sich auch zufällig wieder in nichts auflösen. Von einer experimentell prüfbaren Theorie kann man in Bezug auf solche Ideen aber zumindest aktuell noch nicht sprechen.

Vielleicht werden wir aber tatsächlich erst zu einer konsistenten neuen Theorie jenseits des Standardmodells kommen, wenn jemand zu ganz neuen Ideen für völlig anders strukturierte Theorien findet, die möglicherweise auch solche Fragen mit einschließen. Die heutigen Kandidaten als Nachfolger des Standardmodells sind ja in gewisser Weise recht konventionell: Sie versuchen, in Form von Eichtheorien die Ideen des Standardmodells so zu verallgemeinern, dass sich ein umfassenderes Bild ergibt. Vielleicht wird sich der richtige Weg als ein ganz anderer herausstellen. Auch für eine solche neue Theorie würden aber die gleichen Voraussetzungen gelten: Sie müsste erklären, warum für praktisch alles, was wir heute messen können, das herauskommt, was das Standardmodell vorhersagt, und sie müsste ihren eigenen Wert unter Beweis stellen, indem sie Dinge vorhersagt, die wir noch nicht anderweitig vorhergesagt und gemessen haben.

Schließlich gibt es auch Fragen, die sich gar nicht in einer physikalischen Theorie beantworten lassen. Hierzu gehören zum Beispiel Fragen nach einem eventuellen Sinn von Dingen oder ethische Fragestellungen, was man tun sollte oder nicht. Bei solchen Fragen kann naturwissenschaftliche Erkenntnis einen Hintergrund bieten und als Information dienlich sein – sie kann aber nicht die Antwort liefern. Dementsprechend problematisch ist es auch, aus der Physik heraus oder mit der Autorität des erfolgreichen Physikers Antworten auf solche Fragen geben zu wollen. Davor haben auch viele der großen Physiker des 20. Jahrhunderts (zum Beispiel Erwin Schrödinger, Max Born und Werner Heisenberg) ausdrücklich gewarnt – und so mancher konnte sich trotzdem genau das nicht verkneifen.

Was dieses Nichtwissen nicht heißt

Wenn wir die Antwort auf eine grundlegende naturwissenschaftliche Frage, sei es die Entstehung des Lebens oder die des Universums, nicht wissen, liegt offenbar für viele Menschen die Versuchung nahe, eine willkürliche Antwort zu behaupten. Die beliebteste dieser willkürlichen Antworten begegnet mir auch in Diskussionen nach meinen Vorträgen regelmäßig: „An der Stelle muss man dann wohl von Gott sprechen.“ Nein, muss man nicht, und sollte man auch nicht. Selbst Theologen wehren sich gegen eine solche Vorstellung, die Dietrich Bonhoeffer mit dem treffenden Begriff „Lückenbüßer-Gott“ bezeichnet hat. Für Wissenschaftler ist eine solche Vorstellung ein ernsthaftes Problem und im Extremfall sogar lebensgefährlich: Wenn naturwissenschaftliches Nichtwissen beliebig mit religiösen Behauptungen aufgefüllt wird, dann wird jede neue wissenschaftliche Erkenntnis zwangsläufig zur Häresie. Das gilt insbesondere dann, wenn es um Schöpfungsmythen oder um die grundlegenden Zusammenhänge der Welt geht. Die historischen Beispiele von Galileo und Darwin drängen sich auf, aber grundsätzlich ist nicht auszuschließen, dass sich auch die Vorstellung von Gott als Auslöser des Urknalls über die Jahrzehnte zu einem Dogma entwickeln könnte, dessen Widerlegung Empörungsstürme bis hin zu Morddrohungen auslösen würde.

Noch bizarrer wird es, wenn religiöse Gruppierungen pseudo-naturwissenschaftliche Elemente in ihr Weltbild aufnehmen und in der Folge versuchen, diese als „neue Physik“ an der Öffentlichkeit – zum Teil buchstäblich – zu verkaufen. In gewohnt unterhaltsamer Form tun sich hier immer wieder die transzendental meditierenden Maharishis hervor, deren Quantenquark fast noch unfreiwillig komischer ist als ihr yogisches Fliegen oder die Wahlwerbespots ihrer Naturgesetz-Partei. So ist bei Thomas J. Routt in einer Veröffentlichung der Maharishi University of Management nachzulesen, dass im digitalen Universum die kosmische Weltregierung alle Aspekte des Lebens mittels Quantencomputern steuert.

An der Maharishi European Research University (MERU) wollte der Chemiker Klaus Volkamer 1987 in vermeintlichen minimalen Gewichtsschwankungen verschweißter Glasampullen die Wirkung dunkler Materie nachgewiesen haben. Eine Erklärung, warum die dunkle Materie nur in bestimmte, aber nicht in andere Glasampullen kriechen sollte, blieb er schuldig. In den folgenden 30 Jahren tourte er mit „feinstofflichen“ Erweiterungen praktisch aller Naturwissenschaften durch die Esoterikszene. Neben den Maharishis taucht Quantenquark in letzter Zeit auch zunehmend im Umfeld der Hare-Krishna-Bewegung auf.

Pseudowissenschaft in neureligiösen Bewegungen beschränkt sich jedoch nicht auf Gruppen aus dem hinduistischen Umfeld und, offensichtlich, die Scientologen, wenn man diese denn wirklich als religiöse Gruppierung betrachten will. Einige Anhänger von Christian Science betrachten ihren Kult offensichtlich allen Ernstes als Medizin und sehen – das hingegen wenig überraschend – Zusammenhänge vor allem mit der Homöopathie. In einer Zeitschrift der dem Christentum nahestehenden Bewegung Universelles Leben erklärte der Arzt Manfred Doepp, hinter Antibiotika und Impfungen stecke „mangelndes Vertrauen zur Führung durch Gott“.

Das Prinzip, dass man nicht jeden Unsinn für wahr erklären darf, nur weil die Wissenschaft etwas nicht weiß, gilt natürlich nicht nur für die Religion. Das gleiche trifft auch auf Nassim Haramein zu, wenn er die Tatsache, dass zwei unterschiedliche Messmethoden unterschiedliche Ergebnisse für den Radius eines Protons ergeben, nutzt, um seine absurden Vorstellungen vom Proton als schwarzem Loch für valider als das Standardmodell zu erklären. Hohle-Erde-Gläubige argumentieren ähnlich, wenn sie wissenschaftliche Diskussionen unter Geophysikern über die Ursache einzelner Reflektionsherde von Erdbebenwellen im Boden, sogenannte bright spots, als Beleg für ihre kruden Thesen anführen. Kreationisten nutzen jede spannende Forschungsfrage innerhalb der Evolutionsbiologie, um zu erklären die Evolution sei umstritten.

Nein. Dass es irgendwo in der Wissenschaft offene Fragen gibt, über die diskutiert und an denen geforscht wird, heißt nicht, dass sämtliche Ergebnisse dieses Forschungsgebiets falsch sind. Es heißt auch nicht, dass man als Antwort auf diese Frage einfach irgendeine beliebige Behauptung als erwiesen hinstellen darf, auch nicht eine, an die schon vor 2000 Jahren irgendwer in Vorder- oder Südasien geglaubt hat. So leid es mir tut, es heißt auch nicht, dass stattdessen zwangsläufig Ihre ganz persönliche Privattheorie stimmt, nach der sämtliche Elementarteilchen winzige, in unterschiedlichen Pinktönen eingefärbte und telepathisch kommunizierende Einhörner sind. Es heißt noch nicht einmal, dass das Universum dadurch entstanden ist, dass es vom großen grünen Arkelanfall ausgeniest wurde.

Dass es in der Wissenschaft offene Fragen gibt, heißt einfach nur, dass die Wissenschaft noch lebendig ist, dass es noch etwas zu forschen und zu entdecken gibt – und genau das macht die Wissenschaft so viel interessanter als alle Dogmen und Heilslehren.