Dan Brown hat ein neues Buch geschrieben. Nein, ich verlinke das hier nicht.

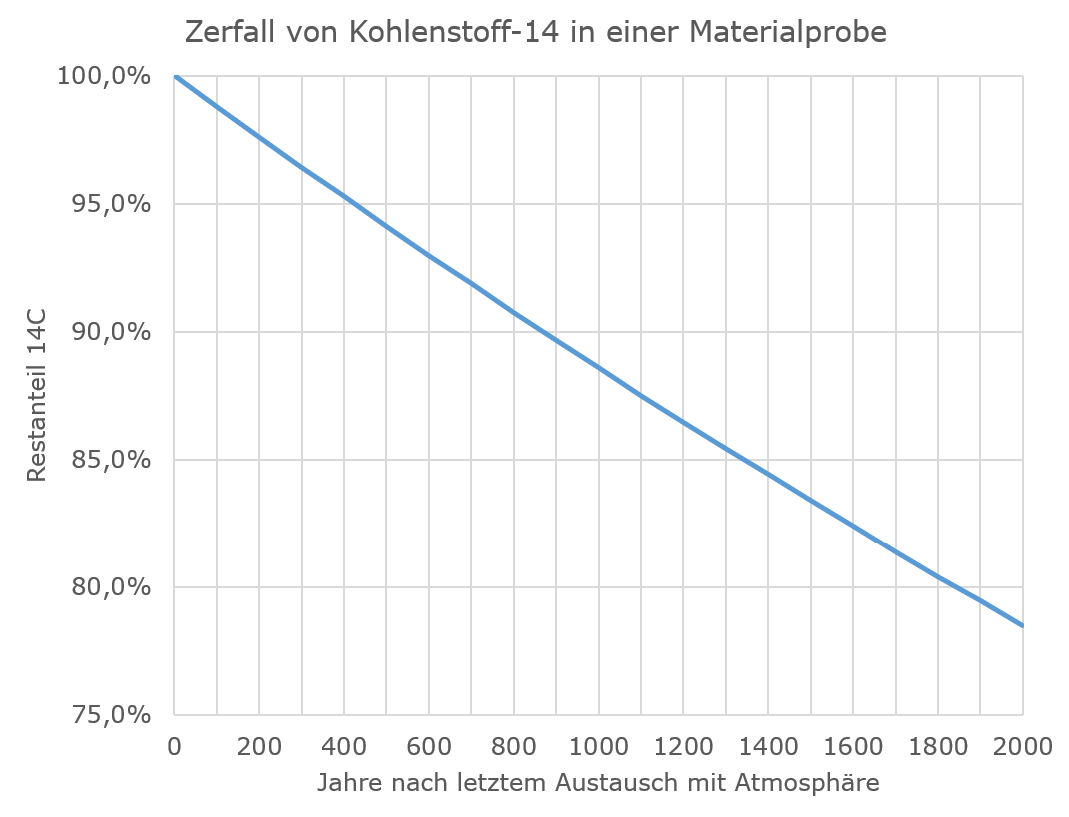

Bernd Harder ist bei Skeptix etwas ausführlicher darauf eingegangen, und es überrascht mich jetzt nicht wirklich, dass er wenig Positives darüber gefunden hat. Dan Brown ist – meine Überzeugung – schlicht und ergreifend ein schlechter Autor, und zwar aus einem ganz einfachen Grund: Gute Autoren, auch von rein fiktionalen Texten, informieren sich über das, worüber sie schreiben.

Zu diesem zugegebenermaßen wenig wohlwollenden Urteil komme ich übrigens, ohne jemals eins von Browns Büchern gelesen zu haben. Also, ich habe keins DURCHgelesen, was nicht heißt, dass ich es nicht versucht hätte. Ich kann nicht mehr ganz nachvollziehen, wie weit ich damals, vor gut 20 Jahren, in Browns erstem erfolgreichen Schinken Illuminati (Original: Angels & Demons) gekommen bin. Weit war es jedenfalls nicht, bevor ich es nicht mehr ausgehalten hätte, ohne meinem überbordenden Bedürfnis nachkommen zu können, den Autor anzuschreien.

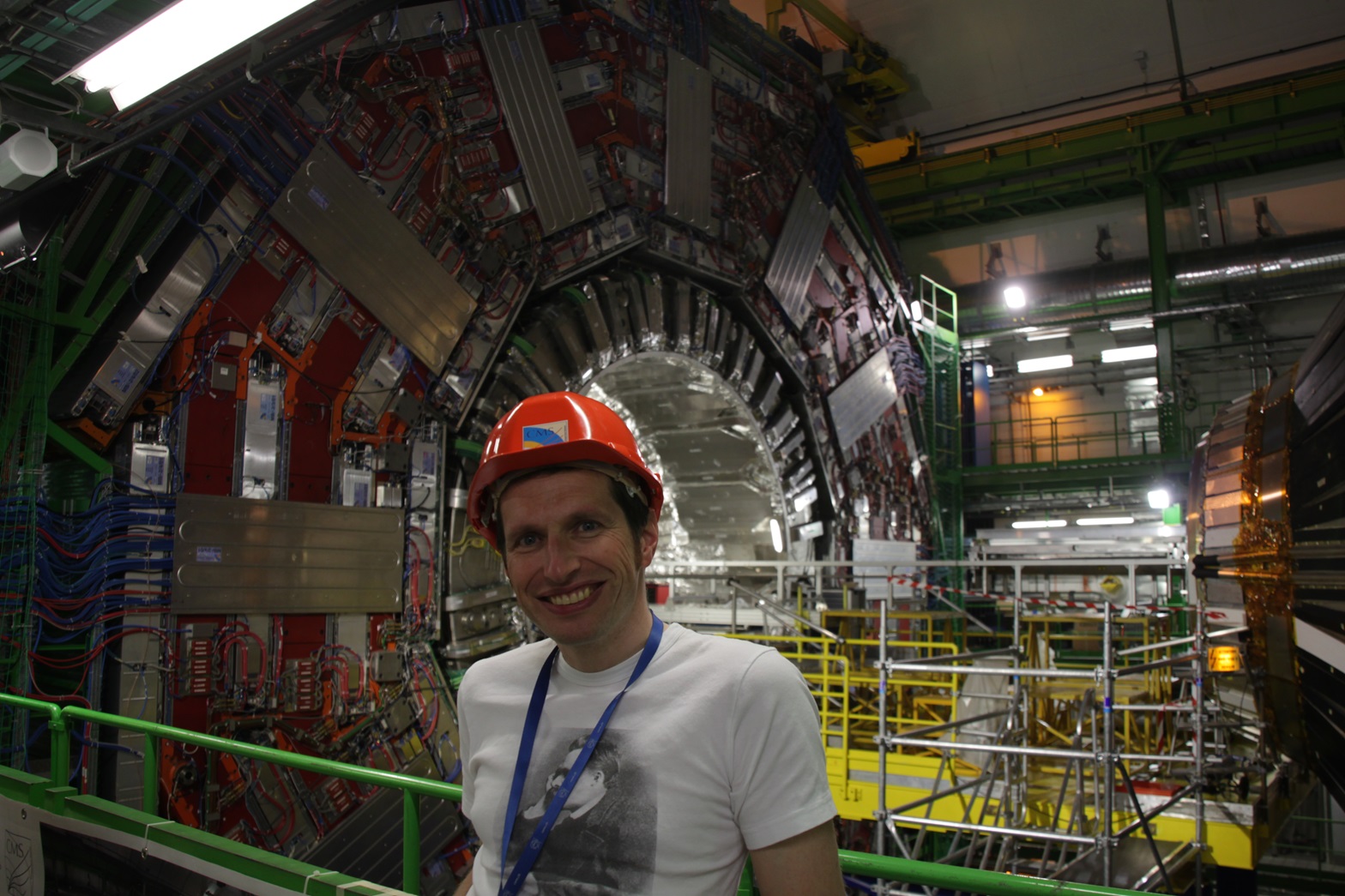

Neben allerlei absurden Verschwörungsmythen über die katholische Kirche und die Illuminaten steckt Illuminati praktisch von der ersten Seite an voll von falscher Physik und blühendem Blödsinn über das CERN. Nachdem ich mich irgendwann auch noch durch die Verfilmung gequält habe, kann ich immerhin sagen, ohne falsche Physik funktioniert die Grundidee der Handlung nicht, aber zumindest über das CERN hätte man sich ganz grob an die Wahrheit halten können, ohne dass etwas gefehlt hätte. Das hätte natürlich vorausgesetzt, dass man zum Beispiel ein paar Dinge über das CERN liest. Das wäre schon Ende der 1990er auch für einen bis dahin erfolglosen US-Autor problemlos auf der bereits sehr umfassenden Website des Forschungszentrums mit ihrer umfangreichen Photobibliothek möglich gewesen. Alternativ hätte man einfach mal mit jemandem sprechen können, der schon einmal dort war. Angesichts von rund 8000 Gastwissenschaftlern, die am CERN akkreditiert sind und von denen sich typischerweise rund 3000 dort aufhalten, ist es in so ziemlich jedem industrialisierten Land eigentlich nicht schwierig, ein paar davon ausfindig zu machen. Die meisten dieser Gastwissenschaftler freuen sich auch, wenn sich mal jemand von außerhalb für ihre Arbeit interessiert, und nichts von dem, was dort passiert, ist geheim. Naja, außer vielleicht noch unbestätigten Messergebnissen, über die man keine Gerüchte möchte und den Daten, die demnächst jemand in einer Doktorarbeit (und damit zwangsweise weltweit als Erster) veröffentlichen möchte. Aber, ja, das CERN ist von den Mitgliedsländern öffentlich finanziert, und alle Ergebnisse sind, sobald man sich hinreichend sicher ist, dass sie stimmen, öffentlich zugänglich. Um so bizarrer ist es da, wenn der Verlag sich in Browns Vorstellung am Beginn des Buches über dessen „intensive Reisen und Recherchen“ auslässt.

Schräg wird es schon in der Einleitung „Dichtung und Wahrheit“, zwei Seiten bevor der Verfasser in einer „Anmerkung“ noch wahrheitswidrig den Verschwörungsmythos verbreitet: „Die Bruderschaft der Illuminati existiert ebenfalls.“ In dieser Einleitung steht gleich die Kernüberlegung, ohne die man sich die gesamte folgende Geschichte sparen könnte. Okay, das kann man sowieso… „Ein einziges Gramm Antimaterie enthält die Energie von zwanzig Kilotonnen TNT – die Zerstörungskraft der Hiroshima-Atombombe“. Weiter in der Einleitung stellt Brown unter Verweis auf den damals gerade im Aufbau befindlichen Antiproton Decelerator des CERN die Frage, ob die dort gesammelte Antimaterie die Welt retten oder „zur Schaffung der tödlichsten Waffe aller Zeiten missbraucht“ werden würde. So wird denn im Roman auch ein Behälter mit Antimaterie aus dem CERN geraubt, mit dem dann am Ende Rom zerstört werden soll. Falls Ihr die Handlung noch nicht kennt, sorry für den Spoiler, aber, wirklich, Ihr verpasst nix. Und, ja, ich wäre mit der Handlung eines abstrusen Schwurbelromans wahrscheinlich gnädiger (hey, ich mag ja zum Beispiel auch James Bond und Star Trek…), wenn der Autor dem nicht die dreiste Behauptung voranstellen würde, das basiere alles auf Fakten.

Was hat es aber nun mit dieser angeblich so gefährlichen Antimaterie auf sich? Nun, als Antimaterie bezeichnen wir Teilchen, die identische Eigenschaften wie die uns bekannten Materieteilchen haben, aber die umgekehrte elektrische Ladung. Das häufigste und am längsten bekannte Antimaterieteilchen ist das Positron. Es war auch das erste von vielen Elementarteilchen, die zuerst theoretisch vorhergesagt und später gefunden wurden. Paul Dirac stieß 1928 auf das Positron als zweite Lösung einer Gleichung, die die Bewegung eines Elektrons im Einklang sowohl mit der Relativitätstheorie als auch mit der Quantenmechanik beschreiben sollte. Schon vier Jahre später wurde es von Carl David Anderson nachgewiesen, als er mit Hilfe eines Ballons untersuchte, was passiert, wenn kosmische Strahlung aus dem All auf die Atome unserer Atmosphäre trifft. Positronen entstehen in bestimmten radioaktiven Zerfällen oder aus der freigesetzten Energie, wenn relativ hoch beschleunigte Teilchen auf andere Materie treffen. Aus der Energie entstehen dann immer paarweise ein positiv geladenes Positron und ein negativ geladenes Elektron, weil die elektrische Ladung insgesamt ja erhalten bleibt. Die Produktion schwererer Antimaterieteilchen, darunter des Antiprotons, braucht erheblich mehr Energie, also wesentlich stärker beschleunigte Teilchen. Kurz nach ihrer Entstehung sind diese Antimaterieteilchen dann auch schon wieder verschwunden, weil jedes Positron mit dem ersten Elektron, jedes Antiproton mit dem ersten Proton, auf das es trifft, wieder zu Energie wird, meist in Form von Gammastrahlung, also Photonen. Das macht es sehr schwierig, mit diesen Antiteilchen Experimente zu machen, weil man sie nicht in einem Behälter aus Materie aufheben kann: Sie würden sich mit den entsprechenden Teilchen dieser Materie sofort wieder zu Strahlung umwandeln. Nur wenn diese Teilchen hinreichend langsam sind, kann man sie in sogenannten Ionenfallen, komplexen Magnetfeldern in einem Hochvakuum, für eine gewisse Zeit (denkt mal so in Millionstel Sekunden) festhalten, bevor sie wieder verschwunden sind. Genau für dieses „hinreichend langsam“ dient am CERN seit 2000 der Antiproton Decelerator. Produziert werden die Antiprotonen mit Hilfe des schon aus den 1970er Jahren stammenden ca. 7 Kilometer langen Ringbeschleunigers Super Proton Synchrotron (SPS).

Der Sinn dieser Übung ist weder, die Welt zu retten, noch Waffen zu entwickeln, sondern eins der großen Rätsel des Universums zu lösen: Wenn wir davon ausgehen, dass es vor unserem Universum zunächst nur Energie gab, sie sich beim Urknall in Materie und Antimaterie umgewandelt hat, dann stellt sich die Frage, warum das gesamte sichtbare Universum aus Materie besteht und die Antimaterie offenbar verschwunden ist. Eine denkbare Lösung ist, dass die Teilchen und Antiteilchen eben doch nicht genau gegengleich sind, sondern winzige Unterschiede aufweisen, die im Lauf der Milliarden Jahre zum Verschwinden der Antimaterie geführt haben könnten. Daher sucht die Teilchenphysik nach solchen winzigen Unterschieden. Alle Experimente mit den kurzlebigen einzelnen Antiteilchen haben aber nichts Derartiges ergeben. Eine deutlich höhere Empfindlichkeit versprach man sich von der Untersuchung ganzer Antimaterieatome. Das einfachste – und auf absehbare Zeit einzige systematisch zu produzierende – Antimaterieatom ist der Antiwasserstoff. Dabei ist ein Positron elektromagnetisch an ein Antiproton gebunden, so wie beim Wasserstoffatom ein Elektron an ein Proton, das dabei die Rolle des Atomkerns einnimmt. Die Antiprotonen sind dabei, wie schon erwähnt, wesentlich aufwendiger zu produzieren als die Positronen. Da die Antiwasserstoffatome bei ihrer Entstehung erst einmal überschüssige Energie enthalten, geben sie diese in Form von Photonen charakteristischer Wellenlängen ab, die man dann spektroskopisch untersuchen kann, genau wie bei der Spektroskopie normalen Wasserstoffs. Man vergleicht also auf der einfachsten Ebene die Chemie von Wasserstoff und Antiwasserstoff. Am CERN tat das seit 2002 vor allem das ASACUSA-Experiment – und fand keine Unterschiede. Wir wissen also immer noch nicht, wo nach dem Urknall die Antimaterie geblieben ist.

Wie sieht es aber mit Dan Browns „Gramm Antimaterie“ in einem transportablen Behälter aus? Einen Eindruck von den am Antiproton Decelerator produzierten Mengen an Antimaterie geben die Ergebnisse des ATHENA-Experiments, das die systematische Produktion von Antiwasserstoff am Antiproton Decelerator 2002 zuerst nachgewiesen hat. AHENA fand 50.000 Antiwasserstoffatome – das sind nicht etwa 50.000 Atome gleichzeitig (was etwa 0,000000000000000000008 Gramm entspräche), sondern im Lauf einer Messkampagne von mehreren Wochen 50.000 Atome, die jeweils für eine Größenordnung von Millionstel Sekunden existiert haben dürften. Es ist also sehr unwahrscheinlich, dass jemals mehr als eines dieser Atome gleichzeitig im ATHENA-Detektor existiert hat. Wer mehr Zeit und Motivation dazu hat als ich, kann die genauen Zahlen gerne in den alten Publikationen von ATHENA heraussuchen. Die Erzeugung dieser überschaubaren Zahl von Atomen sowie ähnlicher Mengen für die anderen Experimente am am Antiproton Decelerator erforderte für die Zeit dieser Messkampagne einen nennenswerten Teil des Gesamt-Stromverbrauchs des CERN. Dieser Stromverbrauch entspricht dem einer Stadt mit 300.000 Einwohnern. Das mag einen ungefähren Eindruck davon geben, wie absurd die Vorstellung ist, man könnte mit aktuell vorstellbarer Technik Mengen an Antimaterie erzeugen, mit denen man irgendwelchen Schaden anrichten kann.

Was die Aufbewahrung solcher Antimaterie in einem transportablen Behälter betrifft, kann vielleicht dieses Bild des ASACUSA-Experiments einen Eindruck vermitteln.

Die eigentliche Ionenfalle, in der sich für Sekundenbruchteile Antiwasserstoffatome bilden und untersucht werden, ist im Hintergrund; davor befindet sich noch die Falle für die Antiprotonen, aus denen die Atome entstehen sollen, und die Anlage mit dem horizontalen Zylinder rechts liefert die benötigten Positronen. Der große Flüssig-Helium-Tank im Vordergrund ist Teil der Kühlanlage. Wen es interessiert, hier sieht man den Aufbau schematisch.

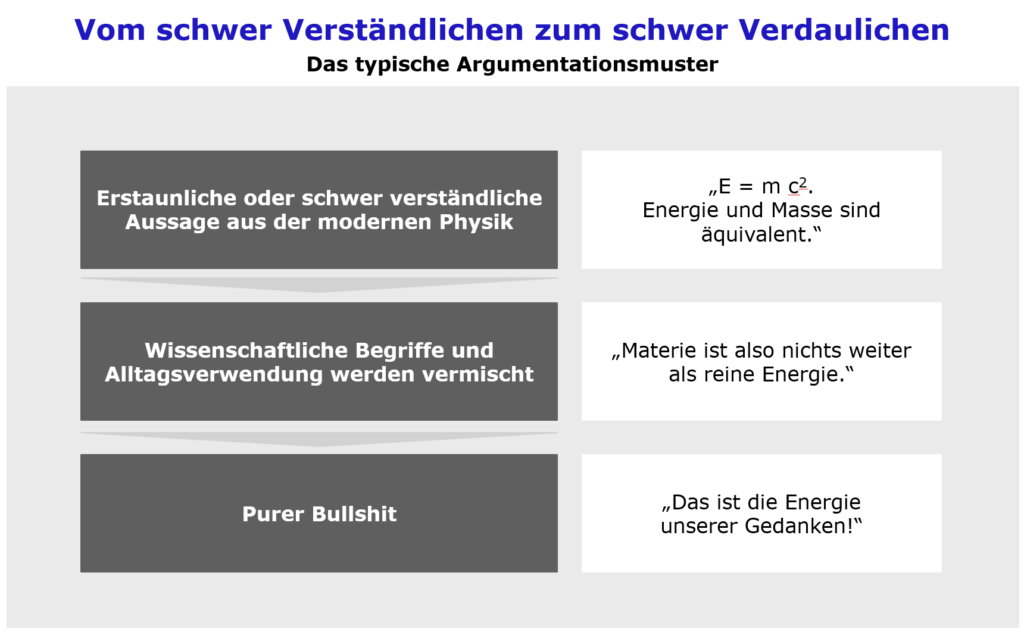

Richtig wild wird es aber, wenn Brown das CERN selbst beschreibt. Nur am Rande erwähnen will ich dabei, dass der Leiter des Antimaterieexperiments in Browns Roman an prominenter Stelle in seinem Büro Fritjof Capras „Tao der Physik“ stehen hat – einen absoluten Klassiker des Quantenquarks, der nichts mit seriöser Physik zu tun hat. Gleich zu Beginn des Romans wird der Protagonist Robert Langdon von einem futuristischen, CERN-eigenen Hyperschallflugzeug abgeholt, das den Achtstundenflug von Boston nach Genf in einer Stunde schafft. Nun verfügt das CERN tatsächlich über eigene Transportmittel. Neben ein paar Spezial-LKWs für Gerätschaften sind das aber vor allem diese hier:

Die sind im und um das CERN tatsächlich allgegenwärtig. Außerdem hat natürlich auch die Werksfeuerwehr eigene Fahrzeuge. Die ist wirklich interessant, denn neben der Funktion als nächtliches Sammeltaxi zwischen den CERN-Standorten für Schichtarbeitende nimmt die Feuerwehr im CERN auch Polizeiaufgaben wahr. Die CERN-Standorte gehören als exterritoriales Gebiet nach Beschluss der UNESCO nämlich weder zur Schweiz noch zu Frankreich, und so ist auch die dortige Polizei nicht zuständig. Für mich wurde das mal sehr greifbar, als ich im französischen Standort in Prévessin mein Portemonnaie verloren hatte und mich erst die französische Polizei an die CERN-Verwaltung, dann diese an die Feuerwehr verwies. Die Frage, was passieren würde, wenn es im CERN zu einem echten Schwerverbrechen käme, wäre also ein spannendes Thema für Krimiautoren – nur eben für welche, die auch tatsächlich recherchieren, worüber sie schreiben. Ganz sicher würde Generaldirektorin Fabiola Gianotti einen Mord nicht verheimlichen und die Leiche einfrieren lassen.

Für CERN-Mitarbeiter und Gäste sind auch nicht, wie Brown behauptet, Pässe unnötig. Das von der Schweiz zugängliche Hauptgelände hat tatsächlich eine Ausfahrt nach Frankreich, am Grenzübergang vorbei, aber die wird vom eigenen Sicherheitsdienst kontrolliert und darf nur für Transporte von CERN-Material zwischen den Standorten verwendet werden. Dafür waren die Zugangskontrollen zum Gelände zumindest zu meiner Zeit nicht sonderlich streng – dort passiert ja nichts Geheimes oder Gefährliches. Wer den Parkausweis an der Windschutzscheibe hatte, wurde nur stichprobenartig nach einem Mitarbeiterausweis gefragt und konnte auch persönliche Gäste mit aufs Gelände bringen. Vermutlich läuft das jetzt alles elektronisch. Für den Grenzübertritt zwischen der Schweiz und Frankreich muss man aber (außer eben bei Materialtransporten) ganz normal über den Grenzübergang, mitunter mehrmals am Tag, wenn man zum Beispiel in einem französischen Standort arbeitet und die bessere Kantine im Hauptgelände nutzen will, oder wenn man auf dem Hauptgelände arbeitet und günstiger in Frankreich wohnt. Dabei kann es einem gerade Richtung Schweiz auch jederzeit passieren, dass einem der Zoll das komplette Auto ausräumt. Besonders häufig passierte das seinerzeit einem Frankfurter Kollegen, der sich von seinem Postdoc-Gehalt und/oder Erbe irgendwie einen Lotus Elise zusammengespart hatte…

Herzlich gelacht, wenn ich noch hätte lachen können, hätte ich bei der Ansammlung futuristischer Gebäude, als die Dan Brown das CERN beschreibt. Im Großen und Ganzen sieht das CERN-Hauptgelände bei Meyrin nicht viel anders aus als große Industriegelände in Wolfsburg, Bitterfeld oder Leverkusen. Ja, es gibt ein paar halbwegs modern aussehende Zweckbauten, darunter das Besucherzentrum, die Verwaltung des LHC-Beschleunigers und das neuere Wohnheim für Gastwissenschaftler. Die Asbestsanierung des alten Gebäudes 60, in dem die Generaldirektorin residiert, dürfte inzwischen abgeschlossen sein und wird vom Architekturbüro als Aushängeschild genutzt. Ein großer Teil der Hauptverwaltung befindet sich gleich um die Ecke davon, hier:

Am größten Standort auf der französischen Seite, in Prévessin, ist der Hauptunterschied, dass dort mehr Platz ist, aber auch alles etwas verschlafener aussieht. Das Gebäude, in dem ich in den 1990ern hauptsächlich gearbeitet habe, hatte sich beim letzten Besuch jedenfalls kaum verändert. Ich würde ihm mal etwa den Charme einer Frankfurter Gesamtschule zuschreiben.

In diesem Gebäude ist uns bei einem Besuch 2014 mal eben Nobelpreisträger Samuel Ting über den Weg gelaufen:

Wie dem Bild leicht zu entnehmen ist, ja, man kann das besichtigen. Das CERN hat ein Besucherzentrum, und wenn man eine kostenlose Tour bucht, bekommt man echte Experimentieranlagen zu sehen, an denen eben gerade keine empfindlichen Messungen stattfinden und keine Strahlung auftritt. Ich kann das nur empfehlen, vor allem zwischen Ende 2026 und 2029, solange sich der Hauptbeschleuniger LHC in der Umbauphase befindet und man mit etwas Glück, wie hier 2014 am CMS-Experiment, Anlagen zu sehen bekommt, die dann wieder für Jahre gesperrt sein werden.

Bitte tut das auf jeden Fall, bevor Ihr Bücher über das CERN schreibt.

Die wohlwollendste Hypothese für Browns Unsinn ist wahrscheinlich, dass er auf ein Stück (möglicherweise vom CERN selbst) fahrlässig aufgeplusterter Wissenschafts-PR in einem populärwissenschaftlichen Zeitungsartikel gestoßen ist und dazu schlicht überhaupt nicht recherchiert hat. Die weniger wohlwollende ist, dass er sich bewusst eine wüste Räuberpistole aus den Fingern gesogen hat und dabei, anstatt einfach eine Institution zu erfinden, zumindest in Kauf genommen hat, den Namen eines der bedeutendsten Wissenschaftsprojekte unserer Zeit in den Dreck zu ziehen.