18 Jahre nach den Anschlägen des 11. September gehört es schon fast zu den regelmäßigen Ritualen, dass es alle paar Jahre die Verschwörunsmythen-Community aufs Neue verkündet: Dieses Mal wäre nun wirklich, echt, ganz unzweifelhaft, eindeutig unwiderlegbar der Beweis erbracht, dass die Anschläge in Wirklichkeit gar keine Anschläge wären, sondern ein perfider Plan der amerikanischen Regierung, der CIA, des Mossad, der Uno, der Freimaurer, der Juden – oder eben von allen zusammen. Normalerweise kann man das alles getrost ignorieren, weil dabei nun wirklich nie irgendetwas Relevantes Neues herauskommt, und Quantenquark im engeren Sinne ist es auch nicht. Da ich dem 11. September aber im Verschwörungsmythen-Buch ein ganzes Kapitel gewidmet habe, möchte ich doch in der Art eines Online-Nachtrags auf die aktuelle Sau eingehen, die dazu durchs globale Dorf getrieben wird. Vorgehen werde ich dabei von der Frage, wer das verbreitet, über ein paar Hintergründe zu der Untersuchung, auf die sich die Meldungen beziehen und einige ganz grundsätzliche Fragen zu den Behauptungen, die in der Untersuchung aufgestellt werden, hin zu ein paar Schlaglichtern auf Details, die angeblich herausgefunden wurden. Das ganze 114seitige Werk auseinanderzunehmen, übersteigt sowohl meine Fachkompetenz in bauingenierwissenschaftlichen Detailfragen als auch meine verfügbare Freizeit, und es würde auch den Rahmen eines Blogartikels sprengen. Lang wird er trotzdem werden. Sollten Sie irgendwann das Gefühl haben, Sie hätten genug gelesen, steigen Sie jederzeit gerne aus – Sie verpassen keine Schlusspointe. Sollten Sie am Ende immer noch nicht genug haben, dann werden Sie sicherlich zu so ziemlich jedem der angesprochenen Themenbereiche detailliertere Analysen vor allem auf amerikanischen Seiten wie Metabunk finden. Dort werden in einer Forumsstruktur Informationen kollaborativ zusammengetragen, ausgewertet und diskutiert, was logischerweise weit über das hinausgeht, was ich als Einzelner an ein paar Abenden meiner Freizeit leisten kann.

Sensationsmeldungen von den üblichen Verdächtigen

„Die Sprengung“ titelt Daniele Ganser im Verschwörungsmythenblog Rubikon News und erklärt, „die ganze Geschichte zum Terroranschlag vom 11. September 2001“ müsse „neu geschrieben werden“. Das Problem mit Ganser ist, dass ihn gerade deutsche und schweizer Linke oft immer noch für einen seriösen Wissenschaftler halten. Der Grund ist offenbar, dass er einst in seiner Doktorarbeit öffentlich bekannte Informationen und Verschwörungsdenken in einer Weise zusammengerührt hat, die möglicherweise geeignet ist, gegen die NATO zu agitieren – wenn man bereit ist, den historischen Kontext der Bedrohung durch den Warschauer Pakt komplett zu ignorieren. Heute tritt Ganser auf Veranstaltungen des rechtsesoterischen Kopp-Verlags auf und veröffentlicht seine Artikel bei Rubikon News, wo sich auch Peter Frey (nicht der vom ZDF) verständnisvoll in die verletzte Seele des jungen Adolf Hitler einfühlen darf und zum Fazit gelangt, Hitler sei kein Unmensch gewesen, sondern ein Gebrochener. So ist es denn auch wenig verwunderlich, dass die gleiche Geschichte wie von Ganser auch von den russischen Auslandspropagandamedien RT Deutsch und Sputniknews verbreitet wird, wobei sie gelegentlich auch in Onlinemedien wie das Technologie-und-Vermischtes-Sammelsurium Telepolis und in die britische Boulevardpresse überschwappt. Als Quelle dieser neuen Erkenntnisse gibt eine Seite mit dem bezeichnenden Titel Grenzwissenschaft-aktuell eine Studie der University of Alaska Fairbanks (UAF) an.

Die Sensation: Ein „Entwurf“ für eine Veröffentlichung

Dass sich ausgerechnet die UAF an der Verbreitung von Verschwörungsmythen beteiligen soll, ist zumindest pikant: Diese Universität betreibt auch das Atmosphärenforschungszentrum HAARP, von dem unter anderem die Innsbrucker Professorin Claudia von Werlhof behauptet, es sei dazu geeignet, als Waffe gezielt Erdbeben in fernen Erdteilen auszulösen. Die UAF wird also selbst oft genug zur Zielscheibe derselben Szene, die sich jetzt auf eine Studie dieser Universität beruft. Es lohnt sich daher auf jeden Fall ein Blick auf diese Studie, die als „Entwurf“ von einer Unterseite der Universitätswebsite herunterzuladen ist. [Nachtrag 27. März 2020: Inzwischen ist aus dem „Entwurf“ ein „Final Report“ geworden, was nicht etwa heißt, dass da etwas in einem seriösen Journal veröffentlicht worden wäre, sondern einfach nur, dass der Autor meint, er sei jetzt fertig.] Sie trägt den Titel „Eine strukturelle Neubewertung des Einsturzes von World Trade Center 7“ und beschäftigt sich ausschließlich mit diesem kleineren Wolkenkratzer etwas abseits der Zwillingstürme. Zum World Trade Center 7 (WTC 7) hatte ich schon vor einigen Jahren einen Artikel im Skeptiker verfasst, der auch als Dreiteiler im GWUP-Blog veröffentlicht ist. Das Gebäude ist 2001 durch Brände eingestürzt, die beim Zusammenbruch der Zwillingstürme ausgebrochen waren. Genau diesen Zusammenhang zwischen den Bränden und dem Einsturz bestreitet die „Neubewertung“ aus Alaska.

Ein Autor im Ruhestand und Finanzierung aus der Schwurbelszene

Der Entwurf gibt drei Autoren von unterschiedlichen Institutionen (darunter einen außerordentlichen Professor der Technischen Universität Nanjing in China) an, was den Eindruck einer institutsübergreifenden Zusammenarbeit erweckt. Tatsächlich waren die beiden Koautoren zum Zeitpunkt ihrer Beteiligung jedoch Doktoranden des Hauptautors Leroy Hulsey an der UAF. Beide stammen aus China und sind erst nach ihrem Bachelorabschluss in die USA gekommen, direkt an die UAF. Der Entwurf war für die beiden auch nicht Teil ihrer Doktorarbeiten, sondern allenfalls eine Nebentätigkeit: Einer hat über die Feuerbeständigkeit von Gipsplatten promoviert, der andere über die Überwachung von Schäden an Brücken. Ob ihr Beitrag zu dem Entwurf über eine reine Datencodiertätigkeit hinausgeht, bleibt also unklar. Hulsey ist an der UAF offiziell Dozent und betreut laut Homepage auch noch wissenschaftliche Arbeiten, befindet sich jedoch mit 78 Jahren schon weit im Ruhestandsalter. Es handelt sich bei dem Text also nicht um eine Veröffentlichung in einem wissenschaftlichen Journal oder um eine offizielle Stellungnahme der Universität, sondern um die Forschungsfreiheit eines Pensionärs, der aufgrund seiner früheren Arbeit noch die Einrichtungen der Universität dafür nutzen darf. Ähnlich wie bei emeritierten Professoren in Deutschland ist es in den USA nicht unüblich, dass solche Professoren keine Lehrverpflichtungen mehr haben, die Ressourcen der Universität aber noch für eigene Forschungen nutzen können, bei deren Themenauswahl ihnen in der Regel niemand mehr hineinredet. Angesichts der katastrophalen Finanznot dieser Universität dürfte das erst recht für Projekte gelten, die aus Drittmitteln finanziert werden. Im Fall der „Neubewertung“ stammen diese Drittmittel ausgerechnet von der Verschwörungsgläubigen-Organisation Architects & Engineers for 9/11 Truth, womit das Ergebnis der Untersuchung dann auch nicht mehr sonderlich überraschend ist. Natürlich ist der Ausgang einer wissenschaftlichen Untersuchung nicht vom Geldgeber abhängig, solange sie seriös durchgeführt und veröffentlicht wird, aber dieser Propagandaverein hätte seine von besorgten Bürgern eingesammelten Spenden wohl kaum einem Wissenschaftler anvertraut, bei dem das Ergebnis der Untersuchung in Frage gestanden hätte.

Wie seine beiden Doktoranden ist Hulsey tatsächlich Bauingenieur. Es deutet jedoch nichts darauf hin, dass er irgendwelche Erfahrung im Bau oder der Untersuchung von Wolkenkratzern hätte: Seine Veröffentlichungsliste dreht sich, abgesehen von ein paar Arbeiten über Straßenbeläge, fast ausschließlich um die Konstruktion von Brücken unter subarktischen Bedingungen. Hulseys Arbeitsschwerpunkt bei eher horizontalen, frei tragenden Kontruktionen lässt sich in der „Neubewertung“ durchaus wiedererkennen: Mit großer Akribie wird die Modellierung einzelner tragender Teile in den vermutlich zuerst abgestürzten unteren Etagenböden beschrieben, und ihre Eigenschaften unter thermischer Belastung werden detailliert diskutiert. Wo es um die Statik des Gebäudes insgesamt geht, rezitiert er jedoch eher fahrig die Ergebnisse seiner Modellrechnung, ohne auf die Implikationen einzugehen oder auch nur ihre Plausibilität zu hinterfragen.

Der Wissensstand zu World Trade Center 7

Wie bereits erwähnt, geht es in der Studie ausschließlich um das Gebäude WTC 7. Es wurde am 11. September 2001 beim Einsturz des Nordturms schwer beschädigt und geriet in Brand. Nachdem die mit der Gesamtsituation überforderte Feuerwehr die Brände kaum bekämpfen konnte, wüteten diese über mehr als sechs Stunden, bis das Gebäude schließlich einstürzte. Dass Stahlkonstruktionen durch die Hitzeentwicklung bei längeren Bränden an Stabilität verlieren, war schon vor dem 11. September nichts Neues, einerseits weil Stahl bei Temperaturen über 600° weich wird, andererseits wegen der thermischen Ausdehnung von Bauteilen. Da so ein Hochhaus aber eben so unverrückbar stabil aussieht, ist das für viele Leute schwer zu verstehen, und die Behauptungen von Ganser & Co fallen auf fruchtbaren Boden. Die derzeit gründlichste Analyse, was in diesem Fall genau passiert sein dürfte, findet sich im Bericht der amerikanischen Standards- und Eichbehörde NIST aus dem Jahr 2008. Der dreiteilige, rund 920-seitige Bericht, an dem mehr als 100 Personen mitgearbeitet haben, stützt sich neben Bild- und Videoaufnahmen sowie Brandanalysen vor allem auf eine detaillierte Finite-Elemente-Simulation des gesamten Gebäudes. Bei einer solchen Simulation wird ein Bauteil oder ein ganzes Gebäude in eine Vielzahl fiktiver kleiner Einzelteile zerlegt, die sich durch einfache Kennzahlen wie Gewicht, Bruchfestigkeit und Elastizität beschreiben lassen. Diese notwendigen Vereinfachungen sind schwierig und niemals perfekt, weshalb schon im Titel des Abschlussberichts ausdrücklich von einem wahrscheinlichen Einsturzverlauf die Rede ist. Danach brachen durch thermische Ausdehnung vermutlich zuerst Deckenträger in den brennenden unteren Stockwerken aus ihren Halterungen, und durch die abstürzenden Decken verloren einzelne senkrechte Säulen im Gebäude ihre Stabilität. Daraufhin kollabierte zuerst der Gebäudekern und ein paar Sekunden später die Fassade. Etwas ausführlicher beschrieben ist das im entsprechenden Kapitel des Verschwörungsmythen-Buchs.

Jetzt also noch ein Versuch mit der gleichen Methode

Hulseys Studie kontrastiert sich in erster Linie mit dem NIST-Bericht und verfolgt das offensichtliche Ziel, diesen zu diskreditieren. Daneben vergleicht Hulsey seine Ergebnisse auch mit zwei weniger umfassenden Simulationen aus gegensätzlichen Gutachten zu einem Gerichtsverfahren aus dem Jahr 2013: Der Stromversorger Con Ed als Betreiber einer beim Einsturz zerstörten Transformatorstation unter dem Gebäude hatte gegen die Erbauer wegen vermeintlicher Baumängel geklagt. Beide Gutachten kamen zu abweichenden, aber im Grundsatz ähnlichen Ergebnissen wie das NIST, welche Deckenträger genau aus welchem Grund abgestürzt sind und den weiteren Einsturz ausgelöst haben. Hulsey nutzt ebenfalls Finite-Elemente-Simulationen und betont mehrfach, von gleichen Annahmen wie das NIST ausgegangen zu sein – er kommt aber zu ganz anderen Ergebnissen. Danach hätten weder die Etagenböden abstürzen noch deren Absturz den Einsturz der zentralen Gebäudesäulen auslösen sollen, und auch bei einem Einsturz dieser Säulen hätte nach Hulseys Simulation das Gebäude nicht in der beobachteten Form einstürzen dürfen. Hulsey schreibt, er hätte seine Berechnungen parallel mit zwei unterschiedlichen Simulationssoftwares vorgenommen, aber weitgehend gleiche Ergebnisse erhalten. Das ist nicht weiter überraschend: Die Hauptfehlerquelle bei Finite-Elemente-Berechnungen ist nicht die Simulation selbst, sondern die Modellierung der Eingangsparameter mit den unvermeidlichen Vereinfachungen. Bei identischer Modellierung sollten unterschiedliche Softwarepakete sehr ähnliche Ergebnisse liefern. Insgesamt ist die Methode jedoch mit hohen Unsicherheiten behaftet: Im Zusammenhang mit meiner Doktorarbeit hat ein sehr erfahrener Ingenieur solche Simulationen zur Deformation der relativ einfachen Aluminiumstruktur eines Detektorgerüsts unter seinem eigenen Gewicht ausgeführt. Dazu erinnere ich mich an Abweichungen von den später gemessenen Werten um rund ein Viertel. Da in solchen Softwarepaketen in der Regel zum Beispiel die Tragkraft eines Bauteils unabhängig von seiner Ausdehnung und seinem Gewicht definiert werden kann, ist es, wenn man nicht aufpasst, auch durchaus möglich, Modelle zu konstruieren, die grundlegenden Gesetzen der Physik widersprechen. Grundsätzlich gilt für die Finite-Elemente-Methode das einfache Prinzip jeder Simulationsrechnung: Shit-in – Shit-out. Das betrifft die NIST-Berechnung wie die anderen erwähnten Simulationen: Sie sind fehlerbehaftet und immer nur so gut wie ihre Annahmen.

Zumindest in Teilaspekten sollte Hulsey kompetent sein

Zur Qualität der Modellierung von Hulsey in ihren Details und im Vergleich zu den drei anderen Simulationen kann ich nichts sagen. Dazu fehlen mir nicht nur die Fachkompetenz und die Zeit, sondern auch die Detailinformationen, was er in seiner Modellierung eigentlich genau gemacht hat. Das grundsätzliche Problem der Konstruktion von Etagenböden und ihrer Träger erscheint mir jedoch durchaus Ähnlichkeiten zu Hulseys Fachgebiet, dem Brückenbau, zu haben. Man muss also davon ausgehen, dass er und seine Doktoranden grundsätzlich Ahnung hatten, was sie da taten. Der betreffende Teil der Arbeit ist im Text auch einigermaßen gut dokumentiert, wenngleich bei weitem nicht in dem Detailgrad wie im Bericht des NIST. Sofern er nicht bewusst manipuliert hat, sollten die Bewegungen der einzelnen Bauteile durch den Brand durch sein Modell also nicht völlig abwegig berechnet werden. Dasselbe gilt aber eben auch für die Simulationen der beiden Gutachterbüros aus dem Gerichtsverfahren und vor allem für die des NIST, das vor mehr als zehn Jahren zwar noch nicht die heutigen Rechner hatte, aber für Recherche und Modellierung auf wesentlich mehr Ressourcen zugreifen konnte. Hulseys Modellierung ist also nur eine weitere Berechnung, die von der Betrachtung der Modelle her im besten Fall halbwegs gleichwertig neben drei anderen stehen könnte. Auf dieser Detailebene ist ein Abgleich mit der Realität schwierig, weil es um zunächst kleine Verformungen tief im Inneren des Gebäudes geht, von denen keinerlei Aufnahmen existieren und deren Spuren beim endgültigen Einsturz und darauf folgenden Abriss zerstört wurden.

Die Interpretation der Ergebnisse unterstellt eine sehr wirre Verschwörung

Zu einer wesentlich aussagekräftigeren Einschätzung, wie realistisch Hulseys Berechnung ist, gelangt man, wenn man seine Ergebnisse für das Gesamtgebäude einschließlich seiner Schlussfolgerungen daraus ernst nimmt und sich überlegt, was das für die Realität bedeuten würde. Von einer Sprengung ist in diesen Schlussfolgerungen nicht ausdrücklich die Rede – eine solche kommt im gesamten Text überhaupt nicht explizit vor. Hulsey schreibt jedoch: „Das nahezu gleichzeitige Versagen aller Säulen ist das einzige Szenario, das wir gefunden haben, das in der Lage war, das beobachtete Verhalten zu produzieren.“ Dieses „beobachtete Verhalten“ identifiziert Hulsey als einen senkrechten Einsturz mit nahezu Fallgeschwindigkeit. Mit anderen Worten, Hulseys Modell stürzt nur dann senkrecht ein, wenn alle tragenden Säulen gleichzeitig versagen – wenn wie im NIST-Modell zunächst einzelne Säulen ausfallen, stürzt Hulseys Modell entweder gar nicht ein, oder es kippt zur Seite um.

Für ein solches gleichzeitiges Versagen von 81 Säulen, von denen die dickeren rund 60 Zentimeter Durchmesser hatten, auf Höhe der unteren Stockwerke lässt sich aber nun tatsächlich schwerlich eine andere Erklärung finden als eine präzise gesteuerte Zündung von mindestens 81 einzelnen starken Sprengvorrichtungen. Das wertet Ganser somit als Beweis für eine Sprengung des Gebäudes. Damit unterstellt er der ominösen Macht, die die Sprengung vorgenommen haben soll, allerdings eine ziemlich seltsame Vorgehensweise. Um Sprengmechanismen an allen 81 Säulen anbringen zu können, hätte man im laufenden Betrieb mindestens ein vermietetes Stockwerk vollständig entkernen müssen. Da die äußeren Säulen Teil der Fassadenstruktur sind, wäre es zudem kaum möglich gewesen, Schneidladungen, die eine solche riesige Stahlsäule durchtrennen können, so anzubringen, dass sie nicht außen auf der Fassade zu sehen gewesen wären. Der riesige Aufwand wäre zudem völlig überflüssig gewesen. Bei Abbruchsprengungen strebt man nur deshalb häufig einen senkrechten Einsturz an, weil man Schäden in der Umgebung minimieren will. Am Nachmittag des 11. September waren jedoch alle Gebäude zumindest an der Südseite von WTC 7 wenigstens abbruchreif, wenn nicht schon eingestürzt. Um WTC 7 zum Einsturz zu bringen, hätte es völlig ausgereicht, einige Säulen an der Südseite des Gebäudes zu zerstören, um das Gebäude zumindest nach Hulseys Modell zu dieser Seite umkippen zu lassen, was weitaus eher der naiven Erwartung der meisten Menschen entsprochen hätte, zumal die Schäden durch den Einsturz der Zwillingstürme auch auf der Südseite waren. Stattdessen müsste Gansers ominöse Macht einen gigantischen zusätzlichen Aufwand getrieben haben, nur um eine Sprengung, die nicht als Sprengung erkannt werden sollte, genau wie eine Sprengung aussehen zu lassen. Das wäre jedoch nicht die einzige höchst seltsame Entscheidung dieser Dunkelmänner. Wie auf vielen Videos zu erkennen ist, stürzte das sogenannte östliche Penthaus, ein Dachaufbau für die Gebäudetechnik, rund sieben Sekunden vor dem Rest des Gebäudes ein – und damit lange vor den von Ganser behaupteten und von Hulseys zumindest unterstellten Sprengungen. In der NIST-Berechnung ist dies einfach eine Folge des Zusammenbrechens der ersten Säulen im Gebäudekern. Hulsey schreibt jedoch selbst, dass dieser Penthaus-Einsturz nach seinem Modell nur durch das Versagen von drei Säulen oberhalb des 45. Stockwerks zu erklären ist. Die Verschwörer hätten also wenige Sekunden vor der Sprengung aller 81 Säulen auf der Höhe eines der unteren Stockwerke schon einmal drei dieser Säulen auf der Höhe eines der obersten Stockwerke sprengen müssen. Wozu das hätte gut sein sollen, erklären weder Ganser noch Hulsey. Man kann also entweder annehmen, dass im WTC 7 eine mächtige Verschwörung mit riesigem Aufwand völlig wirr irgendwelche sinnlosen Sprengungen vorgenommen hat – oder dass Hulseys Modell einfach die Statik des Gesamtgebäudes falsch wiedergibt.

Hulseys Modell beschreibt auch den Einsturz falsch

Will man Hulseys Berechnung ernst nehmen, dann muss man eine Verschwörung annehmen, die allerlei umständliche und überflüssige Handlungen vornimmt. Ein solches Überladen der vermeintlichen Abläufe mit immer neuen Wendungen, um die Widersprüche in der vorigen Version zu erklären, ist ein typisches Merkmal moderner Verschwörungsmythen. Es ist für sich genommen aber kein Beweis, dass Hulseys Modell nicht der Realität entspräche. Betrachtet man seine Ergebnisse jedoch genauer, dann finden sich eine ganze Anzahl unrealistischer Modellaussagen, vor allem bezogen auf das Gebäude als Ganzes.

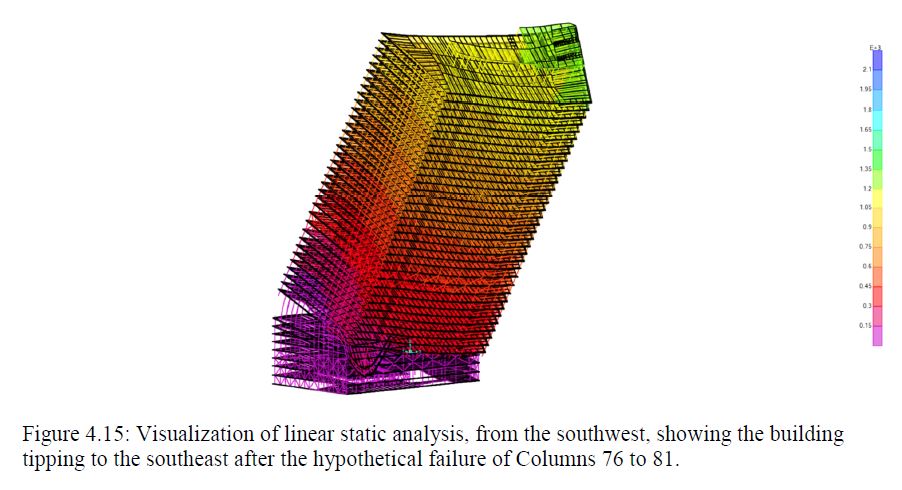

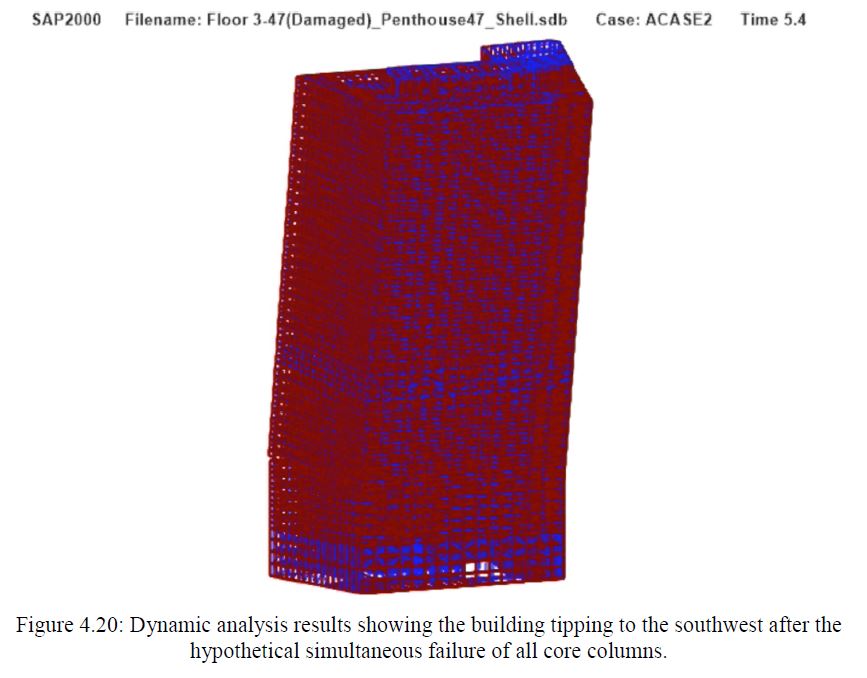

Im oben eingefügten Ausschnitt aus Hulseys Entwurf kippt als Ergebnis des Ausfalls dreier Säulen im Inneren des Gebäudes der ganze obere Teil des Gebäudes um wie ein Dominostein. Selbst in dem Bereich, in dem sie mit dem noch stehenden Gebäudestumpf kollidiert, wird die kippende Struktur kaum deformiert. Direkt über den ausgefallenen Säulen ist das obere Stockwerke leicht durchgebogen, aber ansonsten bleibt der kippende Gebäudeteil im Fallen merkwürdig stabil. So verhalten sich einstürzende Gebäude dieser Größe normalerweise nicht. Man sieht zum Beispiel beim Einsturz des World-Trade-Center-Südturms WTC 2, dass der oberste Gebäudeteil zwar im ersten Moment in einem Stück kippt, sich aber schon bei einem sehr kleinen Winkel in seine Einzelteile auflöst und als 100.000 Tonnen schwere Trümmerwolke zu Boden stürzt.

Auf Metabunk sammelt Mick West unter anderem Informationen über Hulseys Berechnungen, auch mit der Unterstützung der anderen Forumsteilnehmer. Dazu hat West unter anderem die Folien aus einer Präsentation von Hulsey zur Vorstellung seines „Entwurfs“ vergrößert und als zweites Video zur Verfügung gestellt. Diese Präsentation ist interessant, weil sie nicht nur Animationen zu Hulseys Berechnungen enthält, sondern auch Ansichten, die im Entwurf selbst nicht vorkommen. In dieser Präsentation sieht man, dass die Gebäudestruktur in Hulseys kippender Simulation sogar bei weitaus größeren Neigungswinkeln noch vollkommen unbeeinträchtigt zu sein scheint:

WTC 7 verfügt also in Hulseys Berechnung über eine höchst erstaunliche innere Stabilität. Dass der Erdboden in der Berechnung nicht existiert, das Gebäude also im Boden versinken kann, ist für die eigentliche Fragestellung in der Tat unerheblich. Entscheidend ist jedoch die Frage: War das wirkliche WTC 7 auch so stabil? Die Antwort gibt Hulsey in seiner Präsentation unfreiwillig selbst. Mit einer Gegenüberstellung einer eigenen Animation zu einem Video vom 11. September will er offenbar zeigen, dass das abstürzende Gebäude in seiner Simulation ähnlich schnell fällt wie die abstürzende Fassade von WTC 7 im Video. Wozu das gut sein soll, erschließt sich mir nicht – niemand dürfte bezweifeln, dass er in seinen Berechnungen die korrekte Gravitationskonstante verwendet hat. In dem Video sieht man jedoch deutlich, wie sich während des Einsturzes von WTC 7 nicht nur die Dachkante, sondern auch die darunterliegenden Stockwerke in der Mitte der Nordfassade um mehrere Meter tiefer befinden als an den Seiten. Die Mitte der Gebäudefront beginnt Sekundenbruchteile früher abzustürzen als die Seiten und fällt daher auch schneller. Auf anderen Videos sieht man außerdem, dass die Fassade schon in den Sekunden vor dem Einsturz (und damit vor der von Hulsey unterstellten Sprengung) deutlich vor- und zurückschwankt und Fenster zerbrechen. Während das Gebäude also von außen noch weitgehend aussieht wie ein massives Objekt, hat es seine innere Stabilität längst verloren und die größeren Strukturelemente wie Fassadensäulen sind nur noch vergleichsweise locker miteinander verbunden, während sie unter ihrem eigenen Gewicht nebeneinander her in die Tiefe stürzen. In Hulseys Simulation bildet das Gebäude jedoch weiterhin einen kein bisschen deformierten monolithischen Block, der einfach wie ein Bauklotz nach unten wegsackt.

Was in der Simulation weiter unten passiert, wo dieser Bauklotz ja mit dem darunterliegenden Gebäudestumpf kollidieren muss, zeigt Hulsey vermutlich aus gutem Grund weder in seinem „Entwurf“ noch in der Präsentation.

Die von Hulsey selbst mit verächtlichem Stöhnen vorgeführten NIST-Simulationen entsprechen der auf Videos zu sehenden inneren Instabilität des einstürzenden Gebäudes weitaus realistischer, wenngleich die einzelnen Bewegungen der Fassade möglicherweise nicht in jedem Detail getroffen werden. Alle Details in einer Simulation zu reproduzieren, ist bei einem solchen chaotischen Prozess schlicht unmöglich – Hulseys Simulation ist jedoch nicht chaotisch, weil sich sein Gebäude beim Einsturz überhaupt nicht verformt. Obwohl Hulsey die eigentlichen Daten zu seiner Simulation nicht veröffentlicht hat, kann man also schon aus ihren Ergebnissen deutlich erkennen, dass sein simuliertes Gebäude eine unglaubliche Formstabilität hat, die das tatsächliche Gebäude nicht hatte. Die Ursache dieser Fehler zu finden, ist Hulseys Aufgabe. Bis dahin macht es jedoch genau diese Formstabilität unmöglich, aus Hulseys Simulation irgendwelche Schlussfolgerungen zu ziehen, aus dem Einsturz welcher Säulen sich ein Einsturz eines Gesamtgebäudes in welcher Form ergeben sollte. Mehr noch: Die unrealistische Formstabilität betrifft nicht die senkrechten Säulen des Gebäudes selbst, sondern vor allem die horizontalen Verbindungen zwischen diesen Säulen. Da diese horizontalen Verbindungen vor allem aus den Etagenböden mit ihren Trägern und Fußbodenelementen bestehen, muss man auch Hulseys Simulationen zur Stabilität dieser Bodenkonstruktionen und damit ihre Rolle beim Beginn des Einsturzes mit großem Zweifel betrachten. Anders ausgedrückt: Hulseys Berechnungen beschreiben ein fiktives Gebäude, das mit der am 11. September zu beobachtenden tatsächlichen Stabilität von WTC 7 nur wenig Gemeinsamkeiten hat. Somit ist es fraglich, ob man aus Hulseys Modell überhaupt irgendetwas über den Einsturz von WTC 7 lernen kann.

Das ist noch lange nicht alles

Diese grundlegenden Probleme in den Ergebnissen von Hulseys merkwürdiger Modellierung sind, unabhängig von der Methodik durch die sie entstanden sind, eigentlich hinreichend, um keine weitere Zeit mehr darauf zu verschwenden und den ganzen „Entwurf“ in dem Müll zu werfen. Es ist daher durchaus verständlich, wenn Sie auch keine weitere Zeit auf diesen Artikel verschwenden möchten. Die Forumsteilnehmer bei Metabunk haben jedoch auch eine ganze Anzahl systematischer Probleme in Hulseys Methodik gefunden, sofern diese aus dem, was er öffentlich macht, überhaupt nachvollziehbar ist. Diese Probleme möchte ich hier nur der Vollständigkeit halber stichpunktartig aufführen:

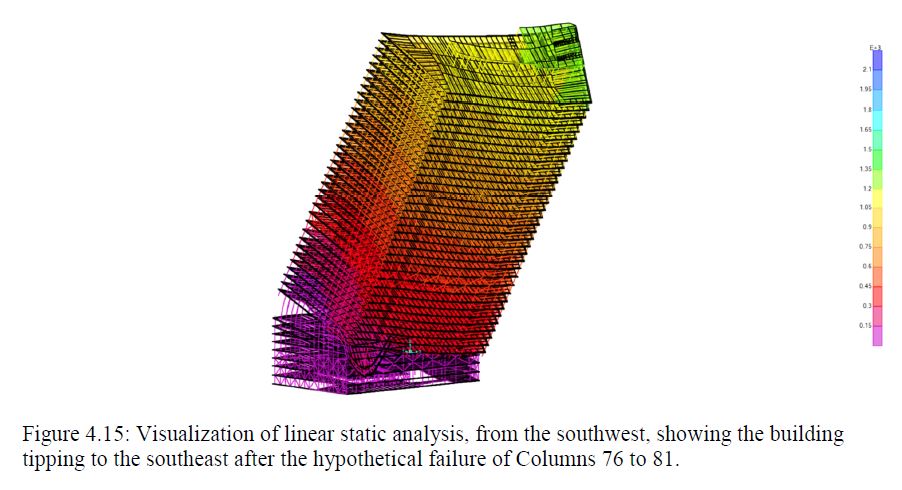

- In der Bildunterschrift zu diesem Ausschnitt aus dem „Entwurf“ erklärt Hulsey, das Bild sei das Ergebnis einer „linear-statischen Analyse“. Linear heißt in diesem Zusammenhang, dass das Modell voraussetzt, dass wie bei einer Sprungfeder die doppelte Kraft auf ein Bauteil auch die doppelte Verformung auslöst. Eine nichtlineare Analyse würde auch berücksichtigen, dass Bauteile bei zu großer Belastung irgendwann brechen oder dass ein Teil, wenn es gegen ein anderes gedrückt worden ist, nicht weiter nachgeben kann. Statisch bedeutet, dass das Modell nur unveränderliche Kräfte wie Gewichte oder Federkräfte berücksichtigt. Ein dynamisches Modell müsste auch kurzzeitige Kräfte berücksichtigen, die zum Beispiel beim Aufschlag eines fallenden Teils auf ein anderes entstehen. Eine linear statische Analyse ist auf ein einsturzgefährdetes Gebäude also nur anwendbar, bis das erste Bauteil anfängt, sich zu bewegen. Den Verlauf eines Einsturzes mit einem linear statischen Modell zu berechnen, ergibt zwangsläufig vollkommenen Müll. Bei anderen Darstellungen spricht Hulsey zwar von einer dynamischen Analyse, erwähnt aber nicht, ob diese auch die nötigen nichtlinearen Effekte berücksichtigt. Der Begriff der Nichtlinearität kommt in seinem Entwurf nur in dem Zusammenhang vor, dass einzelne Verbindungen in einem ansonsten linearen Modell als „nichtlineare Federn“ modelliert sind.

Screenshot aus Hulseys Entwurf, Seite 106 - Hulsey erklärt im Entwurf und in der Präsentation ausdrücklich, das „Versagen“ von Säulen im Gebäude sei dadurch modelliert worden, dass diese Säulen über jeweils acht Stockwerke aus dem Modell entfernt worden seien. Ob dieses Versagen auch zum Einsturz benachbarter Säulen führt, leitet er dann nur daraus ab, wieviel zusätzliches Gewicht diese Säulen nach dem Wegfall der Nachbarn tragen müssen. So kommt er zu der Schlussfolgerung, das vom NIST als Beginn des Einsturzes identifizierte Einstürzen von drei Säulen im Gebäudekern hätte unmöglich den Einsturz der benachbarten Säulen und schließlich des gesamten Gebäudes nach sich ziehen können. Eine brechende Stahlsäule (mit Sprengung oder ohne) löst sich aber nicht in Luft auf: In der Regel knickt sie zur Seite ein. Im ungünstigsten Fall trifft sie dabei eine der benachbarten Säulen und knickt diese ebenfalls ab. Aber selbst im günstigsten Fall, dass der obere Teil der Säule einfach neben dem Stumpf des unteren abgleitet, entstehen über die Querverbindungen wie Deckenträger und Fußböden erhebliche seitwärtige Zugkräfte auf die benachbarten Säulen. Solche 190 Meter hohen und nur 60 cm dicken Säulen (bezogen auf die Länge eines Streichholzes entspricht das gerade der Dicke von zwei menschlichen Haaren) können zwar extreme Gewichtskräfte in senkrechter Richtung aufnehmen, sind aber sehr anfällig gegen Kräfte von der Seite. Die absehbaren Folgen sind in Hulseys Modell nicht enthalten, vermutlich weil sie eben eine nichtlinear-dynamische Analyse erfordert hätten, wie sie das NIST vorgenommen hat.

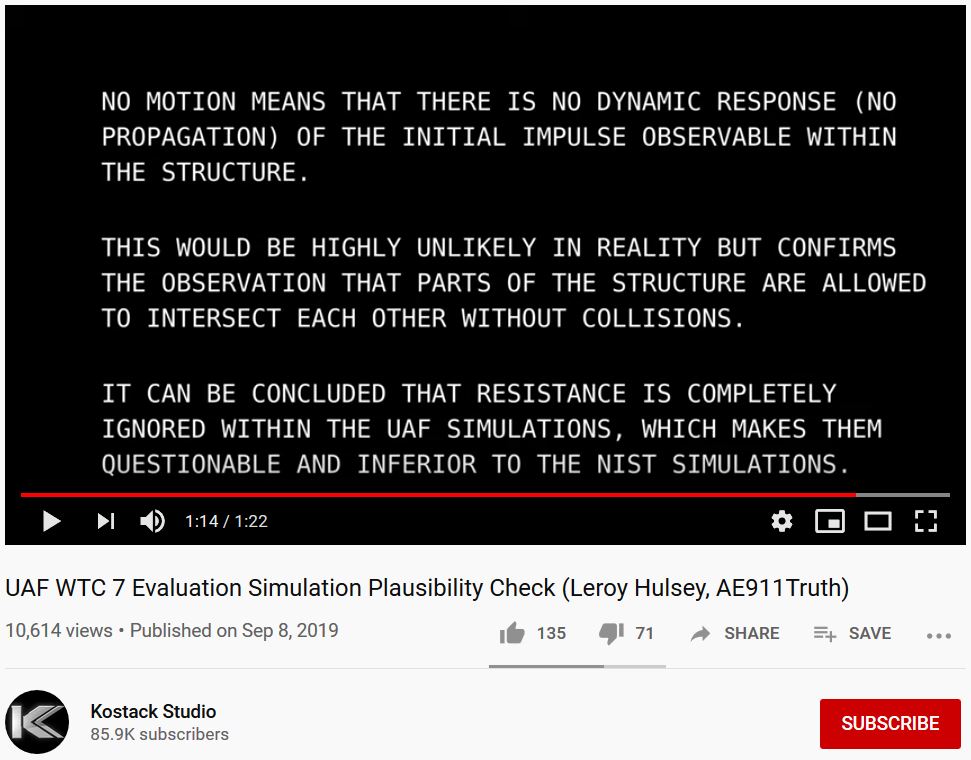

- Aufgrund dieser Angaben im Text und in Hulseys Vortrag sowie der präsentierten Resultate geht der Metabunk-Autor Mick West davon aus, dass Hulseys Berechnungen überhaupt keine tatsächliche dynamische Analyse enthalten. Das würde auch die bemerkenswerte innere Stabilität der simulierten Gebäudestruktur erklären: In diesem Fall würde sich das Gebäude nicht verformen, weil diese Verformungen schlicht nicht berechnet werden. Aufgrund der Ergebnisse einer statischen Berechnung (Überlastung bzw. Entfernen tragender Säulen) wäre der über der Schadenstelle liegende Gebäudeteil einfach gemäß der im ersten Moment herrschenden Kräfte entweder zur Seite gekippt oder senkrecht im Boden versenkt worden. In diesem Fall wäre Hulseys „Simulation“ natürlich eine reine Farce und eine bewusste Täuschung der Öffentlichkeit. Tendentiell bestätigt wird Wests Mutmaßung durch eine Videoanalyse einzelner Bildpunkte, nach der sich die einzelnen Strukturelemente in Hulseys Animationen nicht nur sehr wenig, sondern tatsächlich gar nicht bewegen:

Screenshot aus einem Analysevideo zu Hulseys Animationen, Anklicken zum Ansehen des Videos - Wests Vermutung würde auch ein extrem seltsames Verhalten des östlichen Penthauses in Hulseys Simulation erklären. Hulsey unterstellt ja, um den Einsturz dieses Dachaufbaus überhaupt erklären zu können, die Zerstörung von drei inneren Säulen in einem der obersten Stockwerke mehrere Sekunden vor der Zerstörung aller Säulen auf Höhe der unteren Stockwerke. Während nach der NIST-Simulation (im Bild unten auf der linken Seite) das Penthaus einfach dem schon einstürzenden Gebäudekern folgt, zerbricht es bei Hulsey (rechts) in zwei große Teile, die durch mehrere noch intakte Betondecken und deren Stahlträger hindurch abstürzen, aber dann ein paar Stockwerke weiter mehr oder weniger in ihrer ursprünglichen Form steckenbleiben. Dabei handelt es sich beim Penthaus um eine im Vergleich zu anderen Teilen des Gebäudes relativ leichte Konstruktion. Das kann nicht das Ergebnis einer Simulation sein, die Kollisionen zwischen den einzelnen Bauteilen des Penthauses und den durchflogenen Betondecken berechnet. Damit stellt sich natürlich die Frage, was Hulseys „Simulation“ überhaupt berechnet.

Screenshot aus Mick Wests Analysevideo zu Hulseys Präsentation, Anklicken zum Ansehen des Videos - West verweist in seiner Analyse gleich auf mehrere Stellen in Hulseys Text und Vortrag, an denen er die NIST-Simulation in einer Weise kritisiert, die nur dadurch zu erklären ist, dass Hulsey die Arbeit des NIST nicht verstanden hat oder nicht verstehen will. So verwendet er einen beträchtlichen Teil seines Textes darauf, das Abrutschen eines einzelnen Trägers vermeintlich zu widerlegen, den das NIST beispielhaft als einen möglichen Auslöser des letztlichen Einsturzes modelliert hatte. Im NIST-Gesamtmodell des Einsturzes ist dieser Träger für den Ablauf jedoch gar nicht entscheidend. An anderer Stelle kritisiert Hulsey unterschiedliche Strukturen zwischen unterschiedlichen Gebäudeteilen in der NIST-Simulation. Die feiner aufgelöste Struktur für einen Gebäudeteil diente jedoch nur für eine Detailanalyse innerhalb dieses Teils. Bei der Simulation des Gesamteinsturzes wurde das komplette Gebäude mit einer einheitlichen Simulationsstruktur berechnet.

Zusammenfassend muss man sagen, dass Hulseys Modell, was immer es tatsächlich intern tut, offensichtlich völlig ungeeignet ist, um daraus irgendwelche Rückschlüsse auf die Vorgänge am 11. September 2001 zu ziehen. Es beschreibt eine Phantasiewelt, die grundlegendsten Gesetzen der Mechanik widerspricht, in der komplexe Gebäude sich verhalten wie massive Klötze und Stahlträger durch Betonplatten fallen, ohne dabei auch nur abgelenkt zu werden. Man muss auch eigentlich kein Bauingenieur sein, dass einem diese Fehler geradezu ins Auge springen, und Hulsey darf sie aufgrund seiner Qualifikation und Erfahrung eigentlich unmöglich übersehen. Offen bleibt jedoch, ob es sich bei seiner Vorstellung um ein bewusstes politisch motiviertes Täuschungsmanöver handelt (weil möglicherweise eine realistischere Berechnung nicht das gewünschte Ergebnis gebracht hat) oder ob er es einschließlich seiner beiden Doktoranden tatsächlich nicht besser hinbekommen hat.