Regelmäßige Leser meines Blogs wissen ja, dass ich eine Tendenz zu einer gewissen, äh, Ausführlichkeit habe… Wer also direkt zu meiner Meinung zum aktuellen Problem der Covid-Impfung für Kinder und Jugendliche kommen möchte, kann einfach zur entsprechenden (nämlich der letzten) Zwischenüberschrift vorspringen. Wer wissen möchte, warum ich die aktuelle, fragwürdige Haltung der Ständigen Impfkommission (STIKO) dazu nicht für einen Zufall, sondern für den Ausdruck eines grundsätzlich problematischen Wissenschaftsverständnisses halte, sollte sich Zeit für den ganzen Text nehmen.

Von einem engagierten Skeptiker und gelegentlichen Unterstützer des Informationsnetzwerks Homöopathie sollte man eigentlich eine Eloge auf die „evidenzbasierte Medizin“ erwarten. Und natürlich lege ich tatsächlich großen Wert darauf, dass die Methoden der Medizin auf soliden wissenschaftlichen Ergebnissen beruhen. Ärzte oder Apotheker, die mir unter Berufung auf ihre subjektive Erfahrung Homöopathie, Anthroposophische „Medizin“, Akupunktur oder ähnliche überteuerte Placebos als wirksame Medizin verkaufen wollen, dürfen sich gerne andere Kunden suchen.

Mein Problem mit der „evidenzbasierten Medizin“ hat auch nicht wirklich etwas mit den Anführungszeichen zu tun, die dem einen oder anderen aufgefallen sein dürften. Die benutze ich einfach nur deshalb, weil es sich bei dem Begriff ganz vorsichtig ausgedrückt um eine ziemlich unglückliche Übersetzung des englischen evidence-based medicine (EBM – ich kann es mir immer noch nicht verkneifen, bei dem Kürzel erst mal an electronic body music zu denken) handelt, basierend auf dem, was man in der Sprachwissenschaft einen falschen Freund nennt. Auch wenn es dasselbe Wort zu sein scheint, Evidenz (also die Offensichtlichkeit eines Sachverhalts) bedeutet etwas anderes als evidence (Beweise). Wenn evidence in der medizinischen Wissenschaft evident wäre, könnte man sich einen großen Teil der Literatur zur EBM sparen.

Ich möchte der EBM auch nicht die Serie von haarsträubenden Stellungnahmen zur Pandemiepolitik ankreiden, die das „Netzwerk evidenzbasierte Medizin“ auf Betreiben seines inzwischen endlich zurückgetretenen damaligen Vorsitzenden Andreas Sönnichsen abgegeben hat. Darin hat sich kein grundsätzliches Problem der EBM gezeigt, sondern schlichtweg die Tatsache, dass auch wissenschaftliche Vereinigungen nicht davor gefeit sind, sich faktenresistente Querulanten in den Vorstand zu holen – und dann mitunter überraschend lange brauchen, um sie wieder loszuwerden. Letzteres dürfte in vielen Fällen damit zu tun haben, dass man dann wieder einen neuen Dummen (m/w/d) finden muss, der bereit ist, den in der Regel unbezahlten Vorstandsposten zu übernehmen.

Um auch das noch vorwegzuschicken: Ich weiß natürlich, dass ich mich als Nichtmediziner mit diesem Artikel auf relativ dünnes Eis begebe. Es ist immer problematisch, als fachfremde Person einen zumindest scheinbaren Konsens der Experten eines Themas hinsichtlich Methoden oder Inhalten ihres Fachgebiets zu kritisieren. Nachher kommt noch jemand auf die Idee, mich mit Clemens Arvay zu vergleichen, was ich wirklich gruselig fände. Ganz so gewagt, wie sie auf den ersten Blick scheint, ist meine Kritik allerdings nicht: Vom Grundsätzlichen her geht es nämlich nicht um originär medizinische Themen, sondern um allgemeine Fragen der Wissenschaftlichkeit und des Umgangs mit Wissenslücken, und in den konkreten Einzelfragen gibt es eine ganze Reihe von Medizinern, medizinischen Fachwissenschaftlern und sogar engagierte Verfechter der EBM, die dieselben Kritikpunkte vorbringen.

Was mich stört, ist, dass es unter Vertretern der EBM eine Tendenz gibt, Patientenstudien zum Maß aller Dinge zu machen und andere Informationen schlicht zu ignorieren. Beispiele dafür kommen gleich – einen Moment Geduld bitte noch. Rein menschlich ist das völlig verständlich. Gerade bei vielen Medizinern in der medizinischen Wissenschaft (in der zum Beispiel auch Physiker, Chemiker, Biologen und Mathematiker tätig sind) besteht ihre Forschungstätigkeit fast ausschließlich aus Patientenstudien. Ein großer Teil der wissenschaftlichen Diskussionen in der EBM beschäftigt sich mit den Fragen, wie eine gute Patientenstudie aussehen sollte und wie man aus einer Vielzahl in der Regel nicht übereinstimmender Patientenstudien die richtigen Schlüsse zieht. Wenn man sich den ganzen Tag damit beschäftigt, die perfekten Klebstoffe zu entwickeln, kann man leicht den Blick dafür verlieren, dass man manche Dinge doch besser einfach festschraubt.

Die perfekten Klebstoffe der EBM sind nach heutigem Stand randomisierte, doppelblinde, placebokontrollierte Studien (randomized controlled trial, RCT) sowie nach klar festgelegten Regeln durchgeführte Metaanalysen aus vielen einzelnen Patientenstudien. Beides sind in langjährigen wissenschaftlichen Diskussionsprozessen ausgefeilte, trickreiche Methoden, um bekannte Fehlerquellen beim Experimentieren mit Menschen zu minimieren.

Wer die Methodik solcher Studien und die dadurch berücksichtigten Fehlerquellen schon gut kennt und auf den Punkt kommen möchte, kann gerne bis zur folgenden Zwischenüberschrift („Wo ist also das Problem?“) vorspringen. Da diese Methoden der EBM aber tatsächlich ziemlich genial sind und immer noch viel zu oft ignoriert werden, möchte ich sie an dieser Stelle doch noch einmal kurz rekapitulieren. Zunächst einmal, welche Probleme kann man bei der Durchführung einer einzelnen Patientenstudie durch eine RCT vermeiden?

- Gesundheitliche Parameter eines Menschen ändern sich im Zeitverlauf von ganz allein; vor allem viele Krankheiten bessern sich zumindest zeitweilig. Um die Wirkung einer bestimmten Maßnahme erkennen zu können, taugt ein vorher-nachher-Vergleich also nicht. Man muss eine behandelte mit einer unbehandelten Patientengruppe vergleichen (kontrollierte Studie).

- Begleitumstände einer Maßnahme wie die Aufmerksamkeit und Zeit behandelnder Personen, der Weg zur Behandlung oder die Einnahme eines Mittels können nicht nur die wahrgenommene Gesundheit, sondern auch objektiv messbare Parameter beeinflussen. Die Begleitumstände sollten also zwischen behandelter Gruppe und Kontrollgruppe möglichst identisch sein (Placebokontrolle).

- Das Wissen, ob man zur behandelten oder zur Kontrollgruppe gehört, beeinflusst nicht nur die Wahrnehmung, sondern auch das Verhalten und letztlich messbare Parameter wie Blutdruck oder Hormonspiegel. Die Probanden dürfen das also während der Studie nicht wissen (Verblindung).

- Wenn Mitarbeiter der Studie, die Probanden behandeln oder die Ergebnisse erheben, wissen, wer zu welcher Gruppe gehört, können sie, auch unbewusst, unterschiedlich mit den Probanden umgehen oder die Ergebnisse verzerren. Wer mit den Probanden oder mit den Daten einzelner Probanden zu tun hat, sollte die Gruppenzuordnung also ebenfalls nicht kennen (Doppelverblindung).

- Jede systematische Zuordnung der Probanden zur behandelten oder der Kontrollgruppe (Ort, Zeit, Krankenhausstation…) kann zu einem ungewollten Einfluss auf die Ergebnisse führen. Man muss diese Zuordnung also auslosen (Randomisierung).

Diese Maßnahmen definieren den Standard bei den erwähnten RCTs, die nach heutigem Stand die verlässlichste Form sogenannter Interventionsstudien (also Studien, bei denen man den Effekt einer kontrollierbar einzusetzenden Maßnahme untersucht) sind. Wenn man den zu untersuchenden Einfluss zum Zeitpunkt der Studie nicht (mehr) kontrollieren kann, dann ist man auf Beobachtungsstudien angewiesen. Diese sind zwangsläufig fehleranfälliger als RCTs. Auch hier hat die EBM allerdings Handwerkszeug, um die unvermeidlichen Fehler wenigstens einigermaßen im Griff zu halten. So kann ein case matching, also eine 1:1-Zuordnung von Probanden mit gleichen Eigenschaften den Effekt der Randomisierung in Teilen ersetzen. Will man also zum Beispiel den Krankheitsverlauf bei trotz Impfung erkrankten Covid-Patienten mit dem bei Ungeimpften vergleichen, dann würde man jeweils Patienten gleichen Alters und Geschlechts gegenüberstellen. Da das matching zwangsläufig unvollständig ist (man kann in der Regel nicht auch noch sämtliche einzelnen Vorerkrankungen, Rauchverhalten, sozialen Status und Freizeitgestaltung gegenüberstellen), hat aber auch dieses Verfahren Grenzen.

Schließlich versucht die EBM in aller Regel, ihre Schlussfolgerungen nicht nur aus einer einzelnen Studie zu ziehen. Da unterschiedliche Studien zur selben Fragestellung sich in der Regel in ihrer Methodik und in ihren Ergebnissen unterscheiden, nutzt man systematische Reviews um ein Gesamtbild der relevanten Datenlage zu bekommen. Als verlässlichste Form eines solchen Gesamtbilds gelten Metaanalysen, in denen die Daten aus vielen Patientenstudien statistisch zusammengeführt werden. Hierzu gibt es Regeln, nach denen die Qualität unterschiedlicher Studien bewertet und unzureichende Studien ausgeschlossen werden. RCTs haben danach einen höheren Wert als kontrollierte Studien ohne Verblindung, Beobachtungsstudien oder Einzelfallbeschreibungen, große RCTs einen höheren Wert als solche mit nur wenigen Probanden. Bei Metaanalysen gibt es sogar statistische Methoden, die berücksichtigen und in Teilen kompensieren können, dass Studien mit negativem oder uneindeutigem Ergebnis häufig nicht publiziert werden. Gründe für diesen sogenannten publication bias können darin liegen, dass Forschende eine Bestätigung für ihre eigenen Überzeugungen erhoffen und Studien ohne solches Ergebnis eher selbst für fehlerhaft halten – sie erhalten aber auch als Forschungsleistung allgemein weniger Anerkennung und werden mitunter auch als Doktorarbeit oder ähnliche Qualifikationsleistung nicht angenommen. Effektiv verhindert wird ein solcher publication bias aber nur bei den Zulassungsstudien für neue Arzneimittel. Dafür muss eine Studienbeschreibung mit Umfang, Methoden und Zielgrößen vor Studienbeginn öffentlich einsehbar registriert werden, so dass es nicht möglich ist, eine ganze Studie oder einzelne Auswertungen darin unbemerkt verschwinden zu lassen.

Wo ist also das Problem?

Angesichts dieses umfangreichen Instrumentariums, um Fehler bei Patientenstudien zu eliminieren, wo ist dann das Problem damit, sich bei medizinischen Fragen ganz an Patientenstudien orientieren zu wollen? Schließlich geht es in der Medizin immer darum, was Patienten hilft.

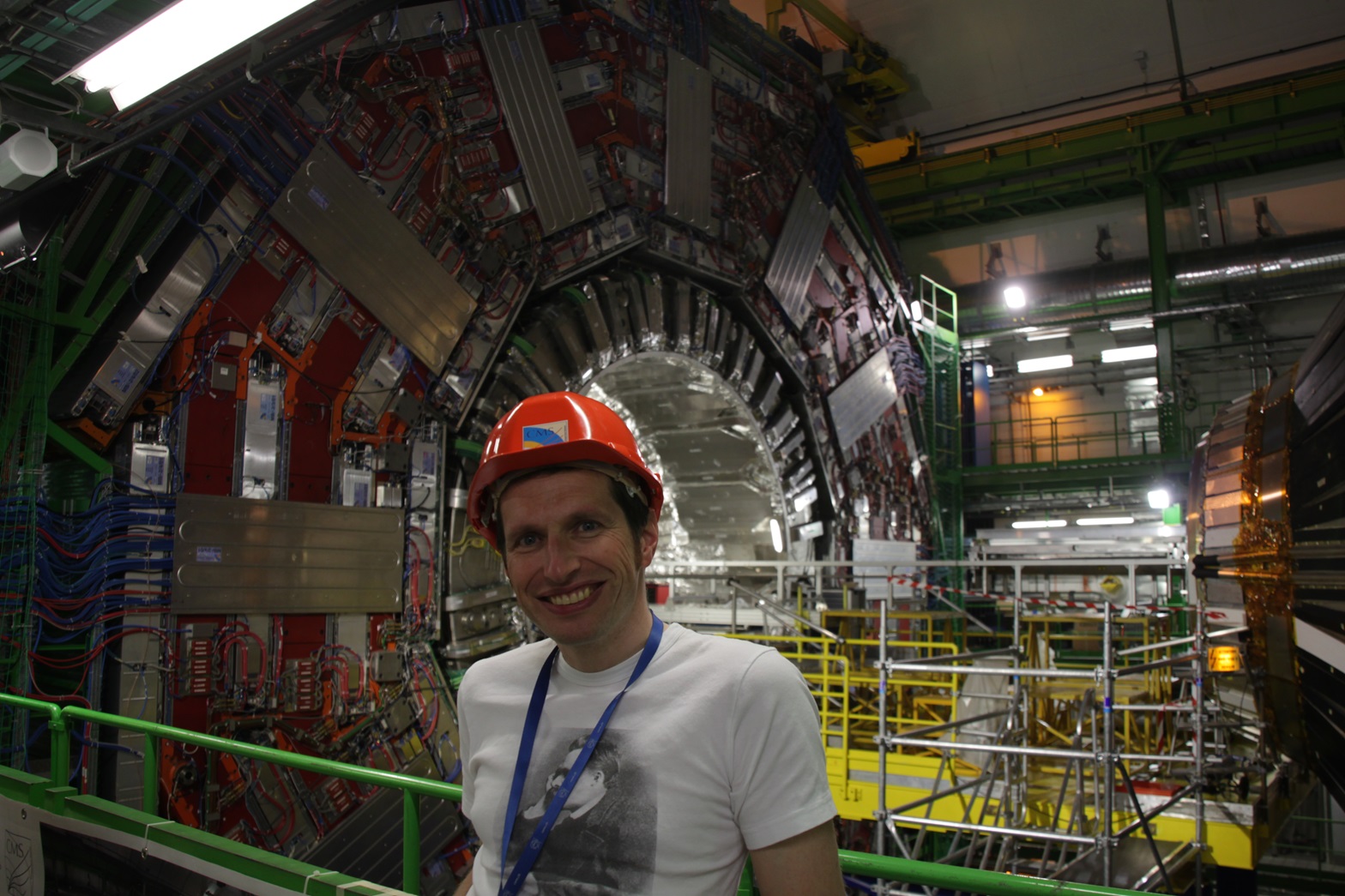

Im Spätsommer des Jahres 2000, in den letzten Wochen vor der Stillegung des damals leistungsstärksten Beschleunigers am CERN, des Large Electron Positron Collider (LEP), wurde die Strahlenergie über die normale Leistungsgrenze der Beschleunigerelemente hinaus gesteigert. Das Ziel war, ohne Rücksicht auf mögliche Schäden an der bereits ausgereizten Anlage doch noch einen Blick zu wenigstens etwas höheren Energien zu erhaschen und dort möglicherweise neue Teilchen zu entdecken. Tatsächlich meldeten im September 2000 mehrere Detektoren an dem Beschleuniger ungewöhnliche Ereignisse, entsprechend der Entdeckung eines neuen Teilchens der Masse 113 GeV und mit Eigenschaften passend zum lange gesuchten Higgs-Teilchen. Insgesamt wurden mehr als dreimal so viele dieser Ereignisse entdeckt als aufgrund der Streubreite des Untergrundrauschens durch Zufälle zu erwarten gewesen wäre – ein sogenannter 3-Sigma-Effekt. Die Messungen hätten damit ohne ein neues Teilchen nur mit einer Wahrscheinlichkeit von weniger als 1:300 zufällig zustande kommen können. Die Leitung des CERN verlängerte auf Bitten der Experimente den Betrieb des Beschleunigers noch um wenige Wochen. Als die Daten dann noch nicht genauer waren, wurde die Anlage stillgelegt, um Platz für den 2010 in Betrieb genommenen Large Hadron Collider (LHC) zu schaffen. Ein 3-Sigma-Effekt lockt in der Teilchenphysik niemanden hinter dem Ofen hervor. Damit man von der Entdeckung eines neuen Teilchens ausgeht, braucht man mindestens einen 5-Sigma-Effekt, wie er nur mit einer Wahrscheinlichkeit von 1:3,5 Millionen zufällig zustande kommt. Und die Zweifler hatten Recht: Als am 4. Juli 2012 das CERN erklärte, am LHC sei endlich das Higgs-Boson gefunden worden, lag seine Masse bei 125 GeV und damit weit außerhalb der Reichweite des LEP. Das mysteriöse Teilchen bei 113 GeV, das in den letzten Wochen des LEP beobachtet worden war, existiert nicht.

Was hat diese kleine Geschichte aus der jüngeren Historie der Teilchenphysik mit Patientenstudien zu tun? In der Medizin, aber auch in der Psychologie gilt ein 2-Sigma-Effekt, der immerhin mit einer Häufigkeit von 1:20 einfach durch Zufall auftreten kann, als „statistisch signifikant“ und als akzeptierter Beleg für die Existenz eines Effekts, also zum Beispiel für die Wirksamkeit eines Arzneimittels. Heute wissen wir auch aus der Praxis sehr sicher, dass alle gegen Covid-19 zugelassenen Impfstoffe extrem wirksam sind, aber bei der Zulassungsstudie für den Impfstoff von AstraZeneca gab es eine Gewissheit, dass der Schutz durch den Impfstoff besser als 50% ist, auch nur auf dem Niveau eines 2-Sigma-Effekts. Dieses schnelle Akzeptieren eigentlich noch recht unsicherer Ergebnisse ist kein Zeichen schlechten wissenschaftlichen Arbeitens, sondern ergibt sich mit einer gewissen Zwangsläufigkeit aus dem Untersuchungsgegenstand. Echte, lebende Menschen sind so ungefähr der beschissenste Untersuchungsgegenstand, mit dem Wissenschaftler zu tun haben können. Sie sind nicht nur komplexe biologische Systeme; sie wissen auch, dass sie Teil einer Untersuchung sind und beeinflussen absichtlich und unabsichtlich das Ergebnis. Man kann auch nicht wie in der Teilchenphysik einfach die Zahl der Versuche erhöhen, um statistisch belastbarere Aussagen zu bekommen. Selbst wenn man im Prinzip genug Patienten hätte – wenn eine Therapie in einer Studie „statistisch signifikant“ gezeigt hat, dass sie für kranke Menschen erhebliche Vorteile bietet und vielleicht lebensrettend ist, wird kaum eine Ethikkommission erlauben, dass man einer Placebogruppe diese Therapie noch vorenthält, nur um noch einmal zu überprüfen, ob die Ergebnisse dieser ersten Studie auch wirklich stimmen. Natürlich gibt es auch bei Untersuchungen an Patienten immer wieder Ergebnisse, die auch statistisch sehr, sehr eindeutig sind. So war vom BioNTech/Pfizer-Impfstoff schon bei der Zulassung klar, dass seine Wirksamkeit gegen symptomatische Erkrankungen mit sehr hoher Wahrscheinlichkeit über 90% und mit absoluter Sicherheit über 80% liegt. Auch dass die Infektionssterblichkeit von Covid (der ursprünglichen Variante, aktuelle sind gefährlicher) bei der in Deutschland vorliegenden Altersstruktur der Bevölkerung nicht wie von Querdenkern gerne behauptet bei 0,3%, sondern bei fast 1% liegt, ist mit einer Wahrscheinlichkeit von eins zu Milliarden sicher. So eindeutige Ergebnisse sind aber in Patientenstudien nicht unbedingt die Regel. Das liegt zum Teil auch einfach daran, dass Forschung an menschlichen Probanden sehr teuer ist und es gerade bei selteneren Krankheiten nicht einfach ist, viele geeignete Patienten zu finden, die auch noch bereit sind, an einer Studie teilzunehmen.

Zu diesen statistischen Problemen, die sich wenigstens halbwegs solide beziffern lassen, kommt eine ganze Reihe von systematischen Verzerrungen, die sich aus der Arbeit mit Menschen ergeben. Die offensichtlichsten Probleme werden durch gute Randomisierung zu statistischer Streuung umgewandelt – das schützt aber nicht vor absichtlicher Manipulation durch Beteiligte der Studie. Bei Interessenkonflikten, die Anlass zu solchen Manipulationen bieten können, denken die meisten Menschen zuerst an finanzielle Faktoren, zum Beispiel wenn Studien von Pharmaunternehmen finanziert werden. Diese sind jedoch veröffentlichungspflichtig und leicht nachvollziehbar. In Gesundheitsfragen, gerade bei der Forschung an Patienten, gibt es jedoch noch ganz andere Interessenkonflikte. So kann Ärzten, die an einer Patientenstudie beteiligt sind, unter Umständen das Wohlergehen ihrer eigenen Patienten näher liegen als ein wissenschaftlich sauberes Ergebnis der Studie insgesamt. Auch Querdenkerprofessoren wie John Ioannidis oder Luc Montagnier dürften bei ihren haarsträubenden Pseudostudien zur Pandemie oder ihrer Desinformation über Impfungen zumindest in einigen Fällen der Überzeugung gewesen sein, das Beste für die Menschheit zu bezwecken, auch wenn ihnen eigentlich klar gewesen sein muss, dass ihre Aussagen wissenschaftlich lächerlich sind.

Ein besonderes Problem in Patientenstudien ist der richtige Umgang mit Probanden, die ihre Beteiligung an der Studie vorzeitig abbrechen. Da eine solche Entscheidung neben externen Faktoren auch von fehlender Wirkung oder auftretenden Nebenwirkungen beeinflusst sein kann, lässt sich dieses Problem nicht durch Randomisierung und Verblindung in den Griff bekommen. Die korrekte Berücksichtigung solcher Studienaussteiger hängt daher von der exakten Fragestellung ab und ist entsprechend umstritten. Weitere Probleme, darunter eins, das in der Pandemie auftauchte, eine unüberschaubare Zahl viel zu kleiner, unkoordinierter und dadurch auch in der Summe wenig aussagekräftiger Studien zu sich überlagernden Themen, wurden im Mai in einem Artikel in Nature thematisiert.

Die Methoden, die im Rahmen der EBM für Patientenstudien entwickelt wurden, sind also nicht etwa das Nonplusultra der Wissenschaftlichkeit, sondern eher eine Krücke, die es ermöglichen soll, unter ausnehmend schwierigen Bedingungen wenigstens halbwegs belastbare Ergebnisse zu liefern. Letztlich können Patientenstudien selbst bei sorgfältigster Durchführung nicht die Verlässlichkeit guter Labordaten erreichen. Sie bleiben aber unverzichtbar, weil in der Medizin bei rein laborbasierten Studien immer die Frage der Übertragbarkeit auf das Gesamtsystem Mensch bleibt. In der Zulassung neuer Arzneimittel ist das kein Widerspruch: Bei neuen Substanzen, die heute als Arzneimittel zugelassen werden, sind die zugrundeliegenden chemischen Reaktionen verstanden, die Wirkung in der einzelnen Zelle ist im Labor mit höchster Genauigkeit geprüft, und die Übertragbarkeit auf einen Gesamtorganismus ist Tierversuchen nachgewiesen worden, bevor überhaupt die erste Patientenstudie genehmigt werden kann. In den klinischen Studien der Phasen II und III, in denen die Wirksamkeit nachzuweisen ist, geht es also nur noch darum, zu zeigen, dass das, was im Reagenzglas, in der einzelnen Zelle und im Tiermodell funktioniert, im Menschen auch noch funktioniert. Das ist nicht selbstverständlich, und auch hier müssen immer wieder Wirkstoffkandidaten aufgegeben werden, aber der verbleibende Schritt ist relativ klein. Nur deshalb ist es vertretbar, ein Arzneimittel schon nach zwei „statistisch signifikanten“ Patientenstudien (die unter Umständen auch in eine große Studie zusammengefasst werden können) für wirksam zu erklären.

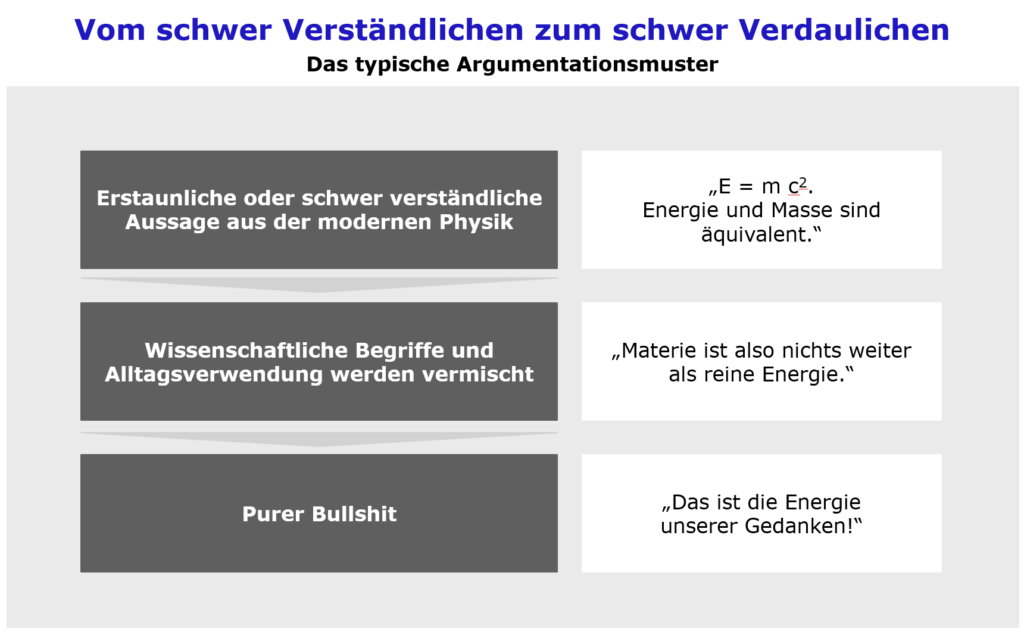

Ganz anders sieht es aus, wenn Sachaussagen mit wissenschaftlichem Anspruch ausschließlich mit Studien am Menschen begründet werden, wie das neben der Medizin auch in der Psychologie oft unvermeidbar ist. Man kann und muss das mitunter tun, nur darf man dabei eben nicht das wackelige Fundament einer solchen Methodik vergessen. Genau das liest man aber immer wieder auch bei Vertretern der EBM, womit ich jetzt endlich bei meinen Beispielen bin.

Die sogenannte Alternativmedizin

2013 forderte Christian Weymayr unter dem Begriff der Scientabilität und damals konkret mit Bezug auf die Homöopathie, Patientenstudien nur dann durchzuführen, wenn die zu prüfende Wirkung nicht im Widerspruch zu sicheren wissenschaftlichen Erkenntnissen steht. Eine ähnliche Stoßrichtung hatte die Forderung nach einer science based medicine anstelle der heutigen evidence based medicine, die 2014 von den amerikanischen Medizinern David Gorski und Steven Novella erhoben wurde. Kritik an diesen eigentlich selbstverständlichen Forderungen hagelte es nicht nur von Vertretern antiwissenschaftlicher Positionen wie Harald Walach, sondern auch von namhaften Vertretern der EBM wie Heiner Raspe und Jutta Hübner, bizarrerweise sogar aus der Skeptikerszene. Eine Zusammenfassung der Diskussion um die Scientabilität findet sich in der Homöopedia. Selbst gestandene Naturwissenschaftler sind immer wieder bereit, sich auf Patientenstudien als einzigen Beleg einer Wirkung einzulassen. So betonte der von mir sehr geschätzte 2020 verstorbene Physikprofessor Martin Lambeck immer wieder, wie viele Nobelpreise nicht nur für Medizin, sondern auch für Physik und Chemie fällig wären, wenn diverse alternativmedizinische Verfahren wirksam sein sollten. In seinem Buch „Irrt die Physik?“ schlug er, um diese zu testen, jedoch ausgerechnet Patientenstudien vor. Ich bezweifle allerdings, dass Martin Lambeck es tatsächlich für sinnvoll gehalten hätte, einen Nobelpreis für Physik auf der Basis von Patientenstudien zu vergeben.

Selbstverständlich macht es für die Aussagekraft einer Patientenstudie einen erheblichen Unterschied, ob sie nur die Anwendbarkeit gesicherter Laborergebnisse im Menschen bestätigt (wie bei der Arzneimittelzulassung), ob sie Thesen prüft, die naturwissenschaftlich unbelegt, aber im Prinzip möglich sind (das gilt für viele Naturheilverfahren), ob das zu prüfende Verfahren an sich wirken könnte, aber auf einer komplett unsinnigen Theorie fußt (wie Ayurveda oder die „traditionelle chinesische Medizin“ samt der Akupunktur) oder ob schon die Wirkung selbst durch Naturgesetze ausgeschlossen ist, wie bei homöopathischen Hochpotenzen oder der Geistheilung. Keine Ansammlung noch so vieler Patientenstudien kann Naturgesetze widerlegen. Natürlich können wir auch Naturgesetze falsch verstanden haben. Natürlich können Physik und Chemie falsch oder grob unvollständig sein. Dafür müsste aber sehr, sehr, sehr vieles in der Natur ganz zufällig gerade so herauskommen, als wären unsere Naturgesetze eben doch fast immer richtig. Um das zu überprüfen, wären Studien am Menschen aber ein vollkommen untaugliches Mittel.

Eine Wirksamkeit der Homöopathie und damit die Ungültigkeit von Naturgesetzen aus Patientenstudien belegen zu wollen, ist ungefähr so sinnvoll, als wolle man die Bahn des Mondes aus Messungen der Gezeiten am Meer berechnen: Man kann das irgendwie machen, aber es ist so ziemlich das untauglichste Mittel, das man sich vorstellen kann, wenn das Ergebnis wesentlich verlässlicheren Methoden widerspricht. Das absurd klingende Beispiel ist übrigens nicht ganz willkürlich gewählt: 1692 berechnete Edmond Halley basierend auf Gezeitenmessungen an der englischen Küste, Newtons Mechanik und seinen eigenen Messungen von Mondbahn und Monddurchmesser die Dichte der Erde im Verhältnis zu der des Mondes und kam zum Ergebnis, dass die Erde innen hohl sein müsse.

Die HPV-Impfung

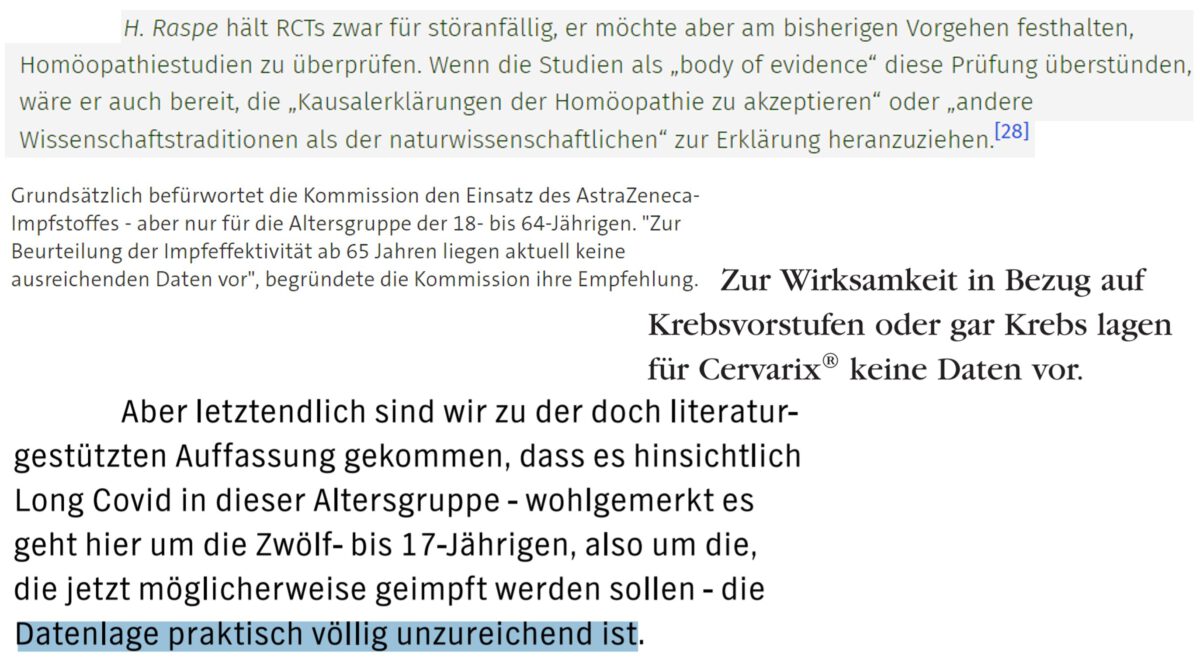

2008 forderte eine Gruppe angesehener Medizinprofessoren eine Rücknahme der Empfehlung der Ständigen Impfkommission (STIKO), Mädchen gegen menschliche Papillomaviren (HPV) zu impfen, „und ein Ende der irreführenden Information“. Zu den Unterzeichnern des Aufrufs gehörten mit Norbert Schmacke und dem heutigen Leiter des Instituts für Qualität und Wirtschaftlichkeit im Gesundheitswesen (IQWiG) Jürgen Windeler auch prägende Vertreter der EBM in Deutschland. HPV verursachen Genitalwarzen und ähnliche Zellveränderungen auf Schleimhäuten und sind in der Folge für einen großen Teil der oft tödlich verlaufenden Erkrankungen mit Gebärmutterhalskrebs verantwortlich. Zwei Impfstoffe (Gardasil und Cervarix) verhindern eine Infektion mit den HPV-Untertypen, die am häufigsten für Gebärmutterhalskrebs verantwortlich sind (und wie man inzwischen weiß auch recht gut mit anderen Untertypen). Die Argumentation des Aufrufs basierte darauf, dass zu diesem Zeitpunkt die Wirksamkeit der Impfung nur gegen Krebsvorstufen nachgewiesen war. Ein direkter statistischer Nachweis, dass geimpfte Frauen weniger Tumore bekommen, war noch nicht erbracht. Das lag aber nicht an den Impfstoffen, sondern einfach an der Natur der Sache: Geimpft wurden damals weibliche Jugendliche von 12 bis 17 Jahren (sinnvollerweise vor dem ersten Geschlechtsverkehr, weil die Viren sexuell übertragen werden), und das mittlere Erkrankungsalter für Gebärmutterhalskrebs liegt bei 52 Jahren. Für den direkten Nachweis hätte man also einfach nur sehr lange warten müssen, während mehr junge Frauen ungeimpft geblieben, mit HPV infiziert worden und später an Krebs gestorben wären. Was die Zulassungsbehörden in allen entwickelten Ländern und eben auch die STIKO stattdessen getan haben, war, die Informationen aus Patientenstudien zur Wirkung der Impfstoffe mit anderen Patientenstudien und Laborforschung über die Entwicklung der Krebszellen zusammenzufassen und entsprechende Schlüsse zu ziehen.

Ich bin kein Mediziner. Ich war damals tatsächlich neugierig und hätte gerne von jemandem vom Fach eine Erklärung gehabt, wie denn nach Meinung der Unterzeichner des Aufrufs die Tumore plötzlich trotzdem entstehen sollten, wenn die Viren, von denen sie ausgelöst werden, und die Krebsvorstufen, aus denen sie entstehen, nicht mehr da sind. Auf diese Frage konnte mir Professor Windeler in einem E-Mail-Wechsel keine nachvollziehbare Antwort geben. Stattdessen kam von ihm ein Beharren darauf, dass nach den Regeln der EBM ein direkter Wirksamkeitsnachweis in Patientenstudien erforderlich sei, um die Impfung empfehlen zu können.

Ich weiß, hinterher ist man immer klüger. Ich weiß, es hätte irgendeine (zwangsläufig extrem seltene, weil weder in den Zulassungsstudien noch in den ersten zwei Jahren der Anwendung entdeckte) schwere Nebenwirkung der Impfungen geben können. Ich weiß, die Tumore hätten durch irgendeinen verrückten Mechanismus auch ohne die Viren und die Krebsvorstufen entstehen können. Ich weiß nur bis heute nicht, wie man das damals für wahrscheinlich oder für entscheidungsrelevant halten konnte. Inzwischen, da wir klüger sind, wird die Impfung nicht nur für Mädchen schon im Alter von 9 bis 14 Jahren empfohlen, sondern auch für Jungen – weil die Impfstoffe so gut vertragen werden, weil dadurch auch ungeimpfte Frauen geschützt werden können, weil auch Peniskrebs und sogar der häufige Prostatakrebs mit HPV in Verbindung gebracht werden und weil eben auch Genitalwarzen bei Männern nicht toll sind.

Die Forderung nach dem „Ende der irreführenden Information“ schlug damals hohe Wellen durch die deutschen Publikumsmedien. Sie verunsicherte Eltern, die eine Impfentscheidung für ihre Töchter und später auch für ihre Söhne hätten treffen müssen. Sie verunsicherte aber auch die Politik, die sich nie zu systematischen Impfkampagnen in den Schulen, wie ich sie aus meiner Kindheit gegen Polio kenne, aufraffen konnte. 2018 lag die Impfquote gegen HPV unter 15jährigen Mädchen in Deutschland bei erbärmlichen 31%. An unverbesserlichen Impfgegnern lag das nicht: Die agitieren viel stärker gegen die Masernimpfung, und dort hatten wir bei der Einschulung schon vor der Einführung der Impfpflicht 2020 Impfquoten um 95% mit zwei Impfungen und über 98% Erstimpfungen.

Inzwischen kommen immer mehr Daten aus der realen Anwendung, die zeigen, wie wichtig es gewesen wäre, schon vor 12 Jahren weitaus konsequenter gegen HPV zu impfen, aus Australien, aus Finnland (wo inzwischen auch eine direkte Wirkung der Impfung gegen Tumore nachgewiesen ist), aus Schweden… Und während es in den USA, Großbritannien, Kanada, Australien und Skandinavien längst völlig normal ist, dass Jugendliche unabhängig vom Geschlecht gegen HPV geimpft werden, werden in Deutschland in 20 oder 30 Jahren Frauen mittleren Alters an Tumoren sterben, die sie nicht haben müssten.

AstraZeneca für Senioren

Die Absurditäten, die unter Berufung auf die EBM verbreitet wurden, haben in der Pandemie einen neuen Höhepunkt erreicht; wieder geht es um Impfstoffe, nur anders als 2008 ist es dieses Mal die STIKO selbst mit ihrem jetzigen Vorsitzenden Thomas Mertens, die einseitig den Patientenstudien verfallen ist.

Der Covid-Impfstoff von AstraZeneca (Vaxzevria/ChAdOx1/AZD1222) wurde am 29.1.2021 in der EU zugelassen. Schon einen Tag vorher hatte die STIKO die Empfehlung abgegeben, den neuen Impfstoff nur für die Altersgruppe unter 65 und damit nicht für die am meisten gefährdete Risikogruppe über 80 einzusetzen. Der Grund für die kuriose Empfehlung waren nicht etwa konkrete Bedenken. Die Begründung war schlichtweg die hier schon bekannte: Zur Wirksamkeit in dieser Altersgruppe gäbe es in den Zulassungsstudien keine hinreichenden Daten für einen direkten Nachweis. Der STIKO waren schlicht zu wenige Senioren in den Studien. Etwas zugespitzt hätte man mit derselben Begründung empfehlen können, den Impfstoff nicht für Rothaarige, für Linkshänder oder für Beamte zu verwenden.

Es ist natürlich bekannt, dass ein Immunsystem im hohen Alter nicht mehr so gut lernt, sich an neue Bedrohungen anzupassen, was auch den Effekt von Impfungen reduziert. Man wusste aber aus Laboruntersuchungen in den frühen klinischen Studienphasen, dass durch alle drei zu diesem Zeitpunkt zugelassenen Impfstoffe eine robuste Immunreaktion auch bei alten Probanden erzeugt wurde, und von den beiden anderen Impfstoffen wusste man auch aus dem direkten Nachweis an Probanden, dass diese Immunreaktion auch alte Menschen vor einer Erkrankung schützt. Es gab keinen vernünftigen Grund für die Annahme, dass die Altersabhängigkeit der Wirkung bei dem AZ-Impfstoff anders sein sollte. Die Empfehlung basierte ausdrücklich nur auf dem Fehlen eines direkten Nachweises durch zu wenige alte Probanden in den Studien.

Die STIKO-Empfehlung trug auch dazu bei, dass das durch Verzögerungen und die (nach der Papierform) etwas geringere Wirksamkeit bereits beschädigte Image des AZ-Impfstoffs weiter geschwächt wurde. Einer der wichtigsten Erfolgsfaktoren für eine Impfkampagne, das Vertrauen der Bevölkerung in die Sicherheit und Wirksamkeit der eingesetzten Impfstoffe, wurde leichtfertig aufs Spiel gesetzt. Die fragwürdige Stellungnahme von Deutschlands wichtigstem Expertengremium zu diesem Thema befeuerte auch die haltlosen Gerüchte, der AZ-Impfstoff sei bei älteren nur zu 8% wirksam (tatsächlich stammte die absurde Zahl daher, dass in den Zulassungsstudien nur 8% der Probanden über 65 war).

Ich weiß, hinterher ist man immer klüger. Niemand konnte zu diesem Zeitpunkt wissen, dass der psychologische Schaden noch viel größer werden würde. Niemand konnte wissen, dass gerade der AZ-Impfstoff möglicherweise in sehr seltenen Fällen zu ernsten Nebenwirkungen in Form von Sinusvenenthrombosen führen könnte, die, wie es aktuell aussieht, vor allem junge Menschen betreffen könnten – ausgerechnet die jungen Menschen, die gerade in Deutschland ganz überwiegend mit AZ geimpft wurden, weil die STIKO sich gegen eine Anwendung bei alten Menschen ausgesprochen hatte. Das konnte niemand wissen.

Was man aber wissen konnte: Zu diesem Zeitpunkt hatten in Deutschland weniger als zwei Millionen Menschen eine Erstimpfung gegen Covid erhalten, erst rund 500.000 waren voll geimpft. Der weit überwiegende Teil der über 80jährigen hatte noch nicht einmal einen Impftermin. In Hessen waren viele Impfzentren noch gar nicht eröffnet. Die Intensivstationen waren noch voll von der zweiten Welle; in Großbritannien wütete die Alpha-Variante, und jeder (außer vielleicht den Ministerpräsidenten der Bundesländer) konnte wissen, dass uns durch Alpha eine üble dritte Welle bevorstand. Die Nutzung der AZ-Impfung für Jüngere mag dazu geführt haben, dass die eine oder andere Pflegekraft früher geschützt war – für die (nach der eigenen Analyse der STIKO) am dringendsten zu schützenden Personen hat die STIKO die Aussicht auf einen Impftermin aber weiter nach hinten geschoben. So sind unnötig viele alte Menschen ungeschützt in die dritte Welle geraten, und auch wenn sich das nach den strengen Regeln der EBM nicht wird beziffern lassen – es müssen unnötig viele dadurch gestorben sein.

Covid-Impfung für Jugendliche

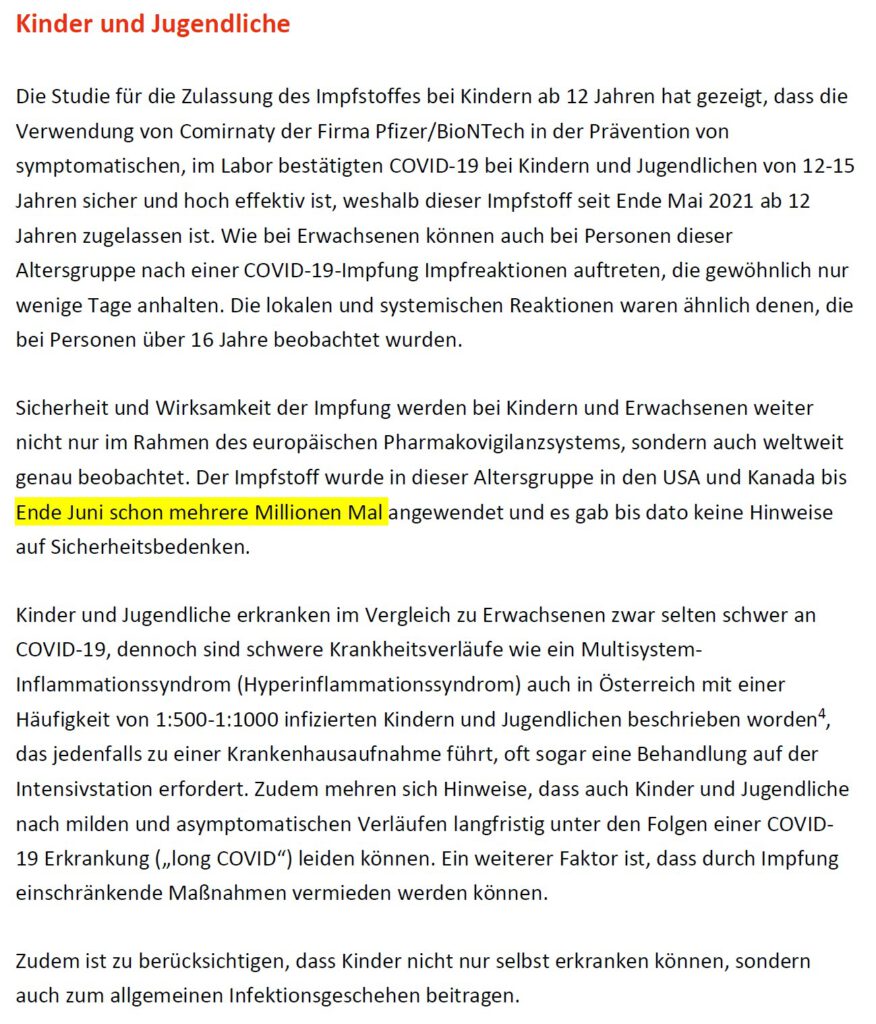

Am 31.5. genehmigte die Europäische Kommission auf Empfehlung der europäischen Arzneimittelagentur (EMA) den Einsatz des ersten Covid-Impfstoffs (Comirnaty von BioNTech/Pfizer) für Jugendliche ab 12 Jahren. Zu diesem Zeitpunkt war der Impfstoff in den USA bereits seit drei Wochen bei Jugendlichen im Einsatz, mit dem erklärten Ziel, die entsprechende Altersgruppe bis zum Ende der Sommerferien möglichst flächendeckend geimpft zu haben. Schon in den ersten Medienberichten über die Zulassung tauchten jedoch Gerüchte auf, in Deutschland werde die STIKO den tatsächlichen Einsatz der Impfung für Jugendliche nicht empfehlen.

Einen Tag später erschien die bislang wohl skurrilste Folge des NDR-Podcasts Coronavirus Update. Die Frankfurter Virologin Sandra Ciesek und die aus diversen Folgen mit Ciesek und Christian Drosten erfahrene NDR-Journalistin korinna Hennig versuchten mit mäßigem Erfolg, ihre Fassungslosigkeit zu überspielen, als der als Gast zugeschaltete STIKO-Vorsitzende Thomas Mertens die zu diesem Zeitpunkt noch nicht einmal offiziell beschlossene Entscheidung seines Gremiums verteidigte. Auch wenn das sicherlich nicht Mertens‘ Absicht war – seine Argumentation wäre auf der Bühne einer Querdenker-Demo nicht sonderlich aufgefallen.

5.7.21: Angesichts Mertens‘ aktueller Äußerungen zum Testen von Schülern würde ich meine Einschätzung „Auch wenn das sicherlich nicht Mertens‘ Absicht war“ in Frage stellen. Das lässt auch Mertens‘ bizarre Äußerungen im NDR-Podcast, dass er die noch völlig ungetesteten Lebendimpfungen gegen Covid für sicherer hält als die inzwischen hunderte-millionenfach erfolgreich eingesetzten modernen Impfstoffe, in einem anderen Licht erscheinen. Letztlich muss man wohl einfach konstatieren, dass wir in der STIKO ein Personalproblem haben

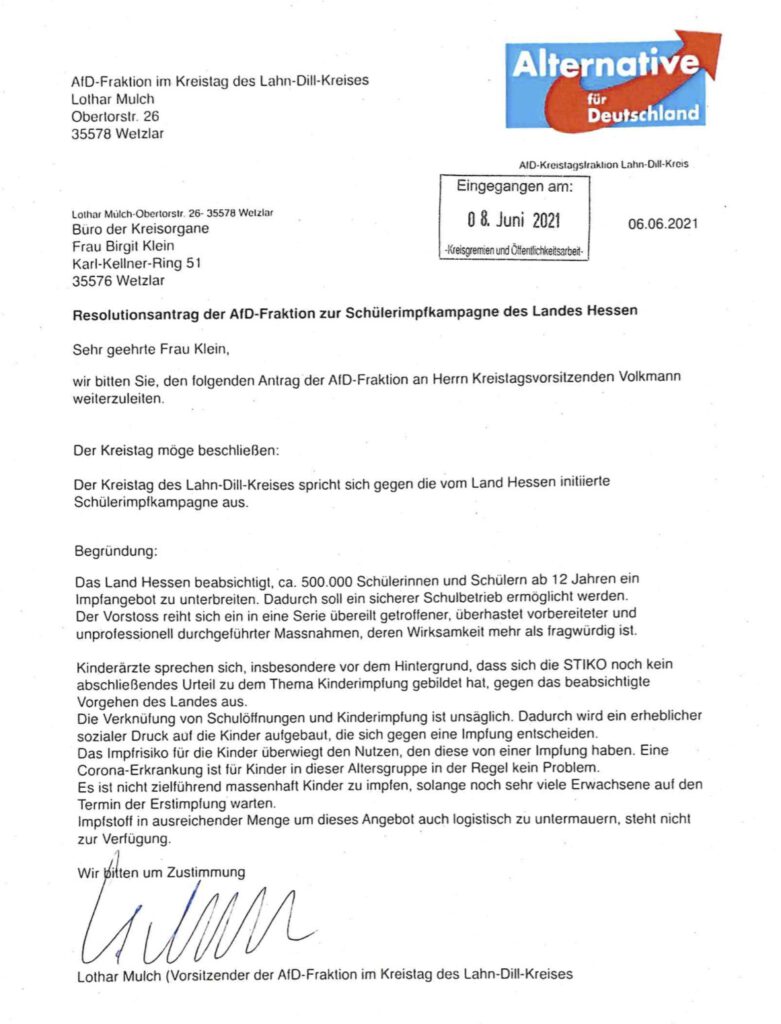

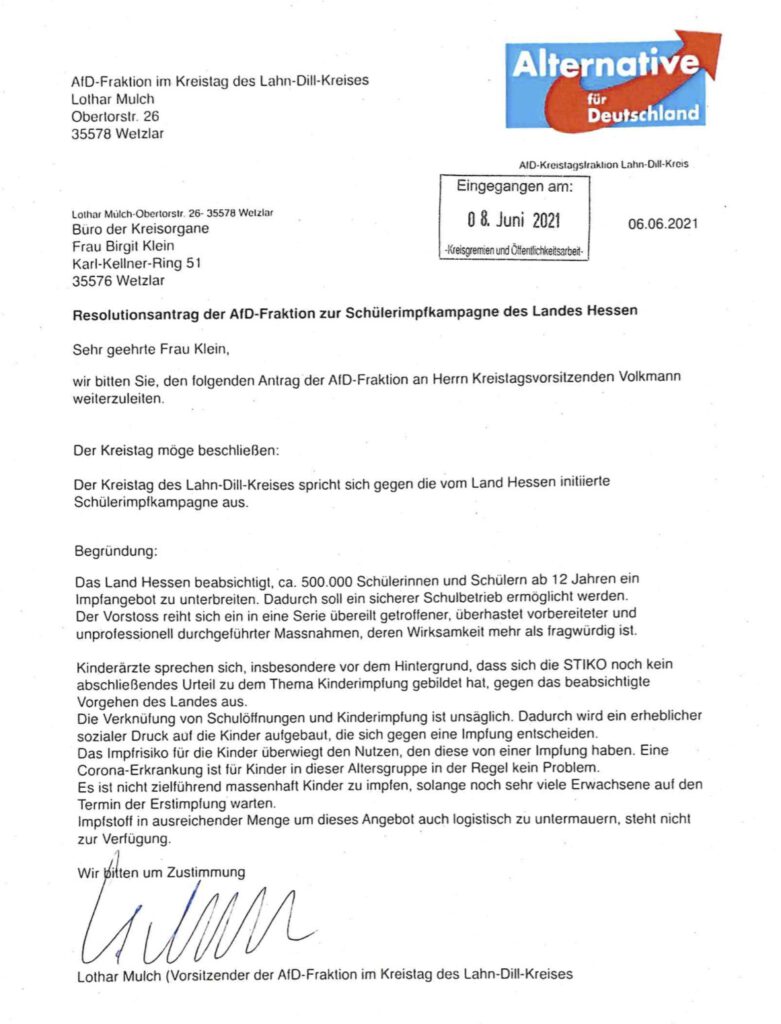

4.7.21: Inzwischen beruft sich, wenig überraschend, die AfD genüsslich auf diese Glanzleistung der STIKO:

So erklärte Mertens, sachlich nicht falsch, die in den Studien geimpften 1100 Jugendlichen seien zu wenig, um seltene Nebenwirkungen ausschließen zu können, blieb aber jede Antwort dazu schuldig, wie man einen solchen Nachweis denn erbringen könne, wenn nicht dadurch, dass man eben mehr Jugendliche impft. In der Praxis wird das dazu führen, dass dann eben amerikanische, israelische und britische Jugendliche das Versuchskaninchen für Mertens‘ Sicherheitsanforderungen sein werden, weil in diesen Ländern die wissenschaftlichen Berater realistischer sind. Weitaus schlimmer war aber Mertens‘ folgende Aussage: „So […] wissen wir natürlich, dass bestimmte Spätfolgen einer Impfung schon auch nach Monaten sehr selten natürlich, aber möglich sind.“ Praktisch alle Fachwissenschaftler und seriösen Wissenschaftskommunikatoren, die sich öffentlich zu Covid äußern, reden sich seit einem halben Jahr den Mund fusselig, dass es solche „Spätfolgen“ bei Impfungen noch nie gegeben hat und dass auch kein halbwegs plausibler Mechanismus vorstellbar ist, wie ein im Körper längst abgebauter Impfstoff solche Folgen haben könnte. Dass ausgerechnet der Vorsitzende der STIKO diesen Gerüchte-Zombie wieder aus der Impfgegner-Gruft wanken lässt, ist, gelinde gesagt, enttäuschend.

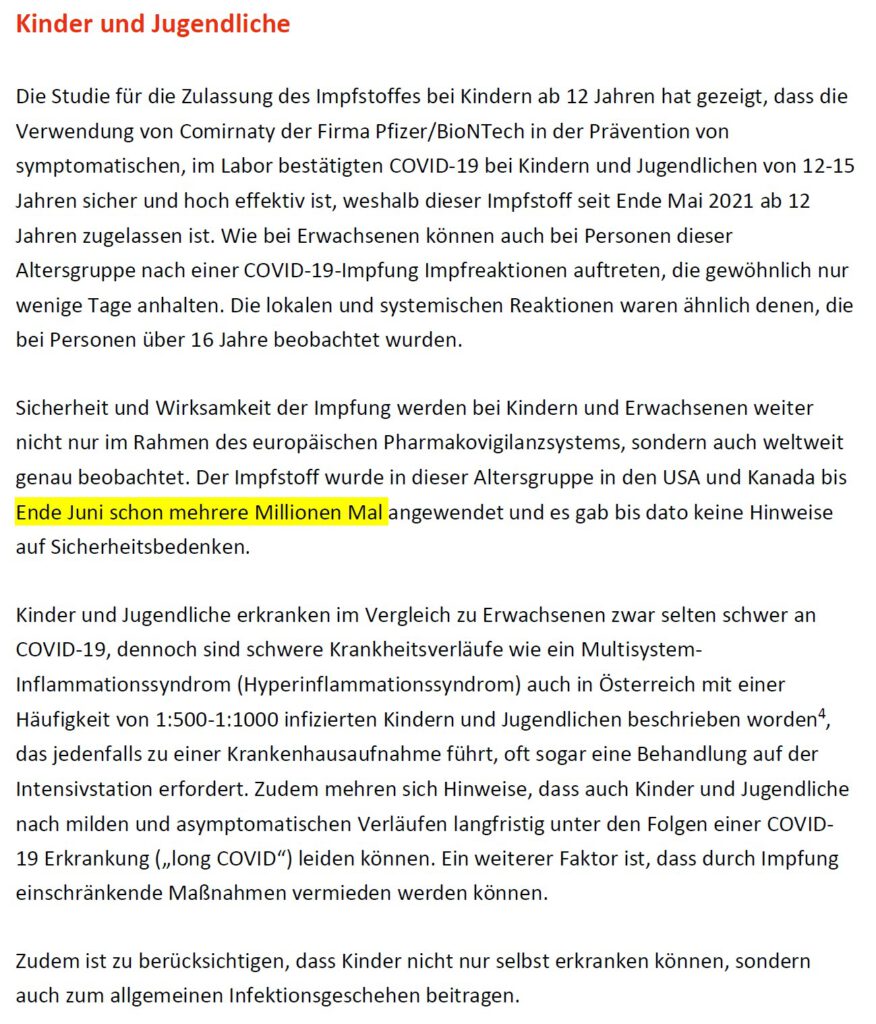

Während sich Mertens zu vollkommen hypothetischen (und zumindest zum Teil vollkommen unrealistischen) Nebenwirkungen also – sachlich nicht falsch – auf die unzureichende Datenlage beruft, stuft er die aus den USA berichteten, sehr seltenen Fälle von Myocarditis in zeitlicher Nähe zu einer Impfung als entscheidungsrelevant ein, obwohl ihm selbst klar ist, dass die Datenlage ebenfalls unzureichend ist, um zu beweisen, dass es da überhaupt einen kausalen Zusammenhang gibt. Erst mit den nach dem Podcast zusätzlich eingetroffenen Daten sprechen die amerikanischen Centers for Disease Control (CDC) inzwischen von einem „wahrscheinlichen Zusammenhang“, verweisen aber gleichzeitig auf die sehr kleine Zahl überwiegend harmloser Fälle. Am 11. Juni waren von 1226 Fällen von Myocarditis, die bei 300 Millionen Impfungen aufgetreten waren, fast alle schon wieder gesund. Nur neun waren noch im Krankenhaus, zwei auf Intensivstationen. Kurz gesagt präsentiert Mertens, unter Berufung auf die EBM, jede Wissenslücke und jede Unsicherheit als Argument fürs Nichtstun und vergrößert diese Wissenslücken noch, indem er, wie wir es hier jetzt schon mehrfach hatten, jede Überlegung beiseite wischt, die sich nicht unmittelbar aus Patientenstudien ergibt. Und, nochmal, ich kritisiere hier nicht als medizinischer Laie einen Konsens von Fachwissenschaftlern. Vielmehr ist es, wie zuvor bei der Altersempfehlung für den AZ-Impfstoff, die STIKO, die gegenüber internationalen Fachkreisen eine Außenseitermeinung vertritt. Die Experten der CDC kommen auch aufgrund der heutigen Datenlage zur exakt gegensätzlichen Einschätzung wie die STIKO. 5.7.21: Ebenso eindeutig ist die Einschätzung des Nationalen Impfgremiums, des Gegenstücks der STIKO in Österreich:

Auch in Frankreich werden nach einem entsprechenden Votum des wissenschaftlichen Beratergremiums seit dem 15.6. alle Jugendlichen ab 12 geimpft. In Israel läuft die Impfkampagne für Jugendliche ab 12 seit dem 6.6., in den Niederlanden seit dem 2.7.. Neben Deutschland zögert in Europa ausgerechnet UK, wo die Inzidenz von 257 (am 5.7.) nicht unbedingt eine Empfehlung für die dortige Seuchenpolitik abgibt.

So wie Mertens die Risiken der Impfung durchgängig zur Obergrenze des gerade noch Denkbaren abschätzt, erklärt er sämtliche Risiken der Krankheit, die nicht durch Patientenstudien an Jugendlichen eindeutig statistisch belegt sind, für nicht existent. Während ein aktueller britischer Artikel in The Lancet zur multisystemischen Entzündungserkrankung bei Kindern und Jugendlichen (PIMS) auf 26 Todesopfer in den USA sowie die noch ungeklärten Spätfolgen verweist und betont, wie wichtig es ist, die Infektionszahlen in diesen Altersgruppen niedrig zu halten, weiß Mertens: „Das Risiko für PIMS ist gering. Die Prognose ist gut.“ Seine Begründung ist einmal mehr, wie jetzt schon des Öfteren bei EBM-Vertretern aufgezeigt, der klassische Denkfehler des Argumentum ad Ignorantiam: Das Gegenteil lässt sich (noch) nicht beweisen. Dem gleichen Muster folgt er zu Long Covid, also den, für Erwachsene klar belegt, teilweise sehr hartnäckigen Spätfolgen einer Covid-Infektion: Die Datenlage bei Jugendlichen ist unzureichend, und damit ist das Thema abgehakt. Er schiebt dann noch das Scheinargument nach, dass ja nur wenige Kinder wegen Covid intensivmedizinisch behandelt werden müssten, obwohl er mit Sicherheit weiß, dass Long Covid bei Erwachsenen auch bei milden und sogar asymptomatischen Verläufen belegt ist. Dass die Datenlage bei Jugendlichen schlecht ist, überrascht nicht, wenn man bedenkt, dass typische, bei Erwachsenen gut verfolgbare, Long-Covid-Symptome wie Erschöpfung, Kopf- und Gliederschmerzen, Schlaf- und Konzentrationsstörungen bei Jugendlichen gerne auf Wachstum oder Pubertät geschoben werden. Man kann sich leicht vorstellen, dass dieselben Symptome, wenn sie zu alterstypischen Problem noch zusätzlich auftreten, auch für die weitere Entwicklung von Jugendlichen problematisch sein können. Wenn man über „die Datenlage ist unzureichend“ hinausschaut und versucht, das Beste aus den vorhandenen Daten herauszuholen, stellt man fest, dass das britische Statistikamt bei fast 10% der infizierten (nicht etwa nur der ernsthaft erkrankten) Kinder und Jugendlichen Langzeitfolgen meldet. Ob es, wie eine italienische Studie ausweist, sogar über 40% sind, kann man natürlich kritisch hinterfragen, aber eine unzureichende Datenlage heißt eben nicht 0%.

20.8.21: Inzwischen hat die STIKO viel zu spät ihre katastrophale Fehlentscheidung korrigiert und begründet das mit „neuen Erkenntnissen“. Wie neu die tatsächlich sind und was die Begründung der STIKO über Mertens‘ Medienauftritte in den letzten Monaten aussagt, habe ich mir in einem Kommentar unten in der Diskussion angesehen.

Ganz abgesehen von problematischen Auslegungen der EBM ist Mertens‘ Haltung, dass man Kinder und Jugendliche nur impfen dürfe, wenn für sie selbst der unmittelbare medizinische Nutzen eventuelle, hypothetische Risiken überwiegt, auch grundsätzlich problematisch. Bei sehr vielen (nicht allen) Impfungen liegt ein erheblicher Teil des Nutzens darin, durch Herdenschutz auch (noch) nicht impfbare oder trotz Impfung nicht geschützte Personen vor einer Infektion abzuschirmen. Warum dieser gesamtgesellschaftliche Nutzen nur innerhalb der eigenen Altersgruppe berücksichtigt werden soll, erschließt sich mir nicht, zumal natürlich auch mild erkrankte Kinder mitbetroffen sind, wenn ihre Eltern auf der Intensivstation oder ihre Großeltern auf dem Friedhof landen. Das ist auch eine ganz normale gesellschaftliche Praxis: Während der gesamten Pandemie wurde auch das Leben von Kindern eingeschränkt, um primär hochgradig gefährdete Ältere vor Covid zu schützen. Warum sollte dieses gesamtgesellschaftliche Handeln ausgerechnet bei einer Impfung enden, die letztlich alle schützt? Die nichtpharmazeutischen Maßnahmen, auch und gerade in Schulen, werden auch nicht mit den Sommerferien enden. Der Nachwuchs hat also durchaus auch ein über das rein Medizinische hinausgehendes Interesse an der Impfung: Indem wir Jugendliche und möglichst bald auch Kinder impfen, ersparen wir es ihnen, zweimal wöchentlich Unterrichtszeit für Antigentests zu verlieren und (wie die aktuellen Entwicklungen in schon stärker von der Delta-Variante betroffenen Ländern erwarten lassen) wahrscheinlich mehrfach pro Halbjahr wegen erkrankter Mitschüler unter Quarantäne gestellt zu werden.

Im Podcast hat Sandra Ciesek noch versucht, die Situation zu retten, indem sie betont hat, dass die Impfung von Kindern eine private Entscheidung ist und Eltern ihre Kinder natürlich auch ohne entsprechende Empfehlung der STIKO impfen lassen können. Zudem hat sich auch Mertens im Podcast die Hintertür offen gehalten, dass die STIKO ihre Empfehlungen anpassen kann, wird und das auch schon getan hat, wenn sich wissenschaftliche Erkenntnisse (oder vielmehr das, was er als wissenschaftliche Erkenntnisse akzeptiert) ändern. Insofern ist vorauszusehen, was passieren wird: Mit immer mehr Daten aus der Anwendungsbeobachtung in den USA, Israel und Großbritannien wird die STIKO wahrscheinlich eher früher als später umschwenken und doch eine Covid-Impfung für Jugendliche ohne Vorerkrankung und nach der entsprechenden Zulassung wahrscheinlich wieder mit einer unnötig langen Verzögerung auch für Kinder im Grundschulalter empfehlen. Der (einmal mehr) von der STIKO verursachte Vertrauensschaden wird sich aber auch hier nicht wiedergutmachen lassen. Verunsicherte Eltern sind das Schlimmste, was einer Impfkampagne passieren kann.

Tatsächlich hatte die STIKO zum aktuellen Zeitpunkt noch nicht einmal die geringste Notwendigkeit, diesen Flurschaden anzurichten. Sie hätte sich, wie es eigentlich ihre Aufgabe ist, überhaupt nicht öffentlich äußern müssen. Sie hätte die Frage der Impfung von Jugendlichen auch zurückstellen und sich problemlos noch mindestens sechs bis acht Wochen Zeit erkaufen können, wenn sie einfach nur gefordert hätte, den Impfstoff vor den gesunden Jugendlichen für alle impfbereiten Erwachsenen zu reservieren. Das wäre so oder so ohne jeden Zweifel die richtige Priorisierung gewesen. Damit hätte man noch bis irgendwann im August Zeit gehabt, eine Empfehlung abzugeben und hätte in vielen Bundesländern trotzdem noch vor Ende der Sommerferien mit einer Impfkampagne für Jugendliche starten können. Wahrscheinlich werden wir das so oder so tun, wenn die STIKO ihre Entscheidung ändert, was durchaus auch schon im August passieren kann – nur eben jetzt mit (zu Recht) völlig verunsicherten Eltern.

5.7.21: In dem Punkt muss ich meine Aussage revidieren. Anscheinend sind wir schon im Juli an dem Punkt, dass mRNA-Impfstoff nicht mehr knapp ist, weil die Impfbereitschaft sich insgesamt langsam ausschöpft. In dem Punkt freut mich die überraschend schnelle Bereitschaft der STIKO, für die AZ-Erstgeimpften eine Zweitimpfung mit einem mRNA-Impfstoff zu empfehlen. Interessanterweise ist auch hier der Wirksamkeitsvorteil nur in Labordaten zu erkennen, und direkte Informationen über die Sicherheit einer solchen heterologen Impfung sind kaum deutlicher als vor ein paar Wochen, als die STIKO das noch mit eben dieser Begründung abgelehnt hat. Das Argument der fehlenden Datenlage scheint bei der STIKO also recht selektiv zu greifen…

Ich persönlich hätte allerdings ohne mich zu beschweren die paar Wochen bis zum geplanten Zweittermin mit AZ (oder eben gegebenenfalls bis zur hinreichenden Verfügbarkeit von mRNA-Impfstoff) gewartet, wenn das notwendig gewesen wäre, um die Jugendlichen zu impfen. Da ganz offiziell genug da sein soll, habe ich die Gelegenheit aber auch genutzt und werde in Kürze heterolog geimpft sein. Da ist der lange Abstand nicht unbedingt erforderlich, weil man keine Gefahr einer Vektorimmunität hat.

Gesamtgesellschaftlich ist das aber ohnehin erst der zweite Schritt. Das nächste, was die Wissenschaftskommunikation in Deutschland zu leisten hat, ist vollkommen unabhängig von der Frage, wann und mit welcher Durchschlagskraft wir die Impfkampagne bei Jugendlichen starten, weil sie dafür ohnehin zu spät greift: Wir müssen den Schulpolitikern (schnellstmöglich) den Zahn ziehen, dass man nach den Sommerferien an den Schulen einfach zum Regelbetrieb zurückkehren kann, damit wir nicht wieder völlig unvorbereitet in ein Schuljahr voller Einschränkungen, Tests und Quarantänen rutschen.

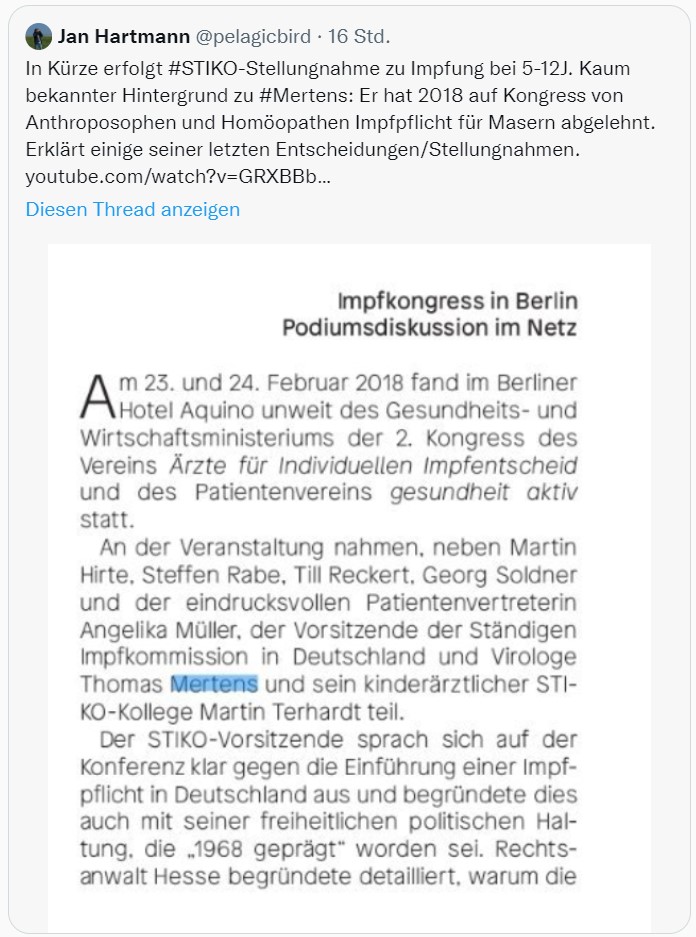

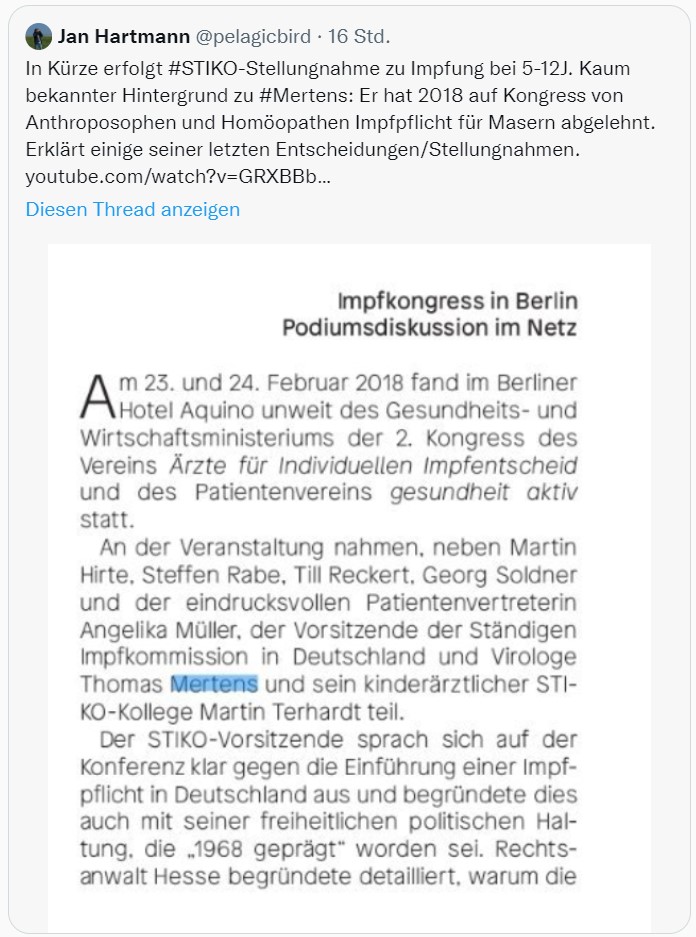

9.12.21: Ich muss meine beim Entstehen des Artikels noch eher differenzierte Sicht zu Thomas Mertens revidieren. Man erfährt doch immer wieder neues. Wer sich vor den Karren eines anthroposophischen Impfgegnervereins spannen lässt und auf einem Kongress mit Leuten wie Angelika Müller, Martin Hirte und Harald Walach auftritt, wie Mertens und sein Kollege Martin Terhardt, war als STIKO-Mitglied schon lange vor der Pandemie nicht mehr tragbar. Mit dem Wissen muss ich ganz nüchtern feststellen, dass das BMG bei der Ernennung mindestens dieser beiden wirklich den Bock zum Gärtner gemacht hat.

Der Screenshot stammt aus diesem (an seiner ursprünglichen Stelle nach dem Tweet von Jan Hartmann ganz plötzlich gelöschten) Dokument. Eine Übersicht von Rednern auf dem Impfgegnerkongress mit Verweis auf eine DVD mit Aufzeichnungen findet sich hier.